2018年云栖大会马云提出的数据科学时代(Data technology),相较于传统信息时代,技术的变更主要集中在过去我们更加看重的是传输,也就是传统的网络建设,随着目前国家网络建设的完善,数据传输量以及基于数据产生的经济价值越来越高。所有技术的发展都是围绕数据进行服务的。

云的发展主要经历了三个模式变化

(1)传统IT阶段:传统IT阶段实际上是没有云平台的参与的,所有的业务是全部都被部署到物理机上的,使用物理机进行业务的部署,用物理机进行业务部署会遇到很多相关的问题,比如说如果硬件架构出现问题如何解决、以及当业务需要迁移的时候,会需要停机。传统的业务架构就是基于BMC——操作系统——中间件——业务系统——用户流程实现的。

(2)Cloud-Base:基础云阶段,在基础的云应用阶段,用户使用云还是处于一个比较初级的阶段,用户可以选择云的IaaS/PaaS/SaaS服务进行业务系统的构建,大部分用户会选择ECS弹性云服务器进行自定义的系统构建,或者选择相关的SQL服务完成底层到中间件层级的业务构建,但是很少有用户会选择SaaS进行业务建设。这个阶段用户使用的主要是云的资源,用户会将自身的业务从传统架构迁移到云上,通过云服务的提供满足企业的各类需求,尤其是在弹性伸缩以及业务安全性保证平滑过渡这些需求上尤其的多。

在Cloud-Base阶段用户的数据会集中到云平台上,更加有利于用户进行数据的集中处理,另外使用云可以让用户的资源利用率相对提升,传统IT结构分配给用户的资源,是用户独享的,这样做就很容易造成资源的浪费,但是使用云架构之后,用户可以通过超分资源或者是精简分配的方法提升资源利用率,降低企业的整体TCO(总拥有成本)

但是使用基础的云架构还是有一定的问题的,比如和传统的架构一样,用户的业务上线慢、尤其是技术人员的视角在传统和基础云架构下更倾向于架构层面而不是业务层面,所以对于实际的业务运行来说,使用基础云架构相对还不是能满足一些大企业的快速上线的需求。

尤其是对于软件开发的人员来说,使用基础云架构的整体思想和软件开发的设计思想实际上是有一定的差距的,随着软件开发行业从传统的瀑布开发模式转向敏捷开发模式,软件的快速上线和业务的运维模式都相较于传统IT架构有了很大的区别。所以基础云架构模式目前也开始在一定程度上无法满足用户的需求。

(3)Cloud-Native:云原生模式,为了解决和满足用户的需求,云原生模式站在了业务角度上对技术架构进行了重构,以微服务作为底层的开发模式需要一种更加灵活的底层设计,所以云原生可以满足用户的需求,以容器和kubenets为架构的云原生系统就可以实现业务的秒级上线,并且对于运维人员来说数据的采集、处理、存储、归档都变得更加容易。

现在对于一些特定的场景,尤其是不宜进行变更的场景,还是会使用传统IT架构的,比如一些制造行业或者是需要使用到物理机的场景,还是会使用传统架构进行实现,大部分的中小型企业现在已经将整体业务迁移到云上进行实现了。而对于需要快速响应以及快速上线业务的公司来说,云原生架构会是最好的选择。

当前我们处于Cloud-Based阶段,预计未来在5-10年内云原生架构会成为业务架构的主要选择。

一、华为云Stack解决方案

华为云Stack和华为云之间的关系

华为云Stack是私有云产品,华为云是公有云产品,两个产品本质上是一套架构,华为云Stack就是华为云的硬件部署产品。用户使用华为云Stack可以做更多的自定义和自管理,使用华为云就是直接使用的资源。私有云产品更加注重的是数据安全性以及资源的可用性,公有云更加注重的是便利性和低成本。两者的选择要根据用户的实际需求进行选择。

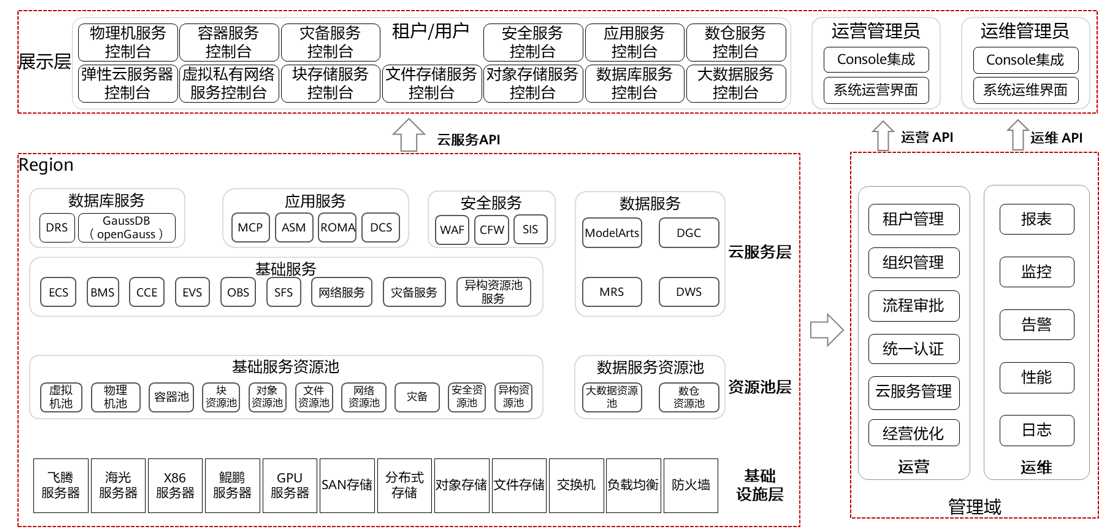

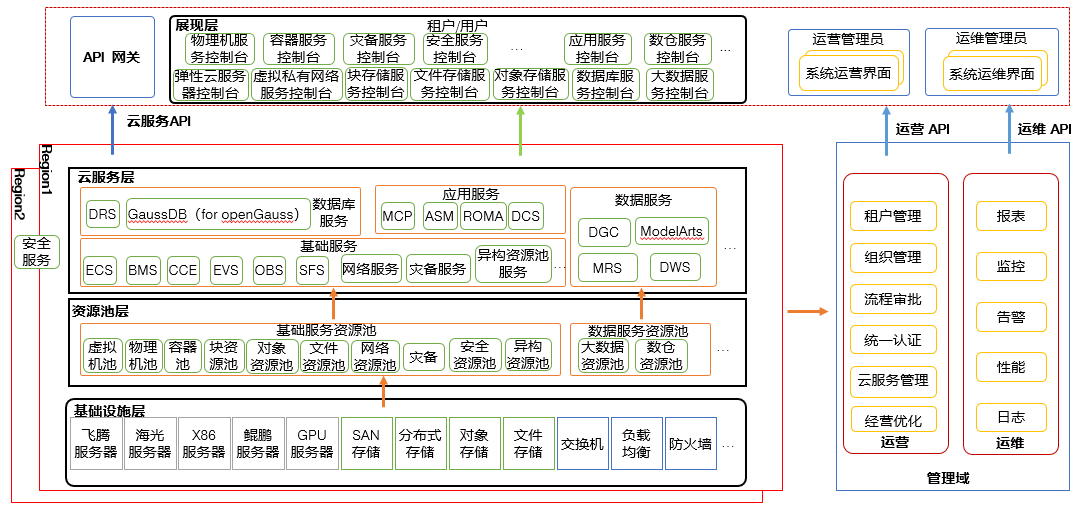

华为云Stack整体架构

(1)基础设施层:基础设施层主要提供的是资源,云架构的虚拟化本质上还是要依赖于物理资源的,所以基础设施层是实际的资源的提供者。目前华为云Stack支持的设备主要有飞腾服务器、海光服务器、X86服务器(华为RH系列、浪潮、曙光、H3C、HP、Dell……)、鲲鹏服务器(华为泰山、黄河服务器……)、GPU服务器(主要用于AI计算使用、Atlas服务器),综合总结计算资源类产品目前华为是支持多厂商的多架构的服务器,存储资源层面华为云Stack支持SAN存储、分布式存储、对象存储和文件存储四个类别,其中SAN存储经典的比如Oceanstor系列、EMC、IBM等,分布式存储主要支持FusionStorage,对象存储底层一般是使用OceanStor 9000系列,文件存储根据客户需求可以自行配置硬件。最后的资源是网络资源,网络资源主要实现的是设备的连接和资源的共享,一般来说组成云网络的硬件包含交换机、防火墙、负载均衡,如果客户的规模比较大,还会有SLB和GSLB两个产品。交换机一般来说架构华为云Stack会选择华为的CE系列(园区网交换机)的产品,防火墙一般会选择USG6300系列的产品(比如USG6350E),负载均衡根据用户的需求自行进行选配

综上所述,在基础设施层用户需要提供计算资源、存储资源和网络资源三个主要类型。其中必选的是x86系列服务器、SAN存储和交换机,其他的可以选配。

(2)基础服务层:基础服务资源池,基础服务资源池中的资源都是通过将基础设施层提供的硬件资源虚拟化形成的,用户创建的相关的服务都是由底层基础设施虚拟出来的。其中包含以下几项:虚拟机池主要是创建ECS弹性云服务器(阿里云、亚马逊云一般称ECS为EC2,实际上可以理解为是VM虚拟机)使用的,物理机池一般是面向于两个场景,第一个就是需要的单机资源量非常大的用户,第二个就是对数据安全和业务安全要求非常高的用户,物理机池分配的是完整的物理机,用户等于独享服务机的所有资源,在业务层面的体现就是裸金属服务器BMS。容器池主要是面向于云原生架构的相关业务,通过容器池可以创建对应的云容器引擎,同时拉起相关的容器,满足用户的相关需求。块资源池指的是存储块资源池,对应的是底层的SAN存储,在业务层面显示为云硬盘服务EVS。对象资源池是源自于对象存储设备,提供对象存储服务OBS。文件资源池主要提供的是文件共享服务SFS,一般用于用户自身创建的多个计算资源之间的数据共享。网络资源池的底层是分布式交换机,主要提供的是VPC虚拟私有云服务,用户可以通过该服务创建自身私有的网络,除了VPC之外,网络资源池还提供安全组、ACL、对等连接、VPN、弹性公网IP服务等。灾备服务一般是同时使用存储相关的资源池和网络资源池共同实现,尤其是会使用到块资源池的EVS云硬盘服务和网络资源池的VPC虚拟私有云服务。但是需要注意的是如果用户需要使用灾备服务,至少需要有两个或两个以上的region(区域),安全资源池面向的是对云业务有高安全性需求的用户,主要使用云堡垒机、WAF网页防火墙以及企业主机安全HSS等等。异构资源池主要是用户同时选配多种计算资源时使用的,比如使用非x86和鲲鹏系列的服务器或者是用户的主机包含有GPU、FPGA等相关定制化芯片的场景。大数据资源池是不依赖于底层的基础设施层的,用户需要单独搭建大数据的相关服务,然后对接到华为云Stack上进行统一的资源管理和资源分配,数据服务资源池主要包含MapReduce服务、大数据类的其他服务以及AI服务(主要是ModelArts),底层基础设施层是由FusionInsight Manager。

(3)云服务层:云服务层所提供的服务使用的资源就是来源于资源池层,主要是包含以下服务:

低阶服务:ECS弹性云服务器(必选),可以简单的理解为是VM。BMS裸金属服务器(可选),可以简单的理解为是物理机。CCE云容器引擎(可选),用户对容器进行全生命周期的管理都是通过CCE实现的。EVS云硬盘服务(必选),主要为ECS和BMS提供底层存储资源。SFS文件存储服务(可选),提供了文件共享的相关服务,可以简单理解为是FTP服务器,但是实际上由CIFS和NFS以及FTP构成。网络服务包含多项服务,大部分的网络服务都是集成在VPC虚拟私有云中的,虚拟私有云VPC(必选)提供了用户的网络底层,允许用户在内部进行通信以及公网的访问。

高阶服务(均为可选):OBS对象存储服务主要提供的是海量的数据存储,尤其是在大数据场景下构建数据湖进行使用。灾备服务主要是SDRS存储容灾服务,提供跨region的业务数据的异步远程复制,保证业务的数据安全。异构资源池服务并不是一个服务的名称,而是一类服务的名称,用户购买的ECS或者是BMS不仅仅包含CPU,同时包含有其他计算资源时,比如GPU、FPGA芯片等,在这种场景下,就是调用的异构资源服务。

数据库服务主要包含有DRS数据复制服务,主要是用户业务上云使用。GaussDB华为高斯数据库、Mysql数据库。

应用服务主要包含MCP多云容器平台,主要是跨云容器进行业务互通使用,尤其使用在政府部门。ASM应用服务网格,该服务为容器的相关服务,ROMA资产中心主要是帮助用户进行资源统计和资源管理使用的,DCS分布式缓存服务。安全服务主要包含WAF网页防火墙、CFW云防火墙、SIS安全指数评估服务

数据服务作为高阶服务,是独立部署对接到华为云Stack进行统一纳管的,主要包含ModelArts-AI开发平台(提供线上的代码开发到模型训练与发布的一站式平台)、MRS-MapReduce服务(大数据平台,基于开源Hadoop进行二次开发的产品,物理部署软件叫做FusionInsight)、DGC数据治理中心、DWS数据仓库服务(GaussDB for OLAP)

(4)管理域:主要包含有运营和运维两个层面,其中运营层面是面向于业务系统的,运维层面是面向于运维人员的。

运营层面:主要是面向于业务系统,业务系统的管理人员,比如说开发部门的经理,会根据需求创建相关的账号进行资源的分配。所以运营层面更多涉及的是怎么使用资源。主要的功能包括租户管理,租户管理可以理解为用户在运营账号下创建子账号分配给相关的最终用户使用,对标到华为云可以理解为是IAM账号。组织管理一般是针对于大型公司进行使用的,比如公司的总账号可以创建不同的部门,用于细节化的管理使用。用户可以给组织和租户不同的权限,在华为云Stack中对于权限的管理主要分为了权限、角色、用户、用户组四个部分。

权限——>角色——>用户组<——用户

权限分配给角色,角色绑定给用户组,用户组就可以继承角色的权限,用户加入用户组,就可以获取用户组的权限,从而进行正常的使用。

流程审批:主要是针对于两个场景,分别是最终用户使用的资源超限和最终用户使用的资源数量超限,比如用户默认可以使用100个ECS弹性云服务器,超过100个就需要进行申请。或者是用户最多可以创建的ECS可选vCPU最大为48核,如果单个ECS核心数超过48核,则使用时需要进行申请。

统一认证:一般应用在多region场景下的,用户登录不同的IDC的华为云Stack的分枝,可以使用相同的账号,一个账号创建之后在所有站点都是通用的。在HCIE云计算3.0的实验中,用户就是通过多VDC接入的,考试场景下包含有一个总部站点和3个分枝站点VDC(virtal Data center),考试时用户只需要在运营平台上创建用户之后,就可以在所有的站点中直接进行登录。

云服务管理:主要涉及到云服务的上线、下线、资源管理等相关的业务,比如高阶服务在华为云Stack初始化部署的时候并没有安装,后期需要进行扩展的时候,就可以通过云服务管理进行上线。

经营优化:经营优化主要是面向于资产管理部门,管理员可以通过经营优化的界面查看到相关的资源使用情况和资源利用率等信息,进行业务调整,比如管理员发现当前的资源利用率比较高,可以选择超分资源,先满足参数需求,然后后续再去进行资源扩展。

运维层面主要是保证华为云Stack的正常运行进行管理的服务,主要包含有报表,比如运行情况、故障告警统计以及相关的信息记录和总结。监控主要是针对于当前系统的整体性能进行监控管理。告警主要是针对系统中存在的问题进行提示,主要包含有提示、警告、重要、紧急四个级别。性能主要是针对于当前华为云Stack的基础设施层进行监控,显示当前资源的整体分配、利用率等信息,最终是日志,所有华为云Stack的服务的日志都会通过日志服务进行显示、存储、持久化。

(5)展示层:展示层主要是提供了可视化界面对底层服务进行使用,展示层的核心主要是控制台,用户或者是租户可以通过控制台进行资源的分配和使用以及相关的管理(创建、删除……)主要包含云服务器控制台、网络控制台、存储控制台、高阶服务控制台(OBS、DB、BigData、AI、Security)

除了服务使用的控制台之外,对于系统管理员和业务经理来说,在使用和维护的层面就会接触到OC和SC,即运营平台和运维平台。

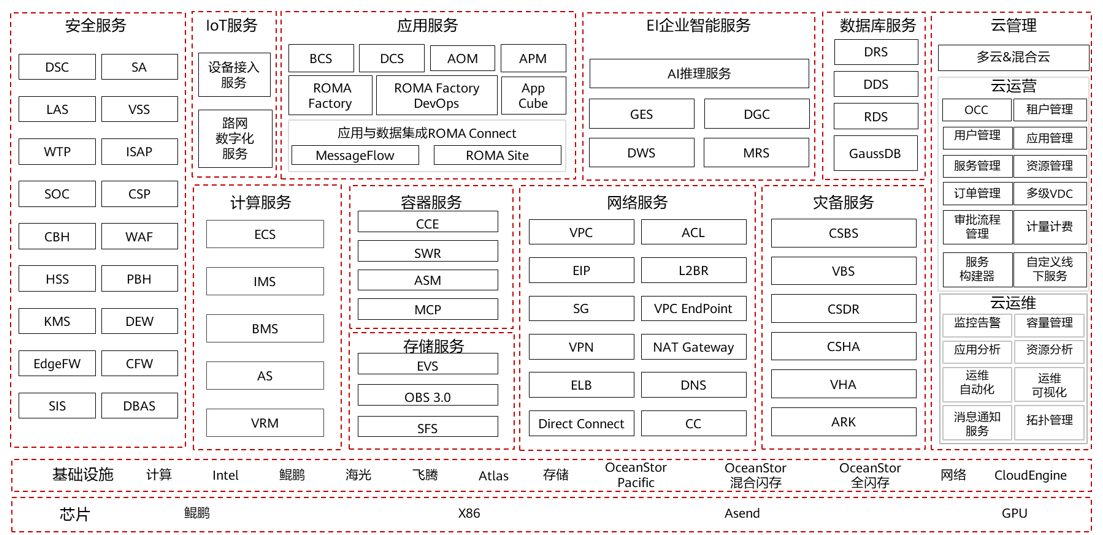

华为云Stack 8.1.1云服务一览

一、安全服务

DSC:数据安全中心(Data Security Center)→ 云原生数据安全管理平台

SA:安全审计(Security Audit)→ 安全行为审计与合规管理

LAS:日志审计服务(Log Audit Service)→ 日志集中审计与分析

VSS:漏洞扫描服务(Vulnerability Scan Service)→ 资产漏洞检测

WTP:网页防篡改(Web Tamper Protection)→ 网站内容防篡改

ISAP:入侵防御(Intrusion Prevention)→ 网络入侵检测与防护

SOC:安全运营中心(Security Operations Center)→ 安全态势统一管理

CSP:云部署服务(Cloud Provisioning Service)→ 云平台自动化部署

CBH:云堡垒机(Cloud Bastion Host)→ 运维操作管控与审计

WAF:Web 应用防火墙(Web Application Firewall)→ 防护 Web 攻击

HSS:企业主机安全(Host Security Service)→ 主机 / 容器安全防护

PBH:私有堡垒机(Private Bastion Host)→ 私有化运维管控

KMS:密钥管理服务(Key Management Service)→ 密钥全生命周期管理

DEW:数据加密服务(Data Encryption Workshop)→ 数据加密与密钥管理

EdgeFW:边缘防火墙(Edge Firewall)→ 边缘节点网络安全防护

CFW:云防火墙(Cloud Firewall)→ 云端网络安全防护

SIS:敏感信息识别(Sensitive Information Scan)→ 敏感数据识别与保护

DBAS:数据库安全审计(Database Audit Service)→ 数据库操作审计

二、IoT 服务

设备接入服务:IoT 设备接入平台(IoT Device Access)→ 设备连接与管理

路网数字化服务:路网数字化平台(Digital Road Infrastructure Service)→ 车路协同与智慧交通

三、应用服务

BCS:区块链服务(Blockchain Service)→ 区块链应用开发与管理

DCS:分布式缓存服务(Distributed Cache Service)→ 兼容 Redis 的高速缓存

AOM:应用运维管理(Application Operations Management)→ 应用监控与运维

APM:应用性能管理(Application Performance Management)→ 应用性能监控

ROMA Factory:应用集成开发平台 → 低代码应用开发

ROMA DevOps:DevOps 工具链 → 应用持续交付

App Cube:应用魔方 → 低代码应用构建平台

ROMA Connect:应用与数据集成平台 → 跨系统数据 / 应用集成

MessageFlow:消息流服务 → 消息集成与流转

ROMA Site:站点集成服务 → 多站点应用管理

四、EI 企业智能服务

AI 推理服务:AI 模型推理平台 → 预训练模型推理部署

GES:图引擎服务(Graph Engine Service)→ 图数据存储与分析

DGC:数据治理中心(Data Governance Center)→ 数据全生命周期治理

DWS:数据仓库服务(Data Warehouse Service)→ 企业级数据仓库

MRS:MapReduce 服务(MapReduce Service)→ 大数据处理平台(Hadoop/Spark)

五、数据库服务

DRS:数据复制服务(Data Replication Service)→ 数据库迁移 / 同步

DDS:文档数据库服务(Document Database Service)→ 兼容 MongoDB 的文档数据库

RDS:关系型数据库服务(Relational Database Service)→ 兼容 MySQL/PostgreSQL 等

GaussDB:高斯数据库 → 华为自研企业级分布式数据库

六、云管理

OCC:运营控制中心(Operation Control Center)→ 运营流程管理

多级 VDC:“多租户虚拟数据中心” 分级管理模式 → 在华为云 Stack 中,它是将云资源按 组织层级(如总公司→分公司→部门) 划分成多个嵌套的虚拟资源域,

每个层级 VDC 可独立管理自身的资源配额、用户权限和业务应用,既实现了资源的隔离与按需分配,也适配了大型组织的层级化管理需求。

七、计算服务

ECS:弹性云服务器(Elastic Cloud Server)→ 弹性虚拟服务器

IMS:镜像服务(Image Management Service)→ 云服务器镜像管理

BMS:裸金属服务器(Bare Metal Server)→ 物理服务器资源

AS:自动伸缩服务(Auto Scaling)→ 资源弹性伸缩

VRM:虚拟化资源管理(Virtual Resource Manager)→ 虚拟化资源管控

八、容器服务

CCE:云容器引擎(Cloud Container Engine)→ Kubernetes 容器管理

SWR:容器镜像服务(Software Repository for Container)→ 容器镜像存储

ASM:应用服务网格(Application Service Mesh)→ 微服务流量治理

MCP:多集群管理(Multi-Cluster Platform)→ 容器多集群管理

九、网络服务

VPC:虚拟私有云(Virtual Private Cloud)→ 隔离网络环境

ACL:访问控制列表(Access Control List)→ 网络访问控制

EIP:弹性公网 IP(Elastic IP)→ 公网访问 IP

L2BR:二层桥接(Layer 2 Bridge)→ 二层网络桥接

SG:安全组(Security Group)→ 实例级网络访问控制

VPC EndPoint:VPC 终端节点 → 私有网络访问服务

VPN:虚拟专用网络(Virtual Private Network)→ 加密网络连接

NAT Gateway:NAT 网关 → 网络地址转换

ELB:弹性负载均衡(Elastic Load Balance)→ 流量分发

DNS:域名服务(Domain Name Service)→ 域名解析

Direct Connect:云专线 → 专线网络连接

CC:云连接(Cloud Connect)→ 多 VPC / 跨区域网络互通

十、灾备服务

CSBS:云服务器备份服务(Cloud Server Backup Service)→ 云服务器备份

VBS:云硬盘备份服务(Volume Backup Service)→ 云硬盘备份

CSDR:云服务器灾难恢复(Cloud Server Disaster Recovery)→ 服务器容灾

CSHA:云服务器高可用(Cloud Server High Availability)→ 服务器高可用

VHA:虚拟主机高可用(Virtual Host High Availability)→ 虚拟主机高可用

ARK:容灾管理平台 → 灾备统一管理

十一、基础设施

芯片:鲲鹏(Kunpeng)、x86 等芯片架构

计算:Intel、鲲鹏、海光、飞腾、Atlas(AI 芯片)

存储:OceanStor Pacific(分布式存储)、OceanStor 混合闪存 / 全闪存(集中式存储)

网络:CloudEngine(交换机)

其他:Ascend(昇腾 AI 芯片)、GPU(图形处理器)华为云Stack标准逻辑部署架构

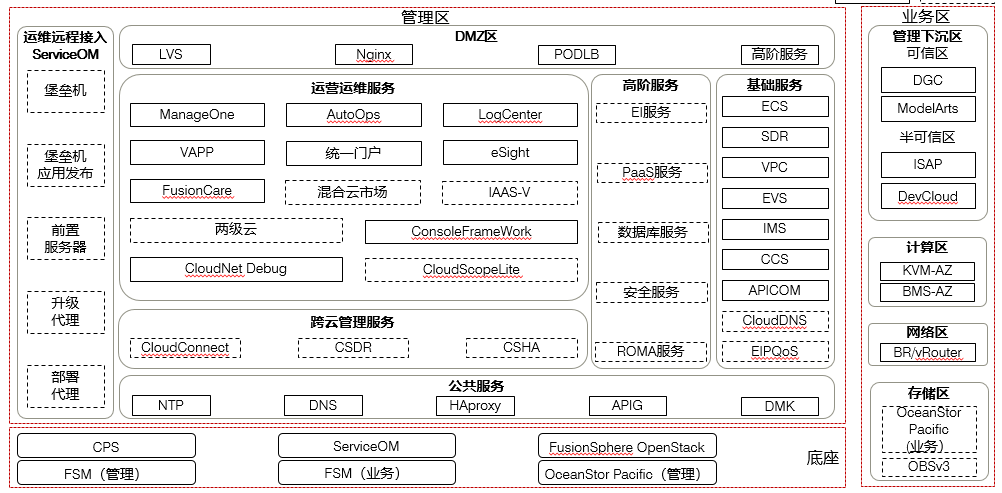

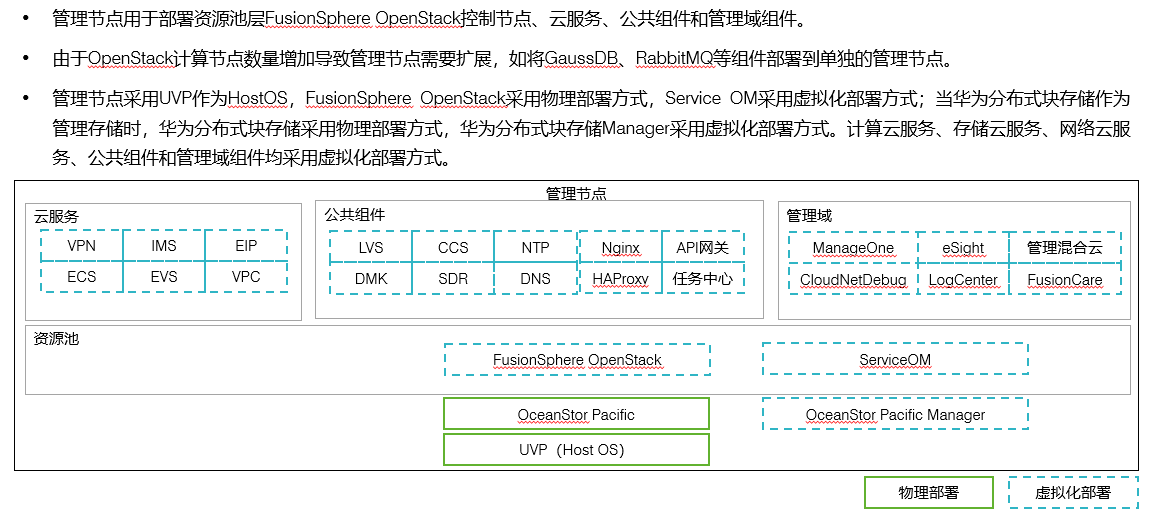

底座:华为云Stack的底座主要提供的是整体架构,所有的上层服务,不论是业务还是管理都需要依赖于底座才能有正常的服务。

FSM(Fusion Storage Manager):华为分布式存储管理,管理功能主要是针对于分布式存储进行相关的控制与维护,分布式存储的业务主要是提供的存储空间。

OceanStor Pacific:物理存储的管理进程

FusionSphere openStack:本质的华为云Stack的技术底座,可以理解为是华为云Stack的框架

Service OM:提供对于全平台的管理,可以理解为是底层和上层管理区的沟通进程,所有上层的管理命令和业务使用的相关沟通,都需要通过Service OM进行在转发

业务区

管理下沉区:DGC数据网关控制进程,主要是关于AI相关的数据上传和数据转发的进程。比如在AI里面,用户使用DaaS相关的服务,需要涉及到数据从外部转发到华为云Stack的内部,在这个过程中,就需要通过DGC进行从外到内的数据转发。 ModelArts是华为的AI开发一站式平台,用户通过 DGC发送的数据一般就会传递到ModelArts中。需要注意的是管理下沉区是包含了可信和不可信两个区域的,可信指的是用户传递的数据是属于完全可信任的,不会出现不安全的情况。半可信区主要指的是用户上传的数据具有不可信的情况,但是这种情况是极少数的。主要涉及的服务有ISAP和DevCloud服务,主要是满足用户的开发需求的,Devcloud和ISAP是用户开发一站式平台。用户可以使用这两个服务做一站式开发同时将所有代码完全托管给华为云,从代码开发到业务上线下线的全生命周期管理。

管理下沉指的是这两个服务,即AI开发框架和敏捷开发框架并不是安装在华为云Stack上的,他们是独立部署安装的,然后对接到华为云Stack中的,所以华为云Stack对于这两个业务的管理实际上是通过API接口下发到对应服务的管理平台的。也就可以理解为这两个服务做了管理托管。

计算区:计算区主要是做计算类相关的业务提供的。比如ECS和BMS,计算区最主要的两个服务就是KVM-AZ和BMS-AZ。这两种服务本质上就是云服务多种类型的底层,不论什么计算服务最终都是由这两种模式所提供的。

补充:

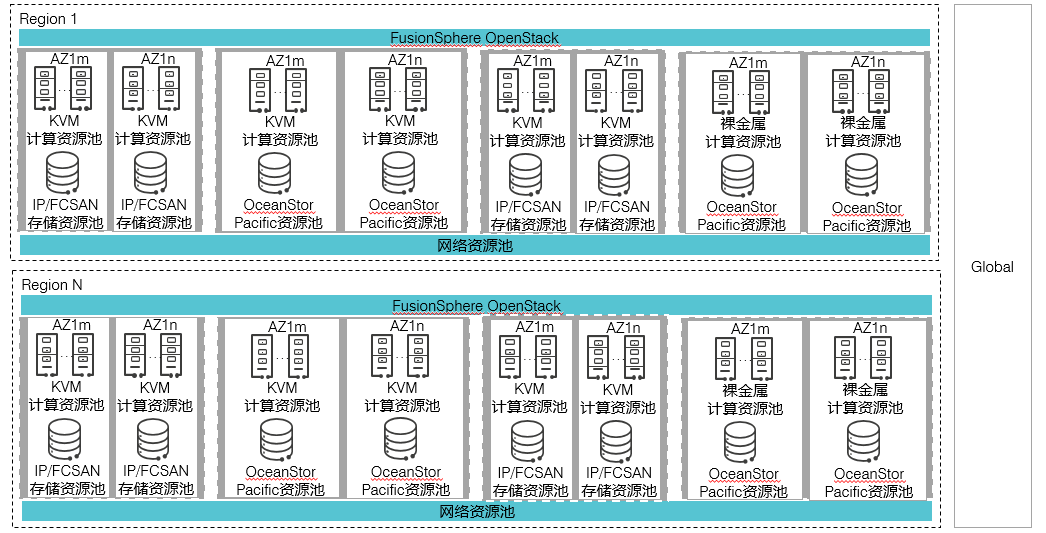

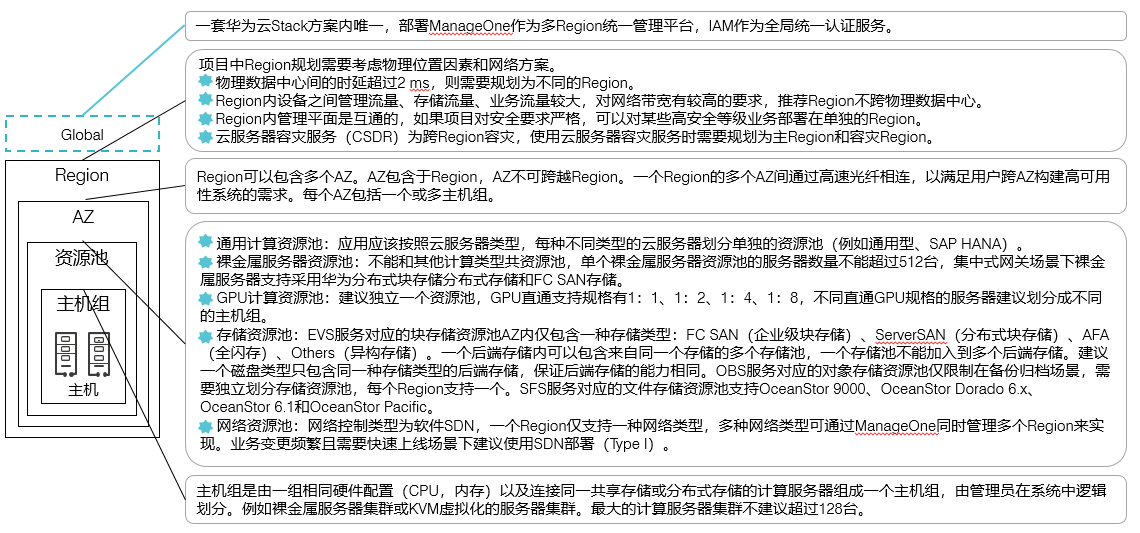

region:区域一般指的是具有距离性的两个或多个地域概念,比如北京区和上海区

AZ:可用区一般指的是Region区域下的不同的物理机房

VDC:虚拟数据中心,可以简单的理解为是AZ

网络区:网络区主要提供的是网络服务,实际上可以理解为是Openstack的网络服务的虚拟化,或者是可以理解为OVS服务(Open Virtal Switch),用户在VPC层面主要是通过逻辑网络进行隔离的,本质上并没有使用到物理交换机网络,当用户需要和底层或外部进行沟通的时候,这个时候就需要通过BR/vRouter进行实现,还需要依赖于物理网络搭建vxlan实现。

存储区:存储区的构成主要由两个部分构成,一个是物理存储提供的业务访问接口,用于上层的云服务使用底层的存储空间(oceanStor Pacific),另外一个就是OBSv3,OBS提供的是对象存储服务Object Storage,主要面向的是大规模的大数据存储或数据湖存储或数据治理相关服务使用。我们可以简单的理解为云硬盘服务、文件共享服务使用的是OceanStor Pacific提供的资源,而大数据相关的存储都是用的是OBS的存储。需要注意的一个问题就是OceanStor本质上是物理存储设备,也不是HCS搭建的,HCS做的是对接和托管,OBS同理。目前OBS有两种部署方式,一种是通过分布式存储的部署实现。另外一种就是通过华为OceanStor 9000系列产品安装部署。

管理区

公共服务:公共服务并不是用户使用的服务,而是针对于进程之间的服务,在计算机的系统中,一般会有人机服务和机机服务两个类型,人机服务主要是面向于用户的,机机服务主要是设备与设备之间或者是进程和进程之间进行通信和管理的服务,公共服务指的就是后者。

公共服务主要由以下几个服务构成

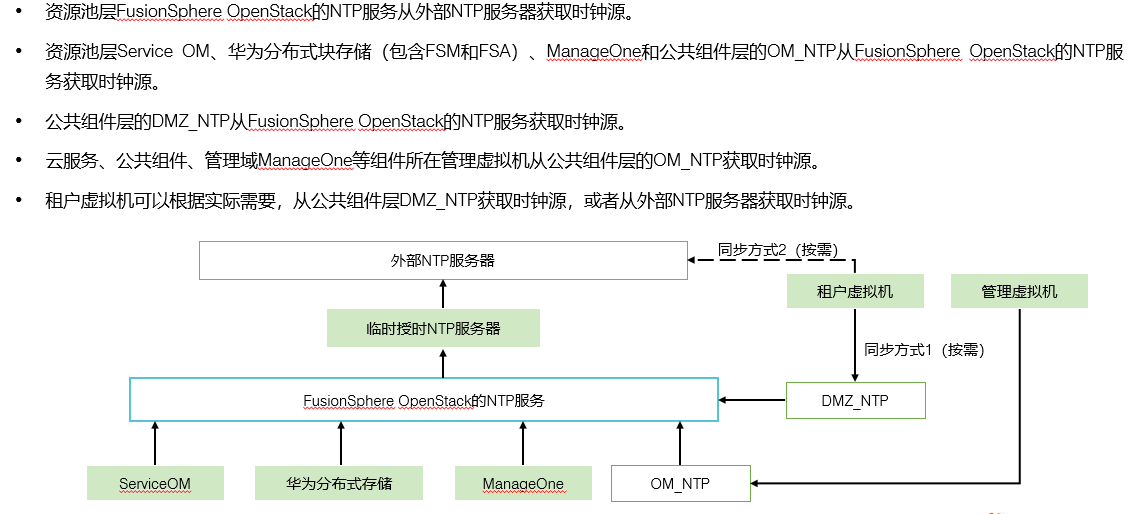

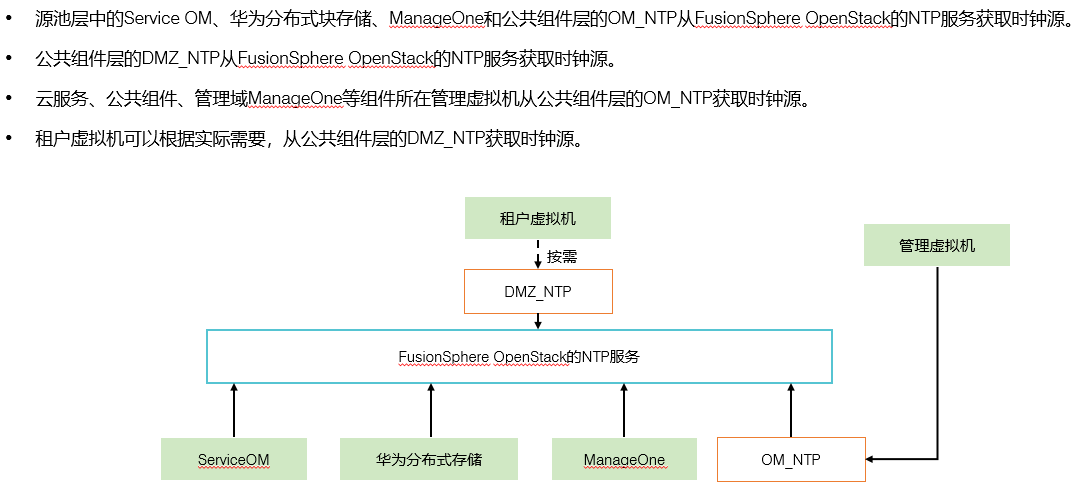

NTP:Network Time Protocol网络时间服务,在HCS中会有一个也仅有一个NTP时钟服务器,HCS的所有底层设备和上层进程都需要和该NTP时钟进行时间同步。

DNS:Domain Name Service域名解析服务,主要是用于内部所有的设备进行沟通使用,需要注意的是现在常用的框架比如Hadoop、OpenStack等等,他们都是使用主机名进行通信的,所以为了能够满足主机名通信的需求,我们就必须要在全局部署一个DNS域名解析服务器,将所有的主机名解析成IP地址进行通信。

HAproxy:高可用性代理服务,主要是满足底层框架的高安全性的,一般是做管理进程保证的。比如说某一个主要的控制进程,如果是单机服务一旦这个控制进程出现问题,那么就会导致全部系统的业务停摆,所以为了保证业务的正常运行,一般情况下都会选择进行主备进程部署,保证在主进程出现问题的情况下,备进程可以实时切换。那么主备之间如何监测对方是否存活?这时候就需要HAProxy进行控制。

APIG:API Gateway,所有的底层应用进行消息互通,都是通过APIG进行实现的。

DMK:运营商云常用的相关云服务,主要是对接第三方接口和平台进行使用。

跨云管理服务:跨云管理服务主要用于混合云或者是多区域云使用,比如用户有公有云服务和私有云服务,或者是用户有多个私有云站点的时候进行使用的。

CloudConnect:云连接服务,主要提供的是云对等连接,可以在逻辑上将多个站点的云进行连接使用。

CSDR:云容灾服务,主要是做云架构的主备容灾使用,一般是使用在3DC(两地三中心)场景下。

CSHA:云高可用服务,主要是做站点内部的安全性服务的。也是使用在3DC场景下的。

运维远程接入:主要是用于从公网外部接入到HCS内部使用的,接入的管理员有两种情况,一种是HCS的管理员,另一种就是购买了华为专家服务的相关HCS框架,通过ServiceOM接入到华为的运维中心。远程接入主要有两类功能,一个是满足接入,另一个就是保证安全。

基础服务&高阶服务:主要是提供用户使用的相关服务。

运营运维服务:运营运维服务主要是用户进行管理HCS使用的框架。主要包含了以下相关服务:

ManageOne:HCS中最重要的管理平台,目前所有关于HCS的管控基本都是通过ManageOne实现的。

AutoOps:自动化运维服务,用户对于系统的升级、补丁、自动化的相关的一些操作,比如业务下发等等都是通过自动化运维实现的。

LogCenter:日志中心,HCS所有的相关日志都会被采集和存储到LogCenter中

VAPP:虚拟应用 (Virtual Application),虚拟应用是指运行在VDC中的一组VM的统称,属于特定vApp的VM之间存在特定的依赖关系,vApp从VDC上可以保证vApp内的VM在启动和停止时满足设定的顺序和时间要求。

统一门户:不论用户有多少个Region或者是AZ,接入HCS的接口都是只有一个的。

esight:主要是做网络设备管理的控制平台,主要管理路由器、交换机、防火墙、AP和AC等设备,也就是说使用华为数通产品的设备基本上都可以通过esight进行管理,或者准确的说是使用华为VRP系统的,都可以通过esight进行管理。

FusionCare:健康巡检工具,IT系统检查和巡检工具,包括但不限于华为服务器产品和华为存储产品。

扩展:一般来说选择购买HCS产品的用户,尤其是政府和事业单位,才选择安装esight和FusionCare之外,还会选择购买一个产品叫做FusionCenter,FusionCenter主要是面向于资产管理,包括底层开局相关进行使用。而且FusionCenter支持对异构和其他产品服务器进行统一纳管,也就是说华为FusionCenter除了支持华为自身的全系列IT产品之外还支持主流的厂家的各种异构产品的托管,包括但不限于浪潮、曙光、Dell、EMC、HP。

混合云市场:一般是面向于混合云场景和运营商云场景,主要提供的是定制化的一些产品规格。

IAAS-V:主要是异构云托管和接入使用,假设用户有多个私有云,那么通过IAAS-V可以将其他云的资源托管到华为云进行使用。

两级云:两级云一般是应用在特殊场景下的,比如化石行业,一般用于多个HCS对接使用,比如说石油行业,在不同的地域有不同的云,尤其是管理云和生产云之间进行对接,一般就会选择有两级云进行配置。

ConsoleFrameWork:提供标准接口,用于三方对接使用

CloudNetDebug:云网络排障工具,一般用于私有云网络出现问题时,进行自动化排障使用的。

CloudScopeLite:该工具有两个功能,一个是文档中心,一个是云健康评分。

DMZ区:服务器区,主要提供的是外部接入的相关的服务,更明确的说,就是保障最终用户使用的时候,更加顺畅。

LVS:当有多用户接入的时候,LVS可以自动的选择当前集群负载压力最小的节点提供服务。

Nginx:主要功能就是做负载均衡

PODLB:POD Load Balance节点负载均衡

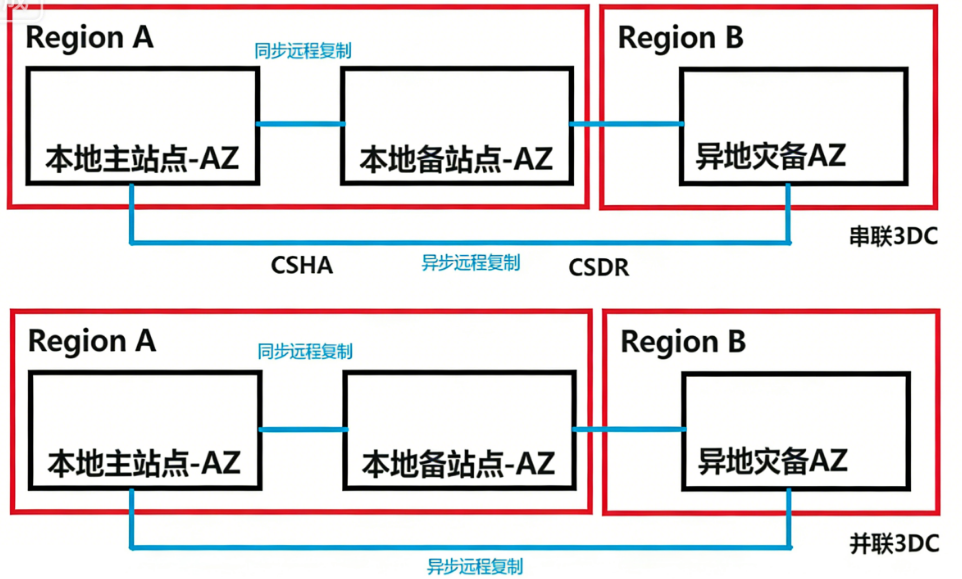

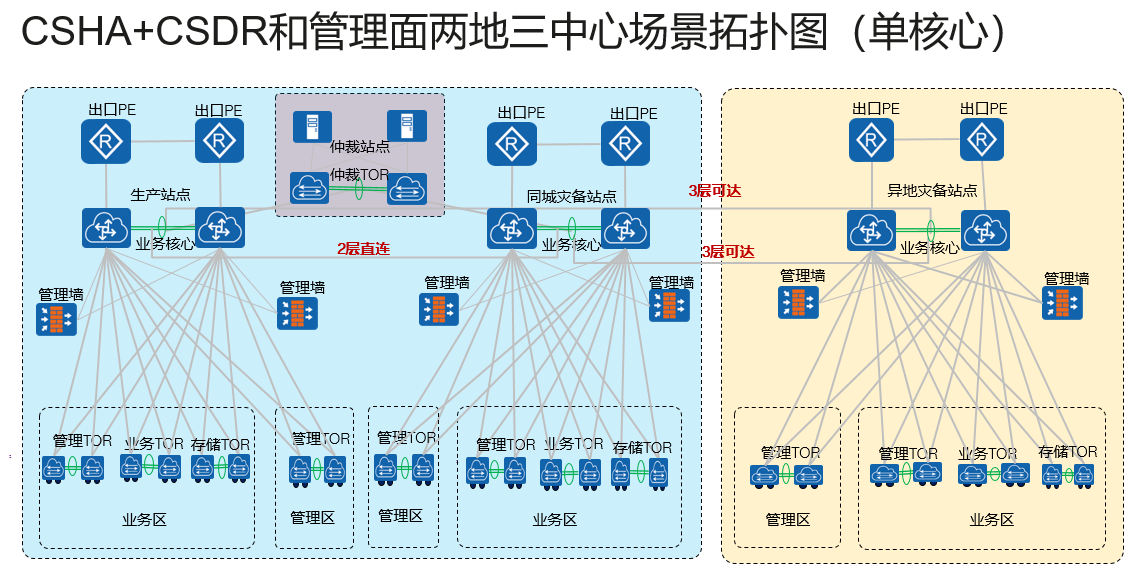

补充:3DC,即两地三中心,作为高安全性保证的解决方案进行使用,两地指的是本地和异地,三中心指的就是本地主站点,本地备站点,异地灾备站点。一般情况下,本地主站点和本地备站点使用的服务就是CSHA,本地站点和异地站点之间使用的就是CSDR服务。根据不同的实现方式就会有3DC串联和3DC并联两个解决方案。

华为云Stack云服务架构

芯片:

X86芯片(Intel)、鲲鹏CPU、Assend(昇腾AI计算卡)、GPU(一般指的是Nvidia显卡)

基础设施:

计算:海光、飞腾、Atlas(Atlas200计算卡、Atlas800服务器)、Nvidia产品

存储:华为分布式存储OceanStor Pacific、OceanStor统一存储(5300v5/5500v5/6800v5)、OceanStor Dorado系列产品(全闪存)

网络:CloudEngine云引擎,主要提供网络服务

基础服务:

计算:ECS弹性云服务器、BMS裸金属服务器、IMS镜像服务、AS弹性伸缩服务

存储:EVS云硬盘服务-块存储、SFS文件存储服务-文件存储、OBS对象存储服务

网络:VPC虚拟私有云、ACL访问控制列表、EIP弹性公网IP、SG安全组、L2BR二层桥路由服务、L3GW三层网关服务、VPC Endpoint终端节点、VPN、NAT Gateway地址转换网关、Direct Connect直接连接服务、CC云连接服务、ELB弹性负载均衡、DNS地址解析服务

容器服务[CCE云容器引擎、SWR容器镜像服务、ASM应用服务网格、MCP多云容器平台]

灾备服务:CSDR云容灾服务、CSHA云高可靠性服务、VBS云硬盘备份、VHA虚拟高可靠性服务

安全服务:HSS主机安全服务、WAF网页安全防火墙、CFW云防火墙、

IoT服务:设备接入服务、路网服务

数据库服务:DRS数据复制服务、DDS文档数据库服务、RDS云数据库服务、GaussDB高斯数据库服务

云运维服务:监控、告警、容量管理、应用分析(SaaS)、资源分析、运维自动化、运维可视化、消息通知服务、拓扑管理。

云运营:OCC云运营中心、租户管理(IAM)、用户管理、应用管理、服务管理、资源管理、订单管理、多级VDC、计量计费、

混合云和多云管理(云连接、云运维、云托管)

华为云stack的优势

一云多芯,多元算力:华为云是支持云上运营多种架构的CPU的。华为云stack目前支持x86系列的CPU、鲲鹏系列CPU以及裸金属相关的资源提供。用户可以通过配置一套云系统,搭载多种CPU进行服务提供

高适应性网络:华为基于开源Openstack的Nertorn服务进行了二次开发,同时引入了SDN网络进行网络的相关配置,尤其是涉及到自动化配置,在部署和维护上Openstack复杂的底层网络可以通过华为云stack平台的托管,在管理上有更加具有优势的运维能力。

全栈国密三级:在国内目前的信息安全领域中,对于国密算法的支持实际上是比较重要的,尤其涉及到政府、网安相关的部门。目前国内的加密算法SM 1——SM9,祖冲之算法等,华为云Stack可以支持到国密3级以上的算法(一般是指软件产品支持SM2和SM3算法)。

资源融合、灵活调配:华为云Stack对于底层的资源并没有非常高的设备型号要求,HCS支持华为自身的产品进行搭建,同时也支持使用三方设备进行配置,目前国内支持的比较好的产品包括但不限于服务器:清华紫光、宝德、浪潮;存储:EMC、IBM、Dell;网络设备:华三、锐捷。防火墙产品需要注意,搭建HCS只能使用华为的产品,而且要在USG6350E以上。

华为云Stack支持对接其他的异构云,用户可以自行进行相关的配置对接,保证资源使用过程中,不会出现跨平台的无法对接情况出现。

在硬件设备层面,HCS可以选择搭载鲲鹏CPU的相关设备(支持全鲲鹏CPU设备进行部署)、计算资源支持飞腾服务器(全国产ARM架构CPU的服务器产品)和海光服务器(全国产X86架构CPU的服务器产品),但是需要注意的是,HCS分为了控制节点、网络节点、计算节点,只有计算节点支持异构,控制和网络只能用华为服务器。

华为云Stack网络互通、目前HCS支持云内和云外网路互通的,云内的网络互通是通过VXLAN实现的。云内外互通是通过EIP(弹性公网IP)实现的,私有云互通是通过云连接或者是VPN实现的。

在HCS中,由于本身HCS底层的Openstack其网络服务进程是比较复杂的,尤其是涉及到DC中VXLAN和网络架构设计的不同,会导致最终的维护非常复杂,所以HCS设计了CloudNetDebug云网络运维产品。

网络运维-CloudNetDebug

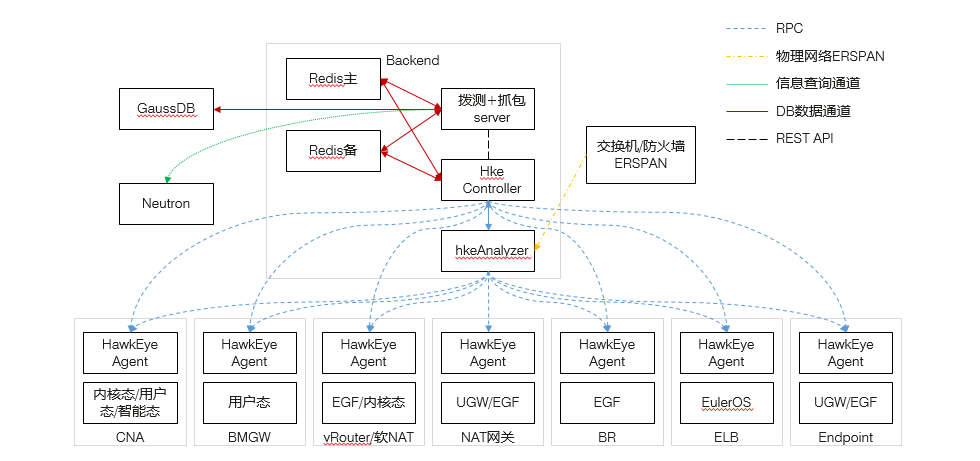

对于CloudNetDebug来说,核心的控制进程是BackEnd,其负责了对于网络所有的管理以及运维能力。在BackEnd中包含的进程如下:

Redis:在HCS中实际上是内置了主备Redis进行核心数据的记录,网络排查中的所有的相关操作以及配置等信息全部都被缓存在了Redis中。

拨测抓包工具:由于HCS大量的相关流量是很难被抓包出来的,另外进行相关的ping测试是比较困难的,传统情况下,用户需要登录不同的设备进行相关的操作,这就会导致故障排查需要大量的时间,通过拨测工具包可以直接一键进行下发,快速定位问题点。但是需要注意该工具是Server,也就是其下发指令,具体的执行需要对应的设备在进行执行之后进行反馈。

HawkEye(鹰眼):实际上该工具就是CloudNetDebug的核心,所有的相关信息采集和信息分析都是由鹰眼工具做的

HkeController:HKE控制进程,所有相关的任务都是由拨测工具下发,指令到达Controller之后,Controller是具体的命令下发和管理者,所以我们可以简单理解拨测工具只是一个简单的可视化界面。

HkeAnalyzer:HKE分析器,所有拨测返回的信息都是由Agent反馈给分析器进行处理,由分析器最终得到故障定位的。

Agent:代理端,实际拨测动作的最终执行者,其安装在设备的底层。

Neutron:OpenStack的网络管理服务,最终HCS所有的相关网络服务还是无法脱离Neutron的,所以拨测抓包工具需要和Neutron进行信息查询,了解当前的网络架构和信息。

GaussDB:持久化的信息存储和信息查询都是在GaussDB进行存储的,包括配置信息等。

流程:

用户通过拨测抓包工具的web配置界面,进行任务提交

拨测工具会联系Neutron进行当前网络的信息查询

查询到相关的信息之后,对应的网络节点和网络服务的配置会在Redis和GaussDB之间进行存储和查询。

拨测工具查询到对应的配置和参数之后,会下发请求到达Controller进程,要求Controller进行动作执行

Controller收到请求,会发送RPC指令到Agent代理端进行命令执行。执行完成之后,结果会发送到HKEAnalyzer

Analyzer收到Agent反馈的信息之后,会进行分析,找到相关的问题点,然后反馈给Controller

Controller收到信息之后,反馈给拨测工具,最终在web界面上进行展示。

全场景全地域灾备:

在HCS的设计中,目前如果用户选择是全私有化部署,那么可以支持3DC,如果用户是混合云场景,还支持多云灾备。

RPO:恢复时间点,从故障发生后,业务恢复的数据时间点

RTO:恢复时间,从业务故障到业务上线的时间消耗

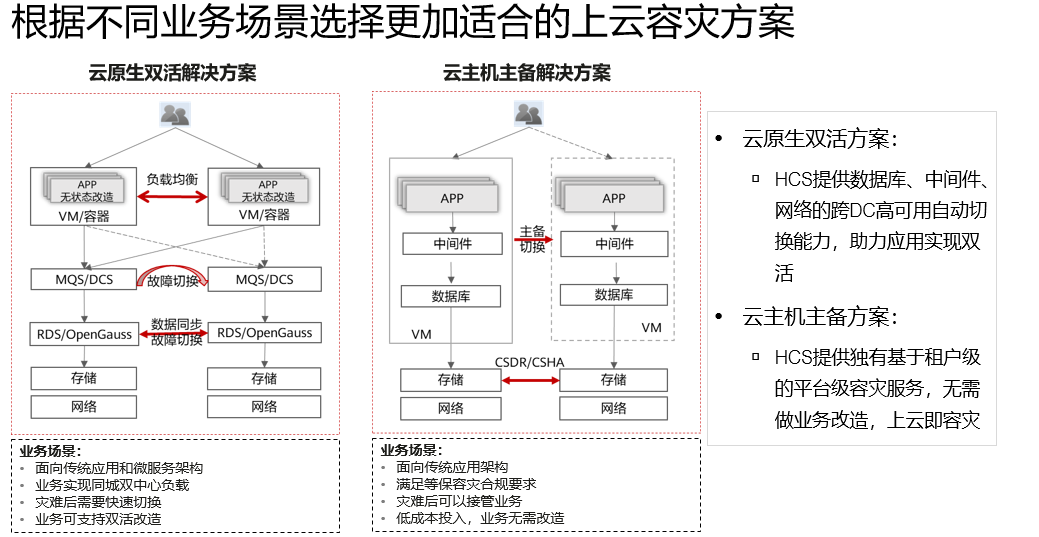

云容灾目前比较常用的有双活和主备两种形式,用户需要根据业务的实际情况进行选择。一般情况下,如果用户的业务是以容器化为主的,那么可以推荐使用双活引擎进行业务的安全保障,如果用户的业务还是以ECS为主,那么一般是建议选择HA。

云容灾方案

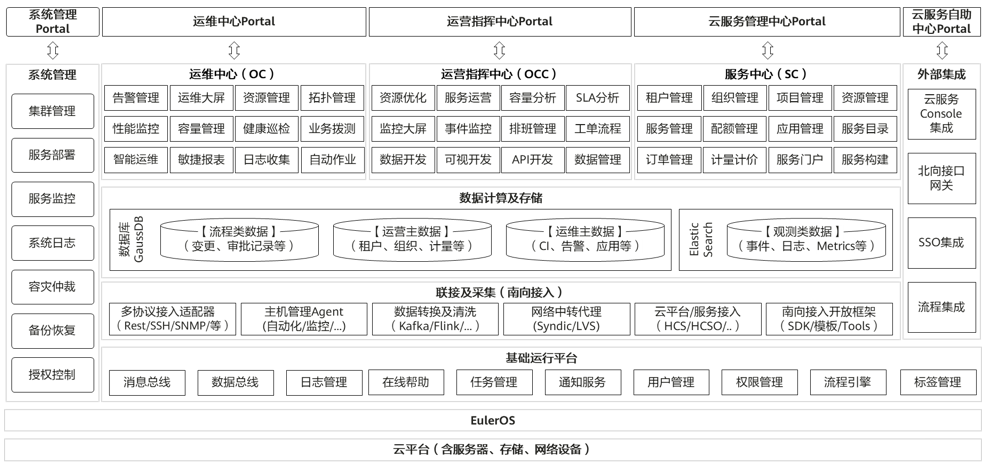

ManageOne架构

ManageOne是HCS的管理平台,对于云的使用来说,是由统一门户提供的服务。也就是说用户在使用云的时候,是通过前端用户访问接口进入的,管理云的时候,是通过后端管理网进入的。两者的流量转发和流量的控制都不是在一个层面上的。

在HCIE的3.0版本的实验中,考生会有一道题目涉及到业务迁移,业务迁移基本流程就是

开启服务中心SC的用户权限(OC)

注册镜像(SC)

使用rainbow进行业务纳管

创建迁移后的目标ECS(统一门户)

Rainbow进行业务迁移验证

开始迁移

迁移完成的业务验证(统一门户)

ManageOne由以下几个部分构成:

OC运维中心:主要负责云的底层框架的维护,保证云底层不会出现故障,当出现故障的时候,OC要进行检查和排障,如果没有出问题,OC要做好监控和巡检。

告警管理:负责采集HCS中所有的组件和硬件的报错,根据严重程度,分为警告、一般、重要、紧急四个级别

资源管理:主要负责检测资源的使用情况,尤其是底层服务器的资源使用情况,包括做好资源的分配,比如哪些服务器提供ECS服务,哪些服务器提供BMS服务。

拓扑管理:根据HCS的组建情况,生成一个基于Flash的逻辑拓扑图,该图可以显示出设备的连接情况。

性能监控:监控全局所有设备的资源使用状态,这里的资源指的是CPU、内存、网络和硬盘四种资源。可以实现硬件资源使用率排名。

业务拨测:同网络拨测

智能运维:AutoOps

日志采集:支持采集全局系统和硬件设备的日志信息,并且支持输出(主要面向的是大数据分析系统)

自动作业:就是一个工作流管理系统,用户自定义好工作流如何执行,以及触发条件,当条件满足的时候,系统会手动或自动的运行工作流,执行相关工作。比如扩容。

SC服务中心

租户管理:主要是生成用户的,这里的租户面向的是通过统一门户使用云资源的用户。而站在使用云资源的用户的角度下,租户可以理解为是用户名下的子用户。管理主要涉及的就是创建、删除、修改、权限分配……

组织管理:主要是面向于公司或部门的,比如某公司的私有云,可以为不同的部门创建组织,组织之间的资源是不会共享的,同样不能跨组织查看。这样做可以保证资源隔离,不会互相干扰和抢占资源

项目管理:一般是一个部门中的不同项目使用的资源的管理。比如技术部有A产品和B产品的开发项目,那么部门的leader就可以创建两个项目,将两个项目的负责员工拉入到项目中,员工只能看到自己归属的项目的资源,这样做就可以保证资源的安全性和隐秘性,不会出现员工跨部门泄密的情况出现,另外不同项目之间的资源也是完全隔离的。但是在leader的视角,就可以访问所有的项目

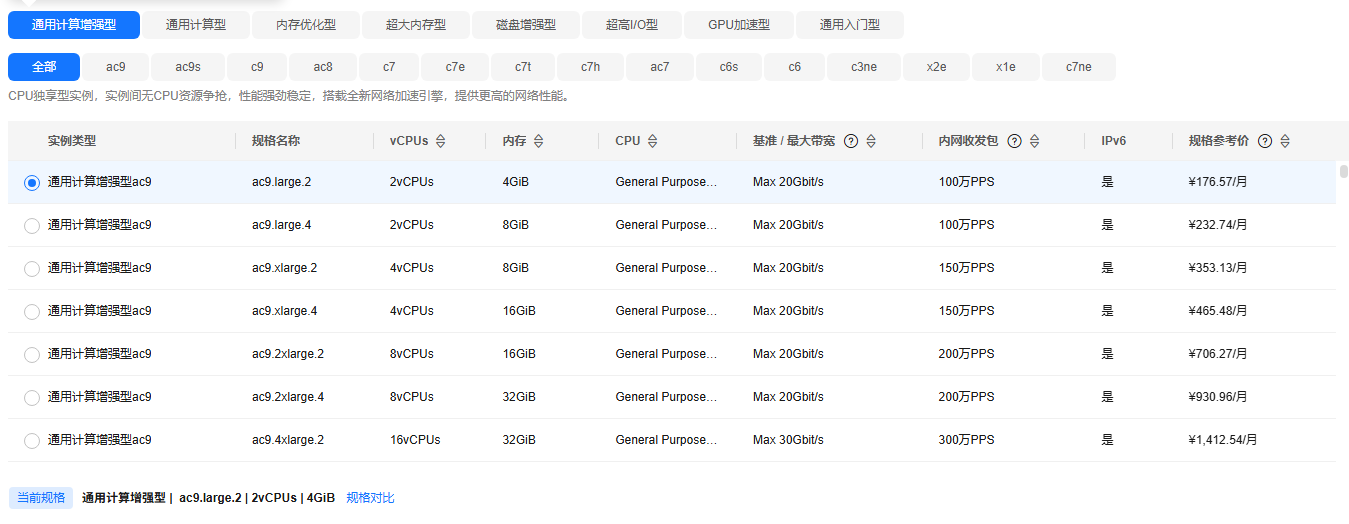

资源管理:资源管理主要是HCS的业务层面可以提供的资源配置,管理员可以在SC上设置服务可以提供的资源的清单,比如ECS的类型、规格、配置。同时资源管理还负责资源上架,比如新增服务器之后,需要资源管理将物理资源加入到资源池,资源下线也是同理

服务管理:HCS的服务内部的管理,主要包括服务上线、服务内容(比如IMS的镜像)、服务下线……全生命周期的管理

配额管理:主要管理的是资源的使用量,为了防止用户无限量的使用资源。对于资源的控制主要集中在几个层面,比如用户可以创建的资源数量,比如用户最多创建50台ECS、还可以控制用户创建的资源规格,比如内存最大可以选择128GB。

配额管理是需要遵循配额树quota tree的。所谓说配额树,指的就是用户所拥有的配额,是继承给租户或者说是子用户的。比如某用户有权限创建200台ECS服务器,那么该用户的子用户所创建的ECS数量的和就不能超过200,

应用管理:主要管理的是DaaS和SaaS以及扩展服务(OBS、BigData)

服务目录

订单管理:针对于用户提交的订单进行处理的系统,一般来说都是由系统自动分配的,比如用户提交创建ECS的请求,订单到达订单管理之后,系统会自动进行资源分配,创建ECS,一般来说只有订单创建失败的时候,才会涉及到订单管理的检测,主要做故障排查和流程监控使用。

计量计价:计算费用,用户可以进行针对于不同的服务定价,主要按照时间(计算)、使用量(网络)、申请额度(存储);同时计量计价服务还有竞价管理,折扣管理

OCC运营指挥中心

资源优化:系统可以分析当前资源的使用情况,根据系统使用状态给出优化建议,但是具体要不要执行优化,是由管理人员决定的。比如ECS的物理服务器资源使用率很高,但是BMS的资源池基本没有使用,系统就会建议进行调整优化

容量分析:主要针对的是存储资源,对接OceanStor Pacific检测底层存储空间的使用情况。

监控大屏:支持自定义显示当前系统的状态

二、华为云Stack规划设计

HCS规划设计

交付总流程

准备工作:了解客户的基本现场,并且对客户的需求有基本的认知。

HLD方案

BOQ报价

设备采购和设备上架

安装部署流程

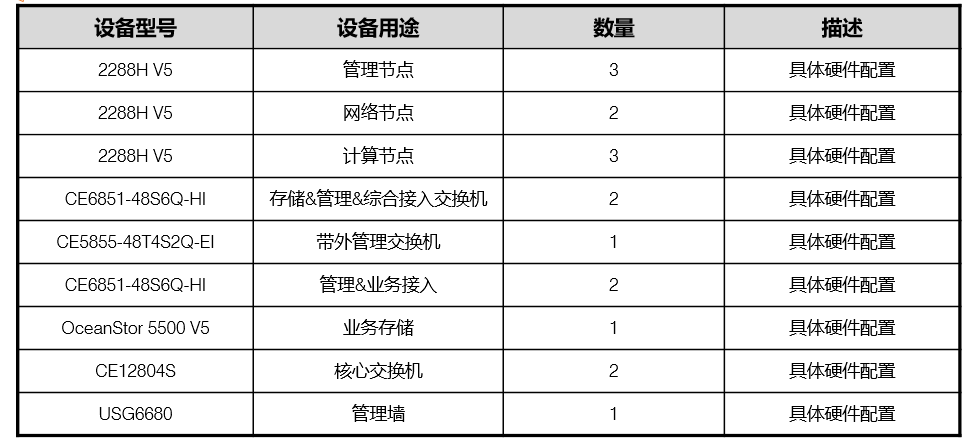

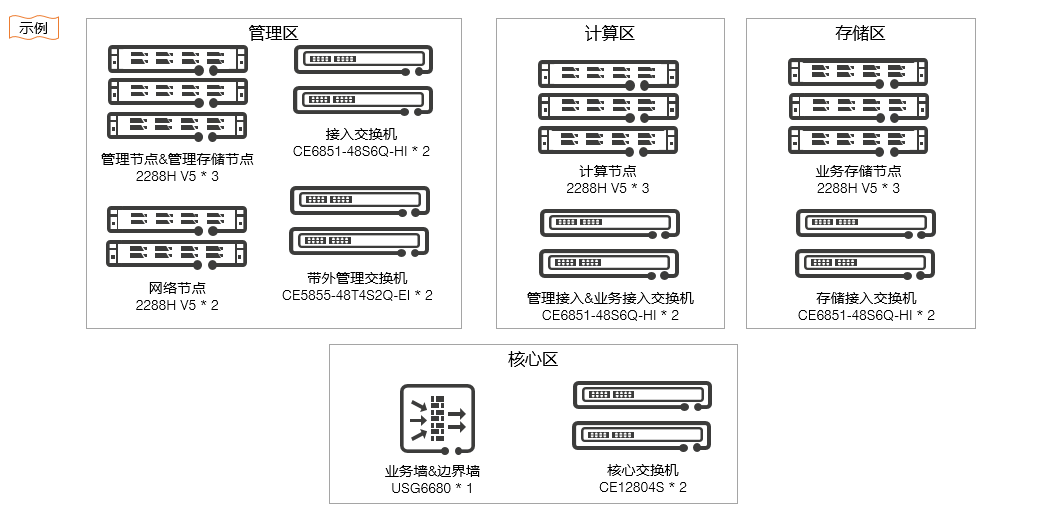

硬件架构设计

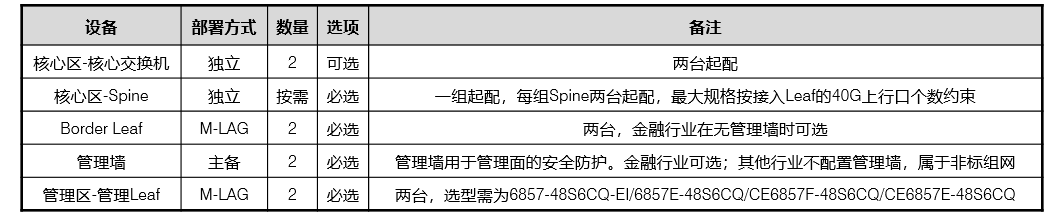

硬件设备选配

设备上架与初始化配置

准备相关资料(自动下载)

安装HCSDeploy

初始化安装,设计参数,上传安装包,自动化部署

扩展安装,设计参数,自动化部署 (BCManager——eReplication——UltraVR)

设备选配

服务器

三种角色,控制(分布式存储)+网络+计算,控制3,网络2,计算1

由于zookeeper进程的存在,所以控制管理节点最少3台。

网络主备管理,主要是提供SDN网络,需要2台服务器

计算节点提供资源,最少1台

防火墙

至少选配2台,做主备用,用于管理流量的筛查

可以选配2台WAF,做网页流量的安防

交换机

推荐至少选择CE系列园区网交换机

存储

至少配置1台IP SAN存储,用于保存核心数据;可以将控制节点的分布式存储分离,配置3台Pacific。

为什么控制节点至少需要3台?

HCS是一个分布式的系统,控制节点选择2台设备做主备实际上是不安全的,所以为了安全性保证,我们选择使用分布式集群管理系统,也就是遵循开源Zookeeper的原理进行设计。在zookeeper中,有两个角色分别是leader和follower,leader是主,follower是从,用户写数据的时候,需要写leader,由leader向follower进行同步,保证全局的数据一致性。如果是用户发起读请求,那么就选择任意一台设备进行数据读取均可。所以按照这种方式进行控制节点的部署实际上效率要远远高于主备。

zookeeper实际上是遵循设计3个及3个以上的奇数个节点

因为设备开局的时候是需要进行leader选举的,也就是每次设备重启或者进程重启的时候,leader的角色是会发生变化的,一般来说都是谁先安装完成或者是谁先启动,谁就是leader。但是在实际操作中,按照流程是需要进行投票的。还需要进行说明的是,控制节点在整体操作过程中,所有的写请求,需要经过投票同意才能进行执行,这也就是为什么不去强制制定leader而是需要通过选举确定,因为整个控制进程的运行流程都是靠投票确定的。

在投票中,我们使用的是过半制,也就是谁的票数超半数,谁就能成为leader。所以,首先最少控制节点要3台,因为少于3台无法选举。3台以上的时候,情况如下:

所以仅当设备数为奇数的时候,允许损坏的设备数才会增加

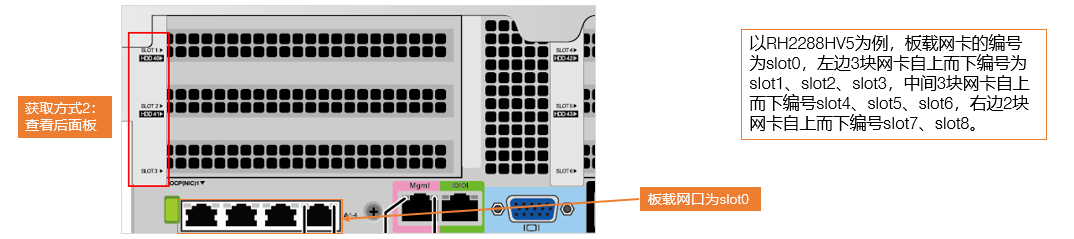

控制节点至少需要4个网口

网络节点至少需要8个网口

计算节点至少需要4个网口

HCS的流量分为了管理流量、业务流量、存储流量,管理流量和业务流量相对都不是特别的高,尤其是管理流量实际上使用非常低,在不是非常顾虑安全性的情况下,可以配置管理、业务流量合并,在一个接口发送、存储流量因为涉及到海量数据传输,所以必须独享网络接口。

HCS所有的设备接口都必须以一对的形式出现,为了保证一旦接口损坏,不会出现业务中断。

所以最简配置方法就是:控制:管理+业务、存储

网络节点的最大的作用就是做流量转发和流量控制的,所以一定不能合设流量,必须分离,所以网络节点的流量=管理流量+vRouter+NAT_LBaas+ELB_SNAT

计算节点同控制节点,两者都可以将管理和业务流量合设

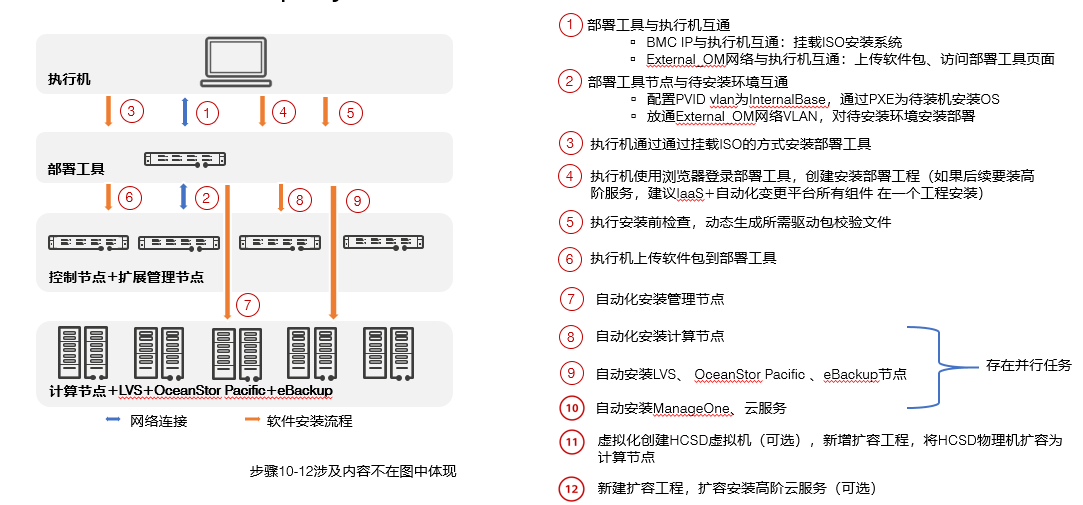

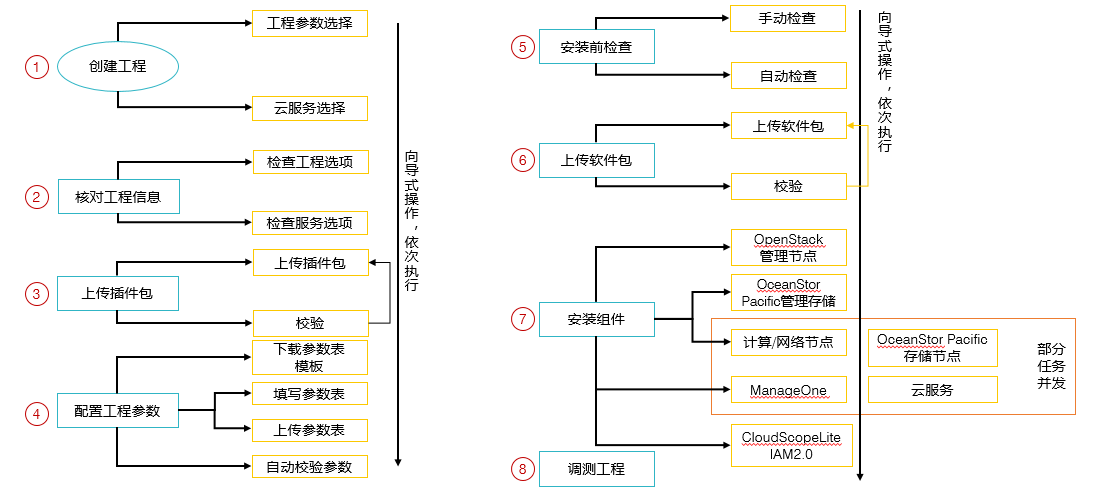

HCSD部署

HCSD工具部署流程

三、HCS网络流量概述

架构概述 传统数据中心的网络一般来说都是以三层架构作为主基准的,比如数通中经常基础性使用到的接入层、汇聚层、核心层,三层网络架构,但是这种架构在云上使用实际上是比较有难度的,因为传统架构在传输云流量的时候,延迟比较高,会造成用户体验差,另外云内部本身就有虚拟网络架构,通过OpenSwitch、OVS、SDC等方式进行实现,所以就会造成云架构内部的网络接入物理网络时,配置比较困难,对接也比较有难度。所以为了能够提升转发效率,降低转发延迟,同时减少配置难度,我们需要将传统的三层网络架构,更新为大二层网络架构

大二层网络架构出现的一个根本原因除了以上的性能问题之外,实际上还有两个很重要的无法解决的核心因素,分别是管理困难,跨架构、跨设备的网络通信。

在云架构中,当用户拥有多个云资源的时候,我们是无法保证用户一定是资源来自于同一个服务器,这些资源可能来自于机房的任意一台设备。物理上,这些资源是有隔离性的,通信需要依赖多台网络设备,但是在逻辑上,这些资源实际上是接入到了一个虚拟网络中的。比如2台ECS,可能是源自于2台物理服务器的,中间需要经历若干台设备的转发才能进行通信,但是在逻辑上,这两台设备是接入到一台交换机的,他们可以直接通过交换机进行通信,不需要三层转发。

在这种跨物理设备的情况下,我们需要做到在逻辑上让相关的资源是直连的。一般情况下都是使用代理软件(如VPN)去进行实现,但是在云网络中,这种情况是绝对不合理的,因为用户的数量很多,逻辑子网的数量很多,我们不可能创建和管理如此多的子网VPN进行跨物理架构的联通。而且用户可以自由的创建逻辑子网,这就导致当用户创建的逻辑子网的时候,我们就需要创建VPN,用户删除,VPN删除,同时用户的资源分配到哪个设备上,这个设备就要和其他的设备建立VPN连接,这个连接是指数级的。所以采用三层架构的网络第一无法解决多层网络的问题,第二无法解决跨物理网络的逻辑网络管理。

基于这些问题,我们必须要选择一种新的技术去实现云的网络需求,这种需求的实现手段,就是基于大二层网络的VXLAN架构

大二层网路最早出现就是为了解决网络中的复杂架构问题。由于早期数据中心里面有非常多的设备,这些设备都需要入网接入,所以采用三层网络架构有时候都不一定够用。有时候会有二层或者是三层的汇聚层进行接口汇聚和流量汇聚,这就导致整个架构非常的复杂难以管理。所以人们提出使用大二层架构进行方案的解决,大二层方案主要解决了以下几个问题:

三层网络,一般来说网关都是放在核心的,这就代表所有的流量如果跨网访问,首先都会转发到核心,然后由核心进行下一步转发,但是DC中,大量的流量实际上都不是访问的公网,还有很多流量是内网之间互访的,采用三层架构就会很浪费核心的网络交换资源。 在交换网络中我们经常会使用环路或者是多线连接来进行网络安全的冗余度保证。但是受限于网络转发的限制,同时为了避免广播风暴,我们通过STP协议主动地在逻辑上断开了一些端口的连接,这就导致冗余线缆的连接是很浪费带宽的。 为了解决以上的两个问题,人们提出了使用堆叠技术,堆叠技术就是通过istack线缆连接两台物理设备,让他们在逻辑上形成一台设备的方式提升整体转发性能同时提升接口带宽,但是堆叠技术能够提升的性能是非常有限的,在云架构下的海量服务器和流量转发的需求下,堆叠技术实际上是很难满足的。 VXLAN(虚拟扩展本地局域网),该技术的内涵实际上和名字有很大的关联,网络扩展使用的技术核心就是隧道。VXLAN的实现就是基于隧道技术实现的。从某种角度来讲,VXLAN实际上和VPN技术有相似性。

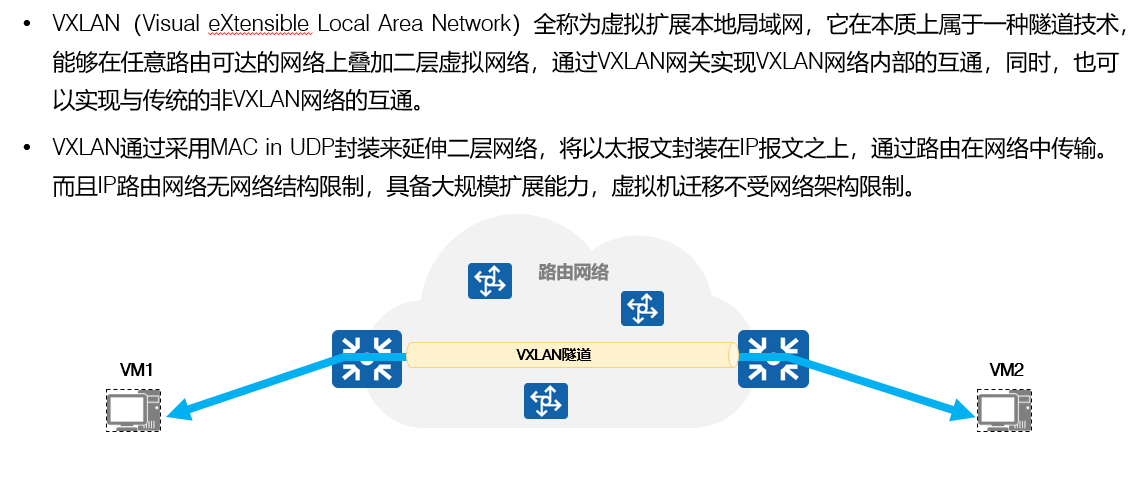

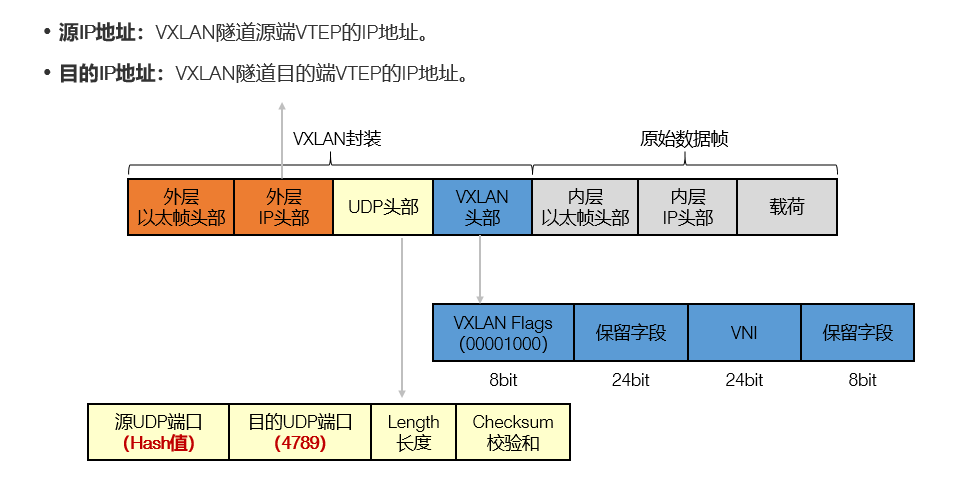

通过隧道技术我们可以在传统的路由上叠加一个二层的虚拟网络,实现VXLAN内部的互通,VXLAN使用的方式是MAC in UDP的封装方法,也就是在IP报文的基础上,封装以太网报文。受到IP网络理论上无限可达的特性,VXLAN可以进行理论上的无线扩展,虚拟机之间的通信不会受到任何网络架构的限制。

VXLAN简介

VXLAN的优势

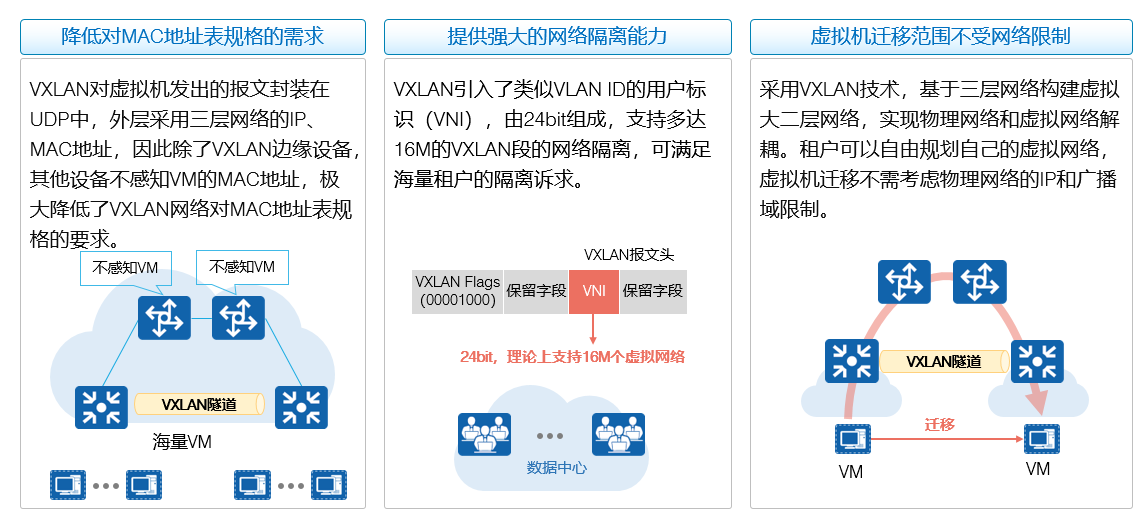

VXLAN降低了MAC地址表的规格,正常情况下,设备在进行流量转发的时候,会记录MAC地址到自身的地址表,数据在转发的过程中,都会记录发送者,即源MAC地址到本地。用于进行后续的通信,但是在大型网络架构中,设备数量过多,会导致转发的网络设备的MAC地址表过大,造成查询延迟和转发延迟,而通过VXLAN的封装,我们可以隐藏MAC地址,因为发送者的MAC地址是被封装在UDP中的,所以对转发的网络设备实际上是不可见的。这就可以减少网络设备对MAC地址的记录,降低查询延迟 使用VXLAN可以将物理网络中的资源进行隔离,通过VNI,VXLAN Network Identifier网路标识,可以实现海量网络的隔离需求,满足用户的实际使用。通过VXLAN的VNI,我们可以将一个物理设备上的云资源分配不同的VNI,不同VNI的设备之间是无法通信,这样做有一个好处就是资源可以得到真实的隔离性,而且即使不同的用户使用的是相同的网络,也不会出现冲突,只要VNI不同即可。 通过VXLAN,我们将跨物理资源的逻辑资源,在逻辑上直连起来了,这样当我们需要对这些逻辑资源做操作的时候,就可以按照内网的操作方法进行操作,极大的减小了操作难度。

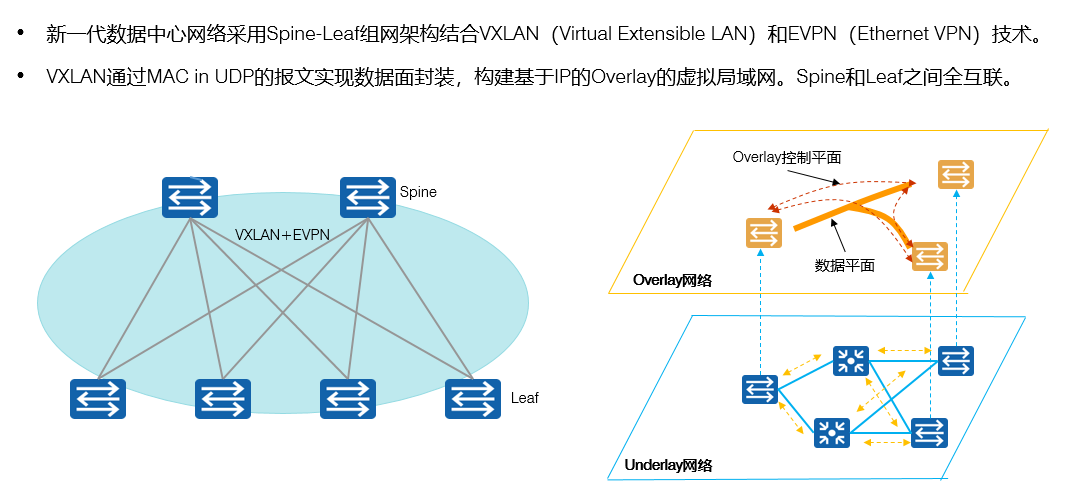

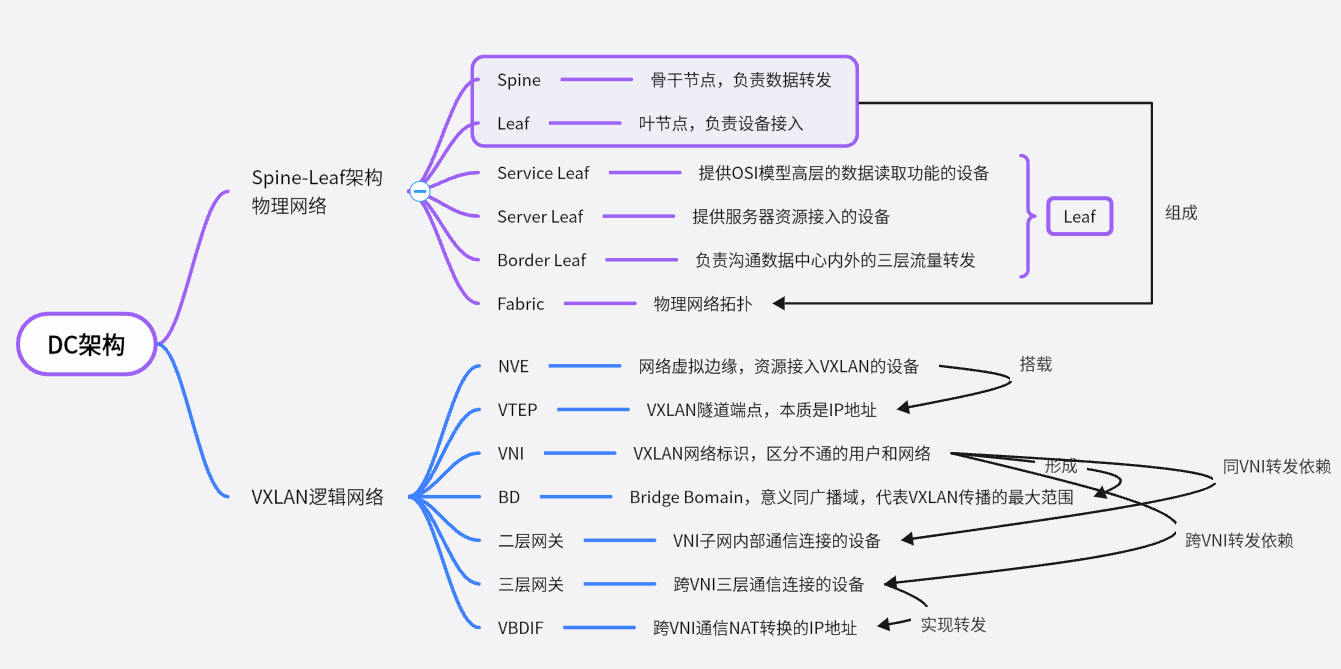

VXLAN网络架构 - Spine-Leaf

spine-leaf架构基本概念

Spine-leaf架构实际上是源自于DC中的一个核心概念,主要是用于建设基于VXLAN的大二层网络使用的。其中主题的组成部分如下:

spine:骨干架构,骨干节点是整个底层网络的核心节点,主要用于高速转发,通过spine我们可以连接到各个leaf节点。可以理解为是核心层。受限于骨干节点的海量数据转发,spine架构的设备必须选择高性能设备,如华为园区网交换机CE系列,尤其是CE6800系列。

leaf:叶节点,作为终端接入的设备,功能等同于三层网络架构下的接入层。一般来说由满足客户带宽需求的设备构成,如华为S系列交换机,其中比较典型的就是S5700系列。

Fabric:由spine交换机和leaf交换机构成的物理网络拓扑,也就是我们说的底层物理网络

service leaf:服务叶节点,主要是提供防火墙、负载均衡功能,这些功能可以满足OSI七层网络架构模型中的L4-L7级流量转发的需求(L1:物理层,L2:数据链路层,L3:网络层,L4:传输层,L5,会话层,L6:表示层,L7:应用层),这里所指的满足L4-L7的转发,实际上就是指Leaf节点能够识别到L4-L7级的流量,能够对这些高层报文进行拆解和读取,一般用于VXLAN网络中进行数据的筛选和控制,如防火墙的安全控制,负载均衡设备的LVS转发。目前,Service Leaf设备一般选配华为防火墙USG6500系列,负载均衡设备一般会选配深信服、F5、启明星辰、A10

Server Leaf:服务器叶节点,主要是提供虚拟计算资源入网的功能,比如华为的ECS、BMS、CCE等相关服务的接入网络

Border Leaf:主要是提供跨数据中心级别的网络通信的转发,毕竟数据最终还是要到达公网,或者是到达分支站点,那么跨物理网络的连接,就需要通过Border Leaf去进行实现。

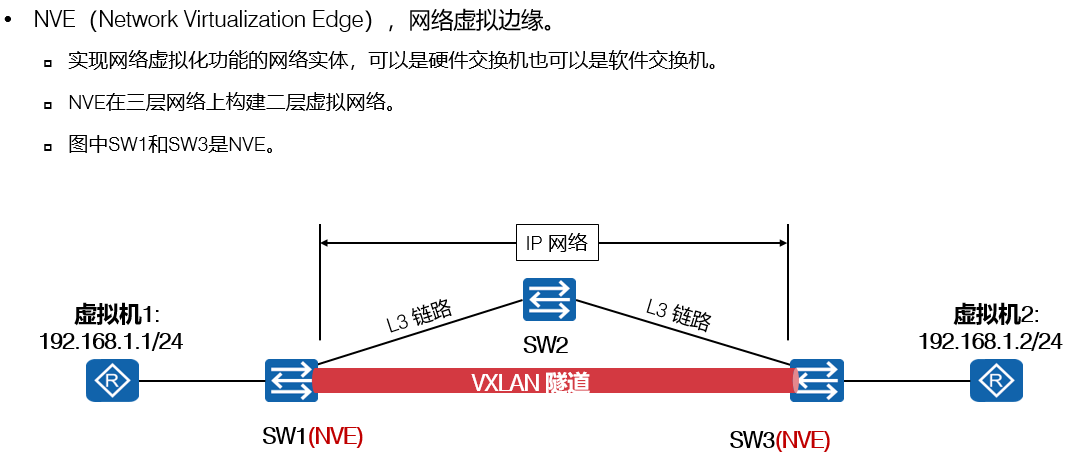

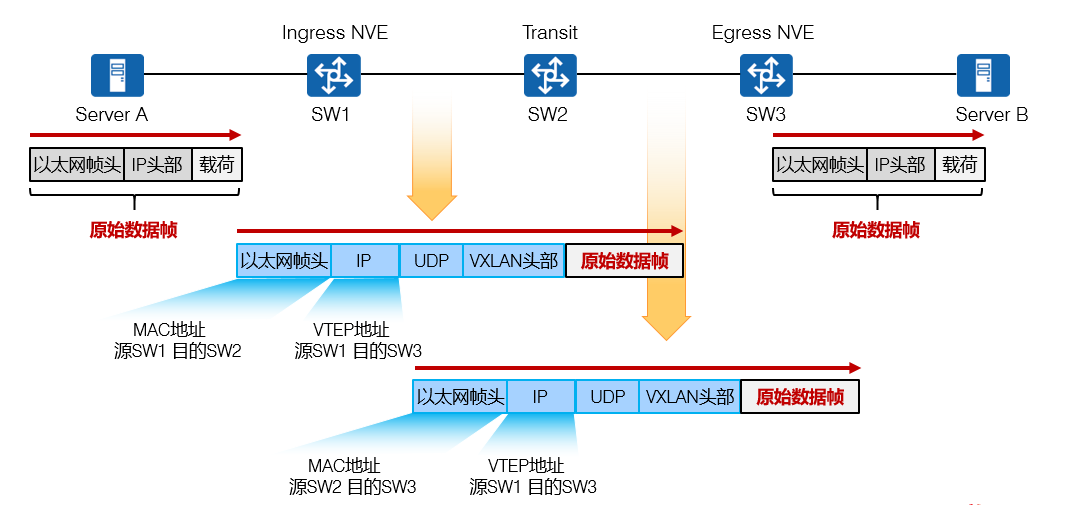

VXLAN基本概念及工作原理:NVE

NVE:网络虚拟边缘,通过NVE我们可以实现将传输过程中所有的物理设备无视的操作。也就是我们从源到目标端,除了源的接入和目标的接入,中间所有的设备在逻辑上都是不存在的,我们通过隧道打通两个边界,让虚拟机达到在一个子网内的效果。

NVE的核心功能就是在物理架构上实现了虚拟网络,可以说VXLAN的底层工作基本都是由NVE进行的控制,转发网络的架构也都是由NVE进行的隐藏。

也就是说,从NVE开始,到对端的NVE,中间的网络都是被屏蔽的。

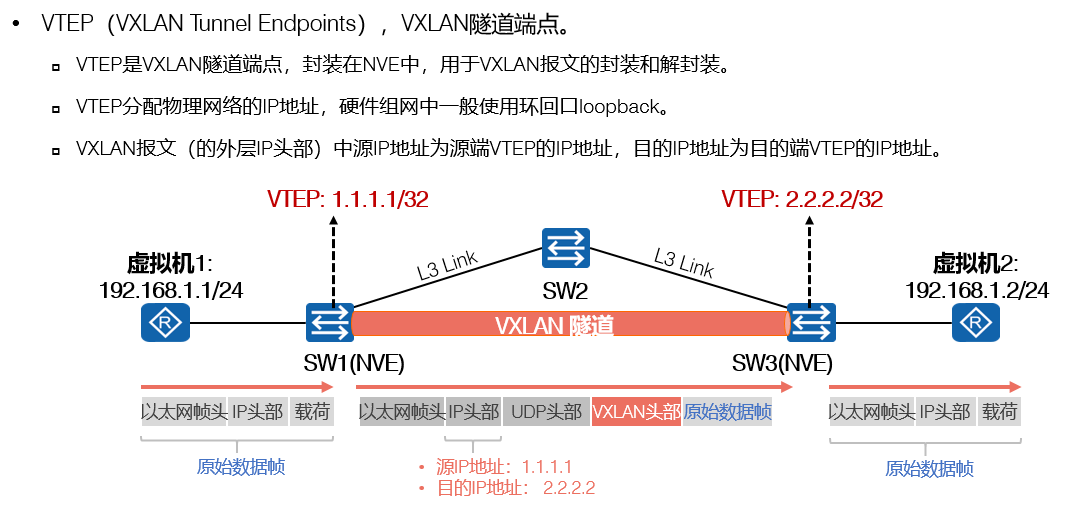

VXLAN基本概念及工作原理:VTEP

相较于NVE来说,VTEP实际上可以被理解为是一个逻辑的概念,或者说是一个配置级别的概念,通过VTEP我们进行封装和解封装的操作,VTEP是NVE的核心,即NVE实现大二层虚拟网就是通过VTEP实现的,NVE代表的是一个物理化的概念,而VTEP是一个逻辑上的概念,VTEP一般来说是由一个本地环回接口的IP地址组成的。NVE在转发VXLAN的流量的时候,就不在以底层的IP地址作为通信的源和目标IP,而是以VTEP的IP地址作为源端和目标端的。

VTEP为什么会选择配置在LoopBack接口呢?

因为LoopBack接口是本地环回接口,这个接口是设备的一个逻辑接口,它的好处就是稳定,不会由于任何一个物理接口的损坏而下线,仅当设备本身出现了物理损坏的时候,LoopBack接口才会down掉。正是由于这种接口类型的稳定性,我们选择VTEP配置在这里。但是从配置角度上来说,VTEP配置在物理接口上也不是不可行的,只是从稳定性上来说,非常的不建议。

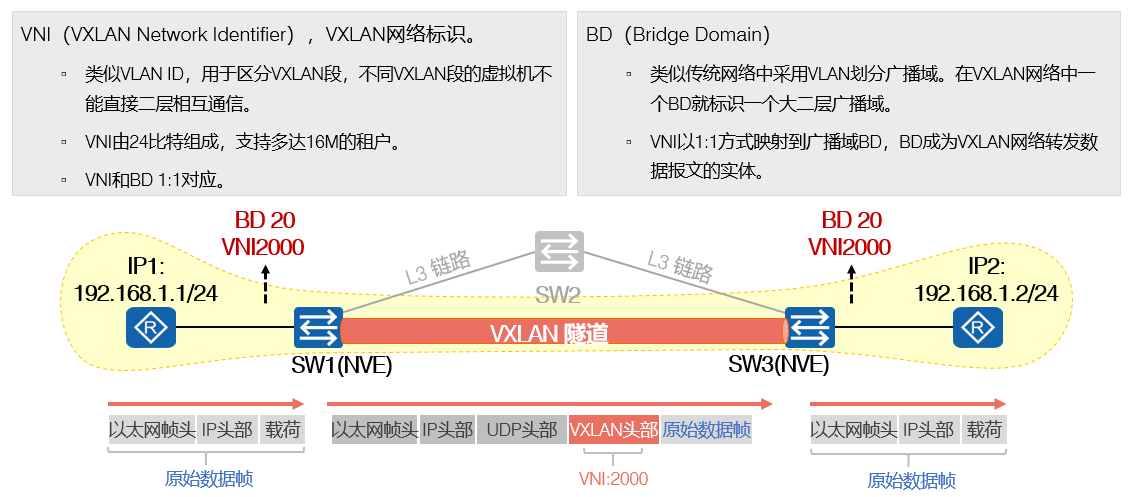

VXLAN基本概念及工作原理:VNI与BD

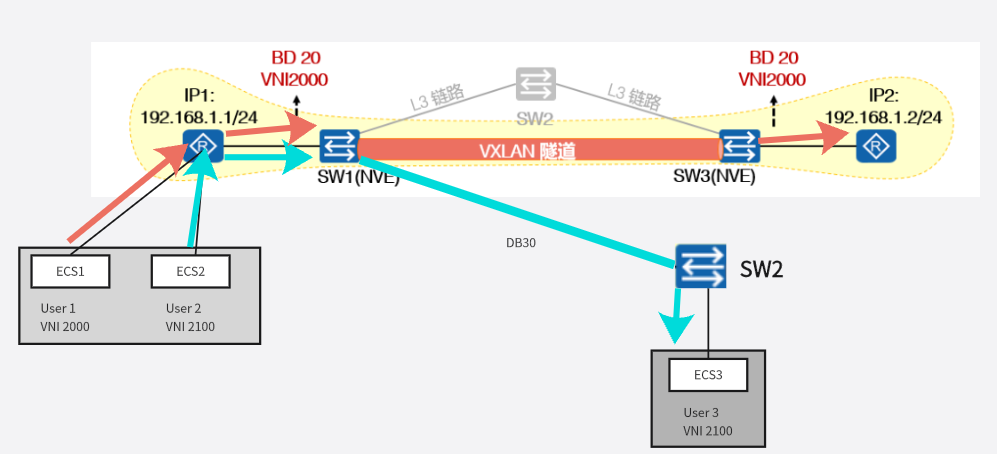

VNI:VXLAN网络标识,通过VNI可以区分不同的VXLAN的网段,不同VNI的资源之间无法直接通信,也正是因为这种特性,在云中,我们可以给每个用户的VPC分配一个全局唯一的VNI,这样做即使不同用户使用的是相同的IP,但是通过VNI的屏蔽,我们仍然可以保证他们在内部是能够转发和正常使用的。

BD:Bridge Domain,实际上个人认为应该称之为叫做BrodeCast Domain广播域,每个被分配了VNI的用户,其资源在进行通信的时候会有一个传递的范围,这个范围就称为BD

也就是说,VXLAN中相关的虚拟资源在发送一个广播包的时候,这个包所能传递的最大的距离,实际上就是BD距离。每个VNI的BD都不完全相同,而且一个VNI对应一个BD。

NVE是一种角色,只要成为了边界设备,就是NVE,NVE可以承载多个VNI的流量,也可以被不同的BD划入。

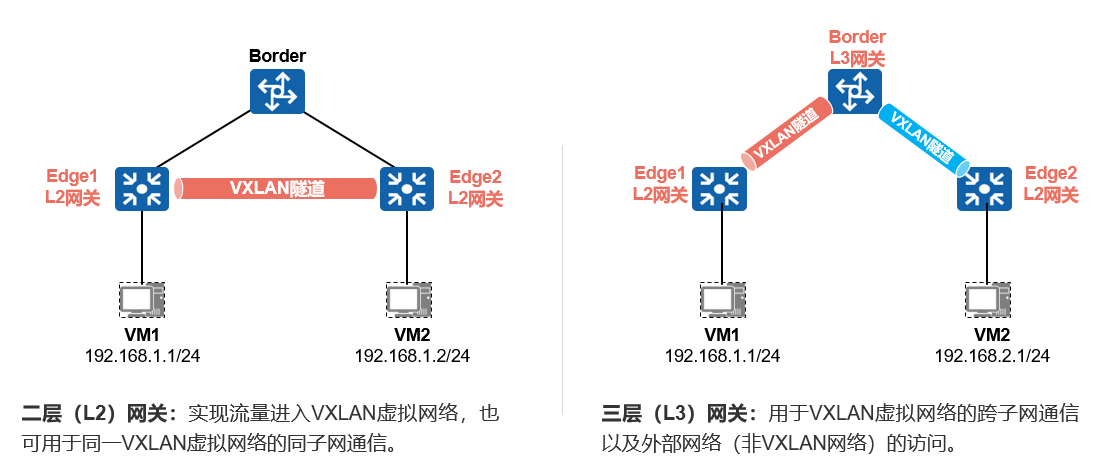

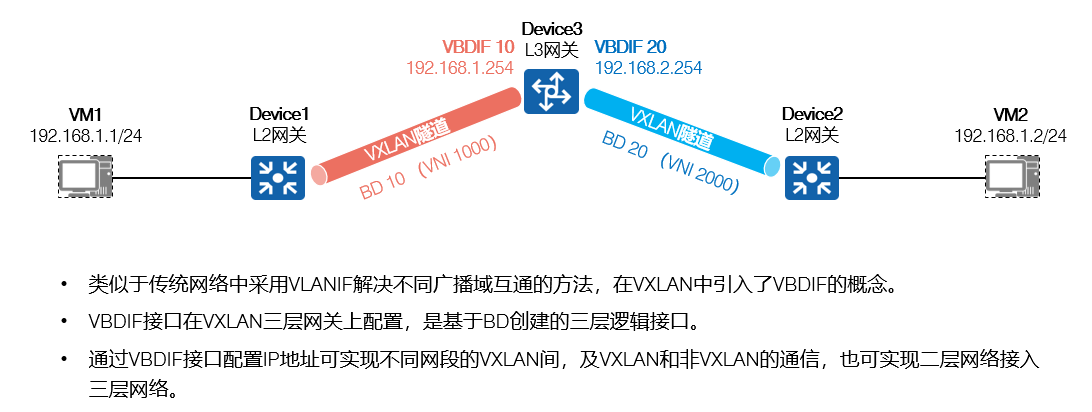

VXLAN基本概念:VXLAN二层网关、三层网关

二层VXLAN正常情况下,一般来说设备之间的交互都是已通过二层转发就可以实现的,设备和资源之间的访问,在VXLAN的前提下,可以直接在Leaf或者是Spine上实现。这时候,我们实际上流量在逻辑网络中看来是没有经过三层转发的,这时候进行数据转发的设备就叫做二层网关,二层网关主要是用于VNI子网内部通信,但是如果说某个资源需要进行跨网络的转发,也就是在逻辑网络的层面,也需要进行跨网转发的时候,这种情况下就需要用到三层网关了,三层网关一般是比Spine和leaf级别更高的核心交换机,核心的交换机可以实现跨网络的海量数据转发,这种设备是逻辑层实现三层转发的核心。

二层网关一般就是NVE

三层网关一般是Border Leaf,三层网关

VXLAN基本概念:三层网关VBDIF

VBDIF就是三层网关的核心,三层网关进行转发的时候,需要使用VBDIF进行通信,同样不是使用底层的物理网络。VBDIF的地址是可以在底层物理网络通信的,也可以在VXLAN网络中通信。只是说在底层网络中,VBDIF就是普通的转发IP,到VXLAN中VBDIF就是BD的边界,也就是说VBDIF隔离了BD域。

VXLAN的报文格式

VXLAN数据封装过程

总结:

VXLAN(组件虚拟网络的技术核心):虚拟扩展本地局域网,通过隧道的形式,将物理上有隔离的资源,在逻辑上连通起来,使其二层互通。

物理网络:指的是构成VXLAN连接的基础IP网络

逻辑网络:指的是通过VXLAN构建的虚拟网络

NVE:网络虚拟边缘,资源连接时,接入的设备角色就是NVE,NVE负责将中间的链路进行屏蔽,使两个逻辑资源在虚拟网络上二层互通。

VTEP:VXLAN隧道端点,本质是一个配置在LoopBack本地环回接口的IP地址,VXLAN的NVE进行通信的时候,就依据VTEP的IP进行转发(二层)。

VNI:VXLAN网络标识,区分不同的VXLAN的标识,一般来说一个子网或者是云中的一个用户独享一个VNI,VNI一共是24位,支持16M个VXLAN子网。不同子网不能通信,VNI是构成云VPC虚拟私有云的关键技术

BD:一个VXLAN中某个VNI的网络在发送广播的时候所能传输的最大的距离,就是BD,Bridge Domain,也可以被理解为是Broadcast Domain。每个VNI都有自己独立的BD,互不冲突,具有不同的VNI的BD不完全相同。

二层网关,数据进行二层通信的时候,即VNI内部通信的时候,转发的设备就是二层网关,一般来说二层网关就是NVE

三层网关,数据需要进行跨VNI的通信的时候,或者是数据需要访问VXLAN之外的网络的时候,就需要三层网关设备进行数据转发

VBDIF:三层网关通信的时候,需要进行NAT的地址转换,转换的地址就是VBDIF。通过VBDIF接口将VNI内部的子网IP转换为VBDIF的接口IP进行对外访问。

Spine-leaf架构(组件物理网络的架构核心,是设备的角色)

spine:骨干节点,负责数据转发

leaf:叶节点,负责设备接入

Fabric:物理网络拓扑

service Leaf:提供OSI模型高层的数据读取功能的设备

Server Leaf:提供服务器资源接入的设备

Border leaf:负责三层转发的设备,一般是沟通数据中心内外的流量转发

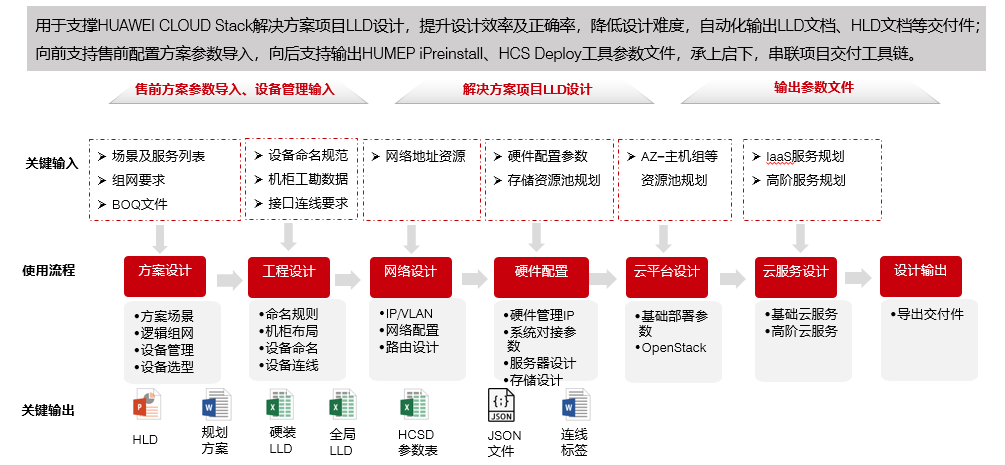

四、华为云Stack LLD设计

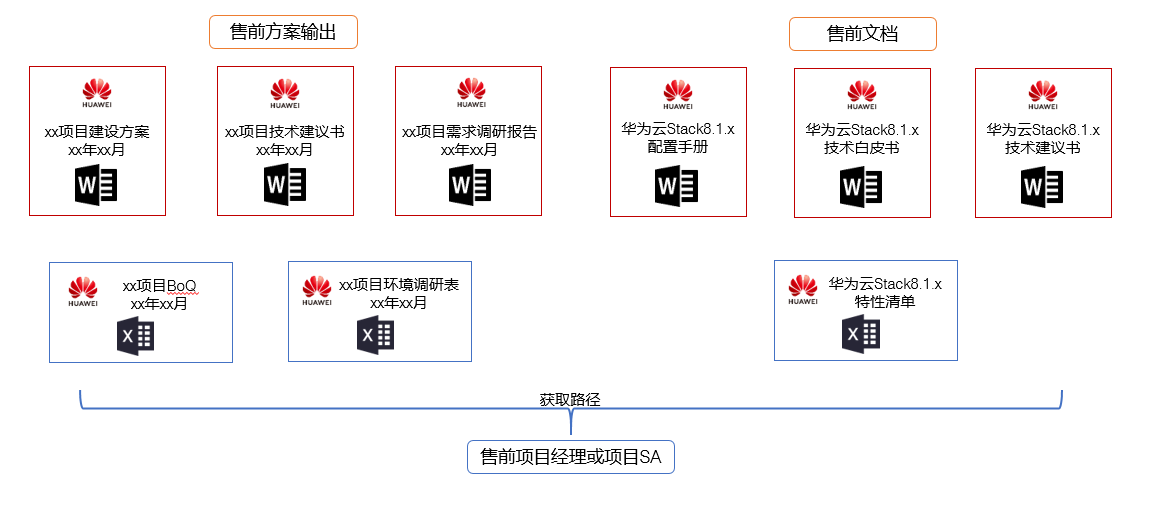

LLD设计输入材料

需求调研

建设背景(HCS Designer无法生成,需要自己写)

客户介绍

运营现状

数据中心调研(设备数、容量、业务类型)

客户需求和业务冲突

客户需求目标(简单业务目标)

建设目标(HCS Designer无法生成,需要自己写)

资源目标

参数目标(带宽、延迟、存储空间、响应速度……)

其他目标(备份、容灾……)

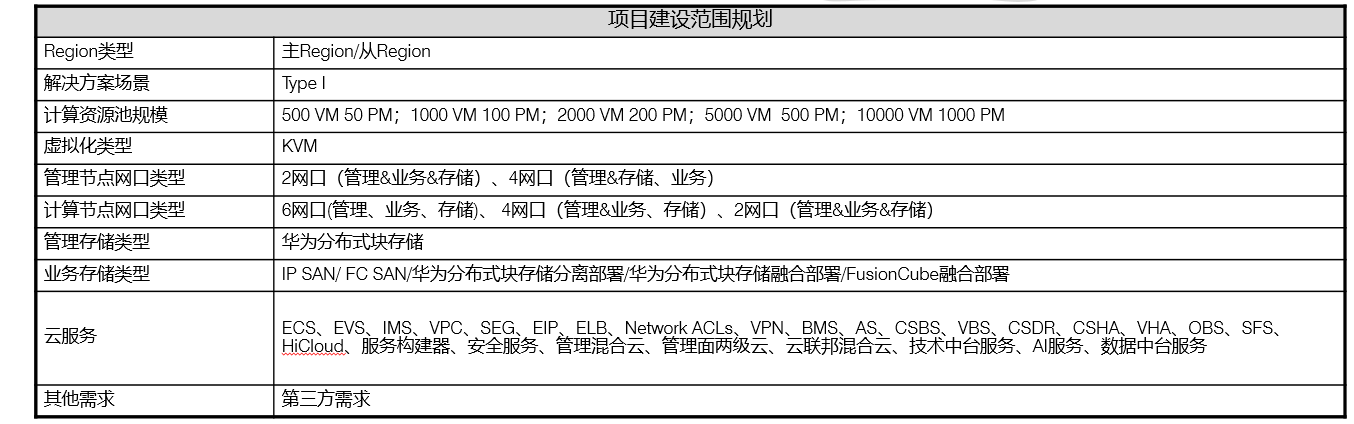

建设范围(怎么建设、建设什么?软件层面,自动生成)

项目物料概述(设备和硬件层面,自动生成)

架构设计部分

逻辑架构设计

主要是HCS的业务安装选择以及控制组件、管理组件的安装配置

物理架构设计

包含组网、连线、以及底层架构的设计

设备选型

主要是硬件设备的选型设计,实际上和项目物料概述是有一定的重复性的,所以这个部分一般来说要写的是硬件和功能的对应,比如哪些型号的服务器要安装什么类型的服务

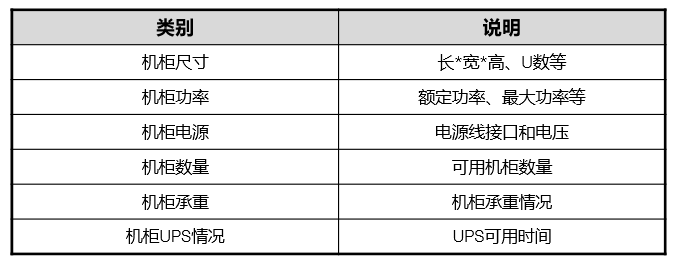

机房基础信息

规划LLD前,需要根据工勘结果获取如下机房基础信息,机房信息直接影响到机柜部署设计以及设备间连线情况。

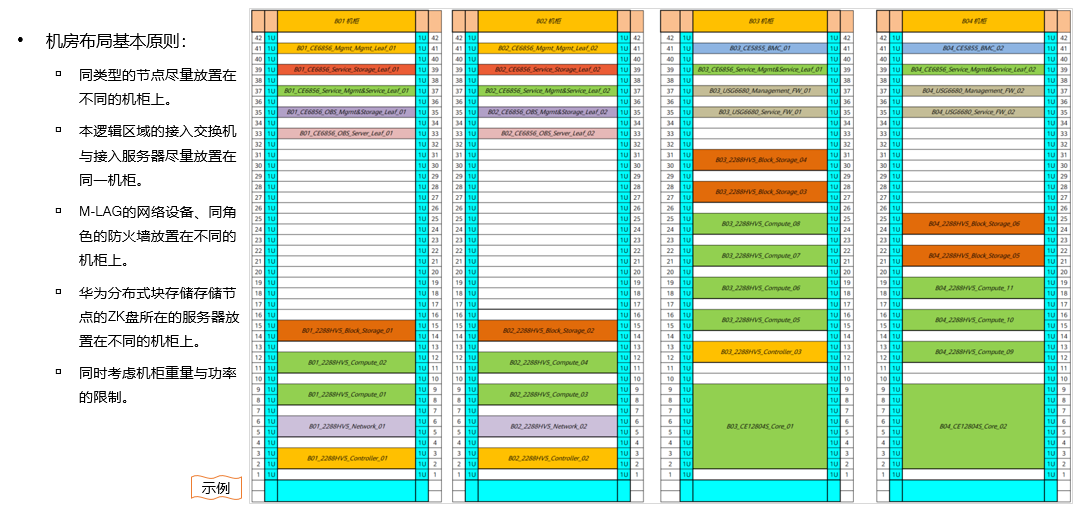

机柜部署方案

自动生成,系统会选择安全性最高的方式进行部署,主要依赖的就是以下几条规则 大型设备放下边,小型设备放上边

机柜连接的TOR包括BMC-TOR、管理/业务TOR、存储TOR等交换机,都是放在机柜的最上边 功能相同的交换机,一定要放在不同的机柜上

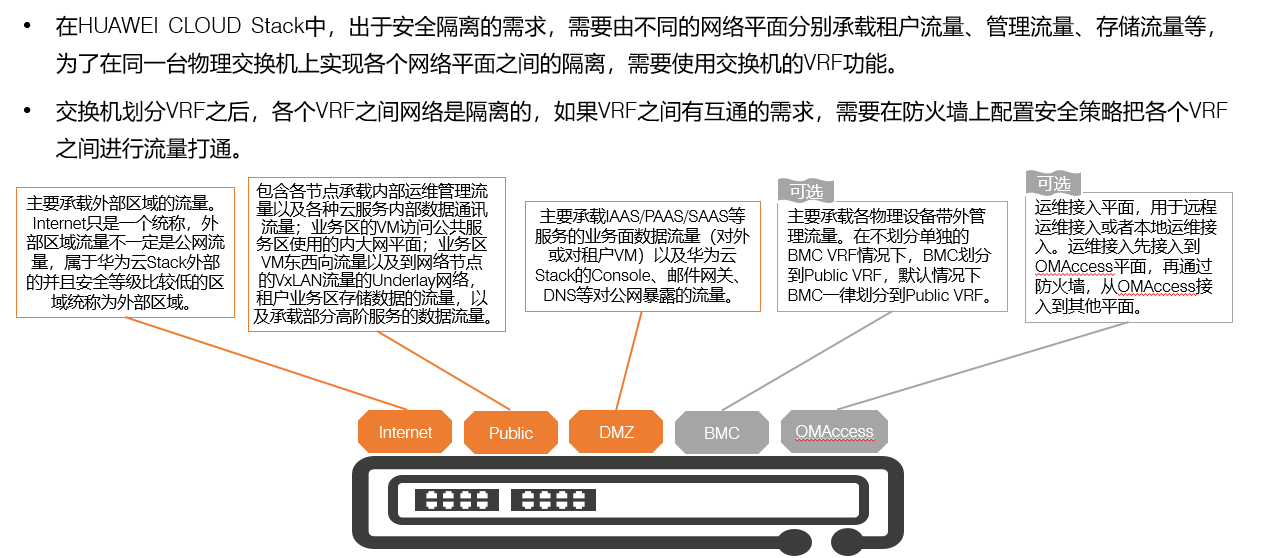

设备命名

根据自动化设计输出,主要命名方案为:机房缩写-机柜编号-设备位置-功能区-功能组件-设备型号-设备编号,例如DC1-A02-37U-Mgmt-BMCSW-CE6530-01

HUAWEI CLOUD Stack系统中每个设备建议包含如下物理属性:机房编号、机架编号、位置、功能区域、功能组件、物理设备类型、槽位编号,也可依据实际项目需求自定义命名规则。设备命名规则:

机房缩写:根据项目实际机房名称缩写为XXX,如DC01。

机柜编号:按照A-Z字母+编号,A01-C08。

功能区域:管理区(Mgmt)、业务区(Service)、OBS服务区(OBS)、核心交换区(Core)等。

功能组件:核心交换机(Core_Switch)、控制节点(Controller)、云服务节点(CloudService)、计算节点(KVM)等。

设备型号:2288H_V5、CE6855、5500_V5等。

设备编号:01~99,同一机柜中同一类型设备编号从下到上递增。

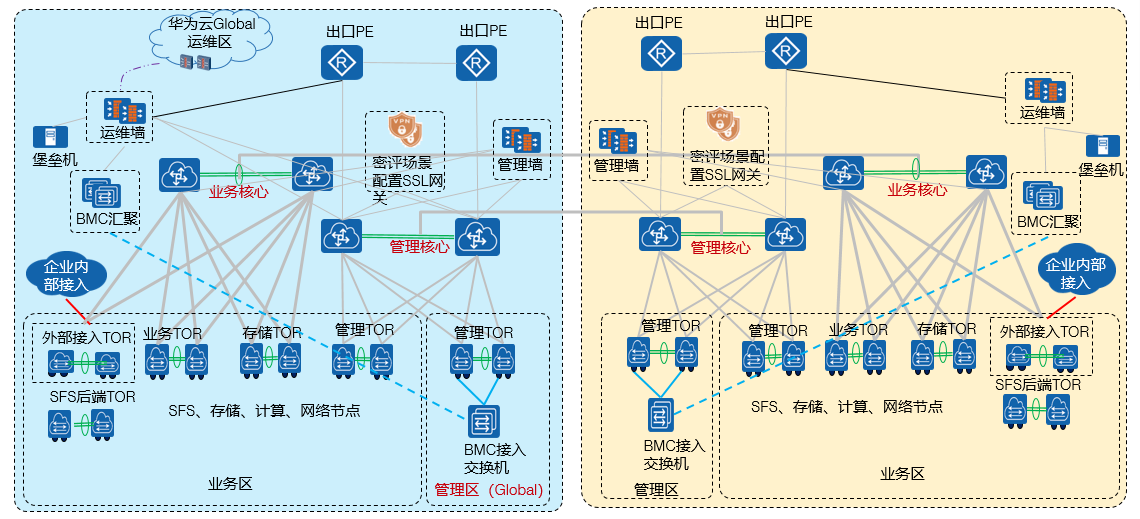

网络设计

管理区

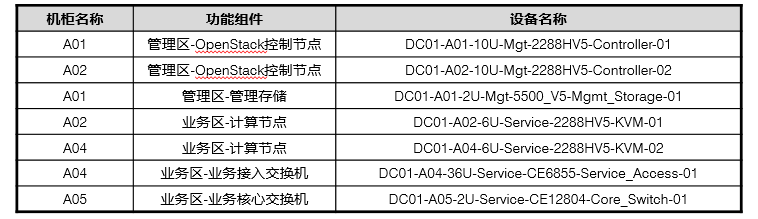

公共网络平面: External_OM(OpenStack Manager):云平台管理平面,主要负责运维的接入,存储管理平面的接入、对接外部管理源(NTP、DNS、SYSLOG),同时负责后端VM、DB(内部DB)、VM内部网络的管理。 DMZ_Service(服务区服务提供):主要负责云服务使用的公共服务的提供,如LVS、Nginx负载均衡服务,云服务Console类接入,租户相关的全局类服务。即提供了全局云服务的管理和通用业务的提供 存储平面: Management_Storage_Data:管理存储平面 Service_Storage_Data:业务存储平面 OpenStack管理平面: Relay_Network:内大网平面,主要是针对于全局云服务所需要的公共服务进行网络提供,保证全局资源可以通过一个统一网络进行连接和沟通,因为提供的公共服务面向于所有的用户,所以这些资源需要使用一个全局唯一的IP进行接入,所以内大网必须要大范围的IP提供 Internal_Base:内部管理平面,主要是负责pxe的提供,即DHCP启动服务,OpenStack通过该平面进行运营运维信息的获取和采集

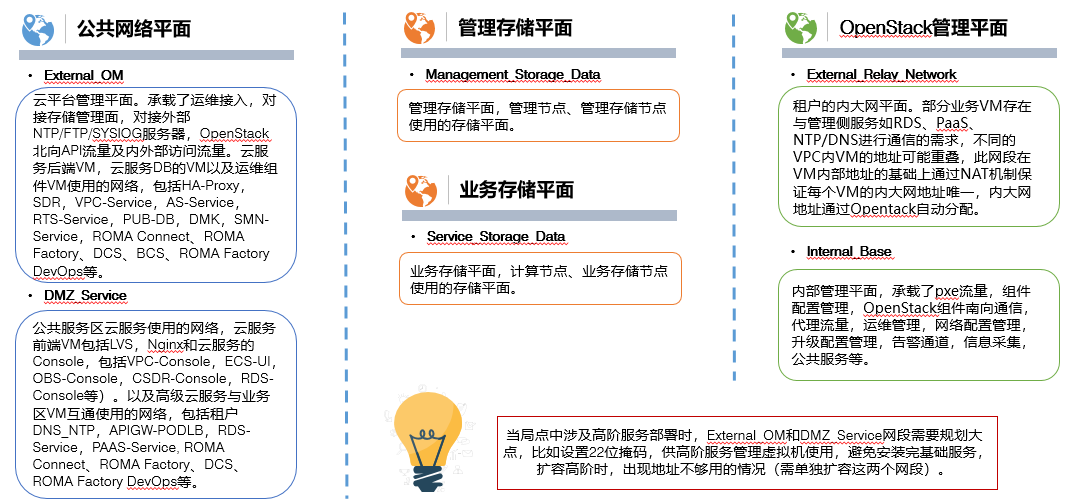

IP/VLAN规划:

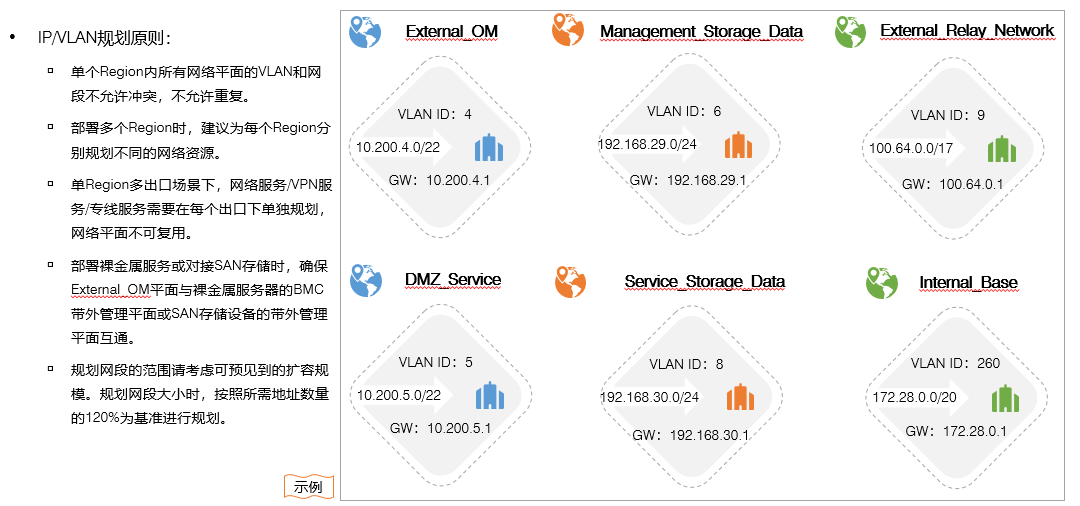

交换机VRF(虚拟路由转发)设计

交换机中不同功能的接入和流量必须要做好隔离,不允许在交换机层面进行互通

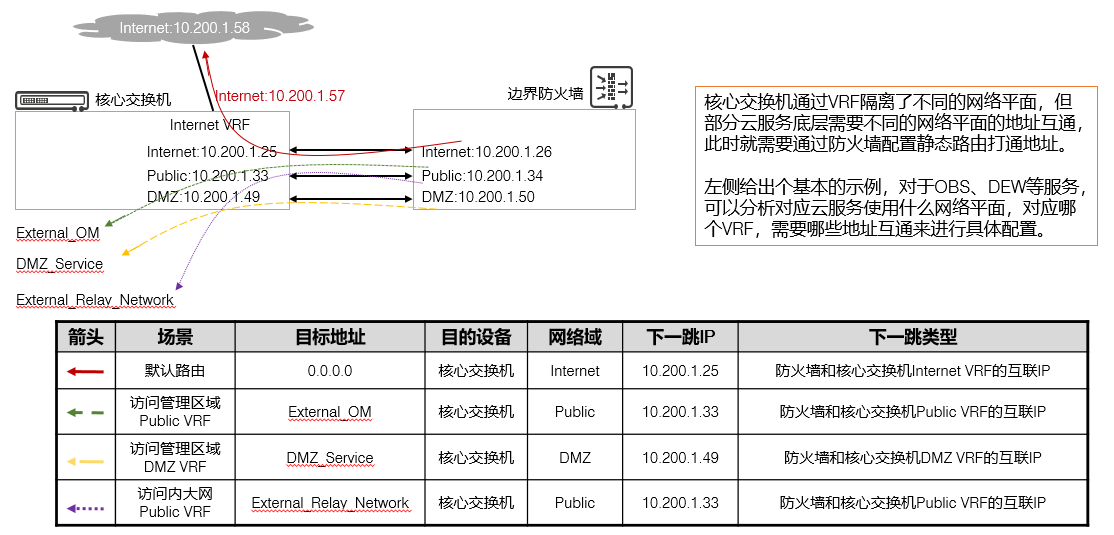

如果真的平面之间需要进行互通,则需要通过北向转发,到防火墙层面通过安全策略开放互通

交换机的几种流量设计

InterNet:主要是承担外部访问流量,虽然名字叫互联网,但是实际设计的时候,只要是从外部来的流量,都属于外部访问流量,这个流量可以来自于公网,也可以来自于内部的东西向或者是南向流量。所以这种流量名字也可以被叫做External

Public:也称为公共区流量,主要传递的是内部运维流量和云服务之间通讯流量,包括前往内大网、东西向以及VXLAN相关的多种流量都是通过公共服务平面转发。

DMZ:主要负责的是云服务业务流量,包括对公网进行暴露的服务的流量。

BMC:底层带外管理流量,一般不建议管理业务流量和带外管理流量通过一台服务器进行转发,最好是底层带外管理流量接入专门的交换机进行统一纳管

OMAccess:运维接入平面,主要是远程接入和本地运维使用,属于可选项,一般来说可以和管理业务平面使用相同的交换机。但是在高安全的场景下,比如等保和涉密场景,业务、管理、带外管理、运维需要通过不同的设备做物理隔离。

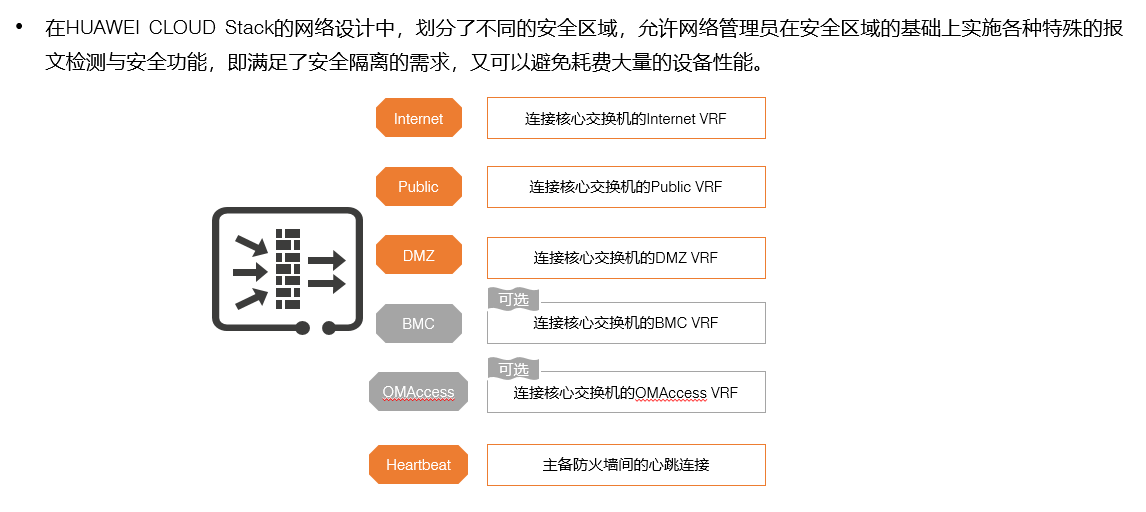

防火墙域设计

为了能够满足网络安全性需求,我们将不同设备接入的物理连线划分到对应的domain域中,通过安全区域的设计,将各种流量进行隔离,根据用户的需求,底层交换机有多少个网络平面类型,防火墙就应该有多少个安全区域

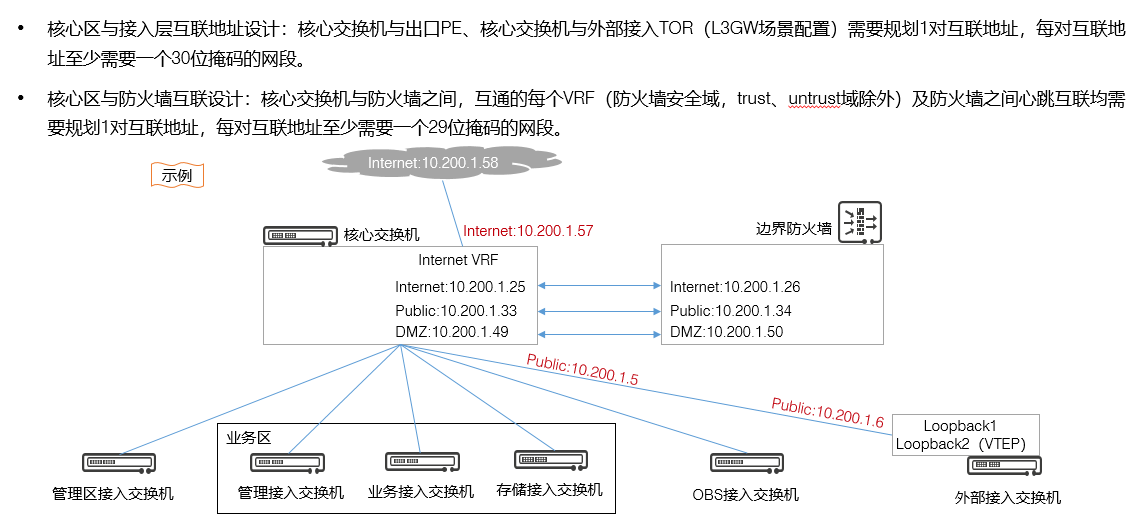

网络互联设计

核心网互联IP规划需要遵循可用,足够使用即可,不要多分IP,即交换机和出口PE或外部接入TOR之间的访问,IP地址至少需要一个30位掩码的IP规划。如果交换机连接不同设备使用不同网段,那么就配置30位掩码,即2个可用IP配置在连接的设备两端。多设备使用相同的VLAN时,根据实际需求按需分配。

核心区和防火墙互联的时候,需要保证交换机的每个平面或者说是防火墙的每个安全区域都要和核心交换机有一个网段做互联,不要使用相同网段的IP。每对互联的地址,至少是29位IP(6个可用IP,防火墙1,核心交换机1,接入TOR1,业务服务器1),根据实际提供服务的服务器的数量进行合理划分,建议超分50%

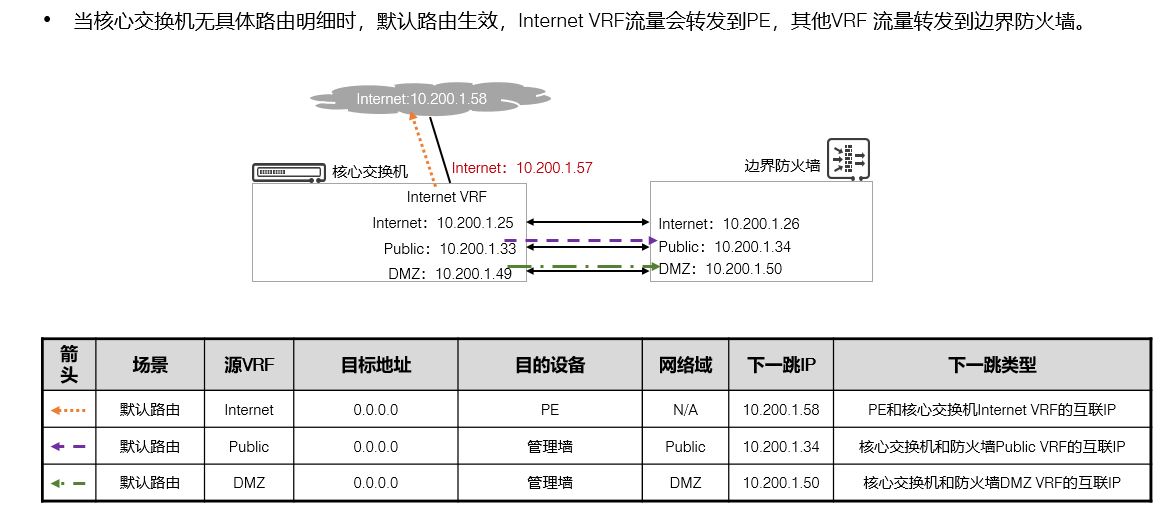

静态路由设计

交换机对于整体性转发或默认路由转发都需要以静态路由配置,静态路由需要完成几个任务

默认路由到PE:负责对外转发流量

默认路由由核心交换到管理墙:负责将网络平面的流量转发到防火墙的安全区域网关或VRF,每个VRF都需要有默认路由的存在。

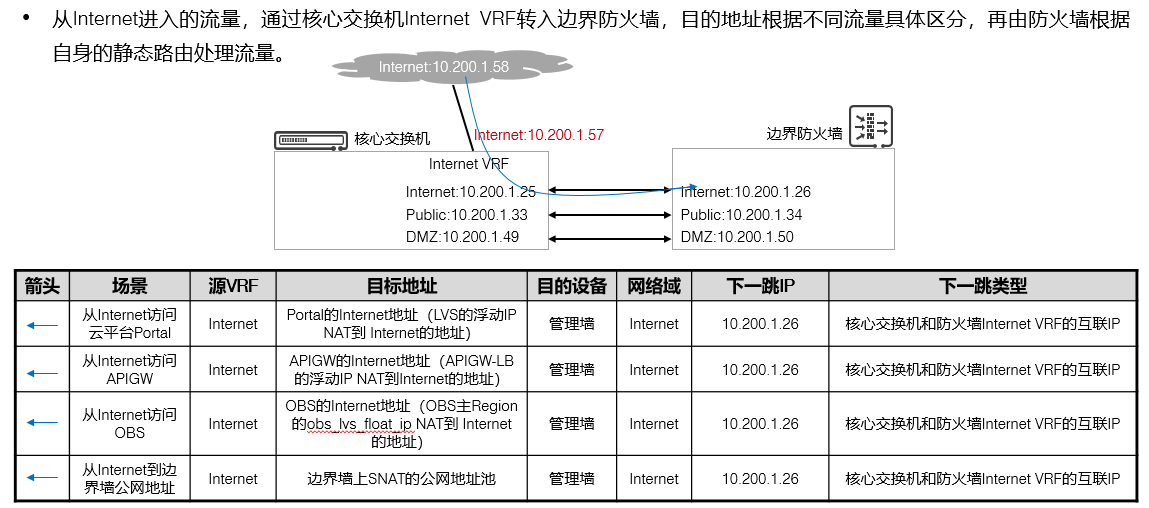

公网访问:公网访问的流量,首先需要通过核心交换转发到防火墙进行安全检查,所以访问内部的流量都需要先行转发到防火墙,然后再通过核心交换转发到对应的位置

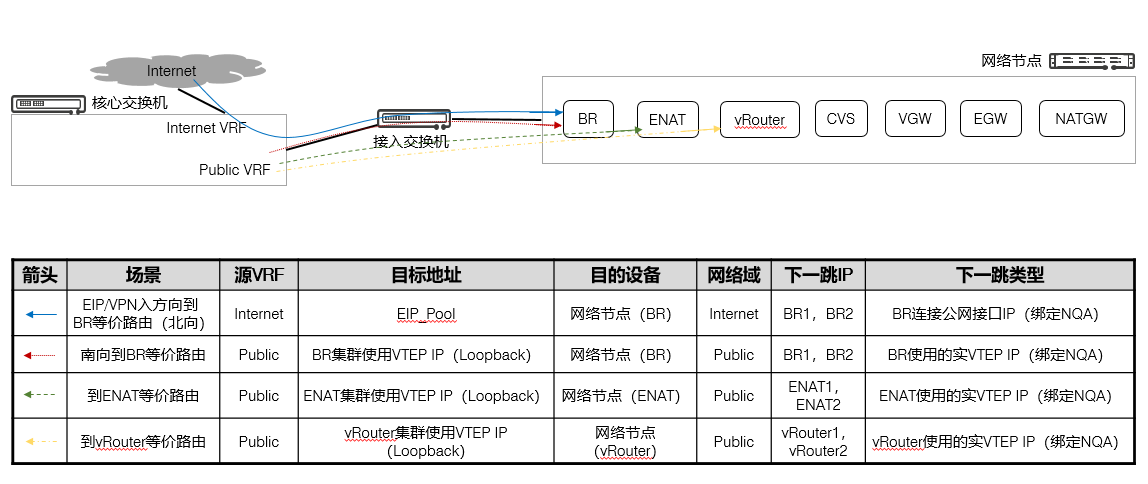

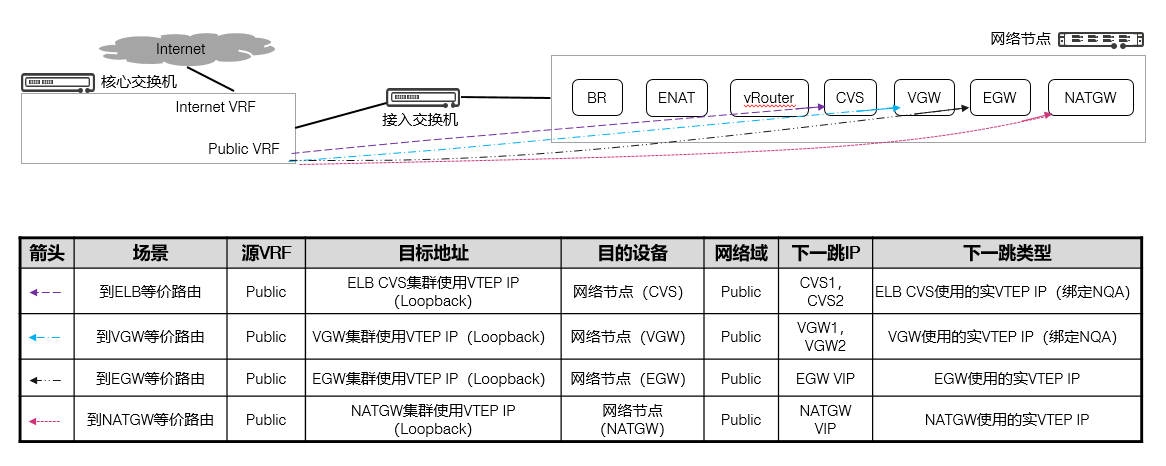

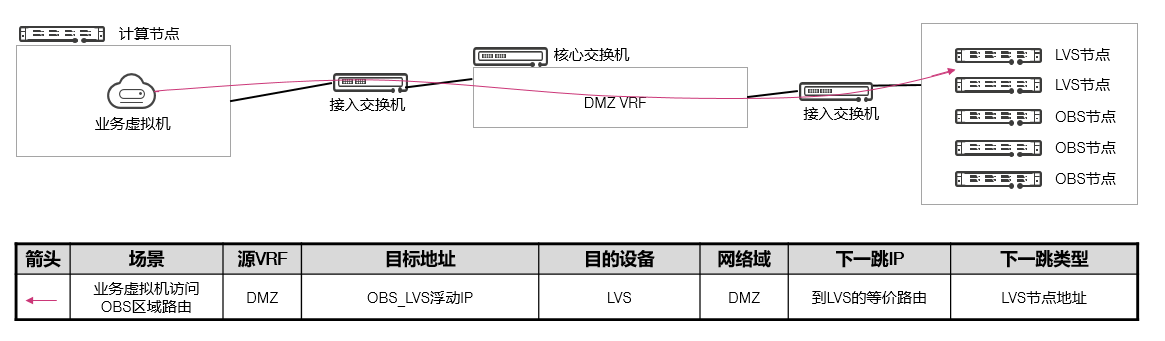

网络节点流量转发:外部访问流量,经过防火墙之后,会被转发到BR进行内部转发(SDN),内部流量根据转发的位置不同,转发到相应的服务,BR(外部访问),ENAT(外部访问、VPC互访、云连接),vRouter(跨网段站点内互访使用)……参考HCS网络流量概述章节

防火墙的静态路由分为了两个部分,对外使用默认路由直接转发到出口PE,对内通过VRF进行转发即可。

核心交换机静态路由设计 - 默认路由

核心交换机静态路由设计 - Internet访问

核心交换机静态路由设计 - 网络节点网元访问(1)

核心交换机静态路由设计 - 网络节点网元访问(2)

核心交换机静态路由设计 - 其他访问

防火墙静态路由设计

部署设计

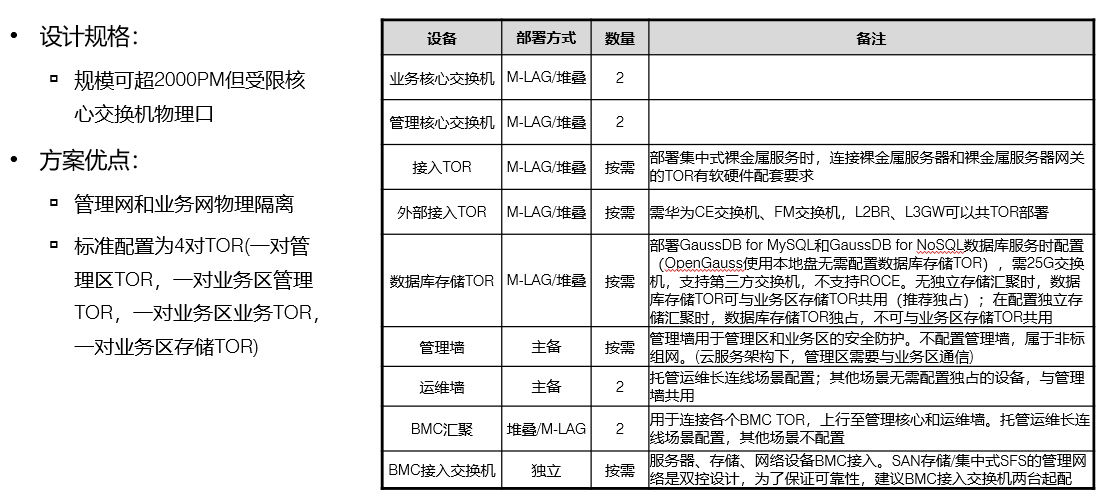

云平台整体部署架构

全局或区域部署原则

组件部署方案

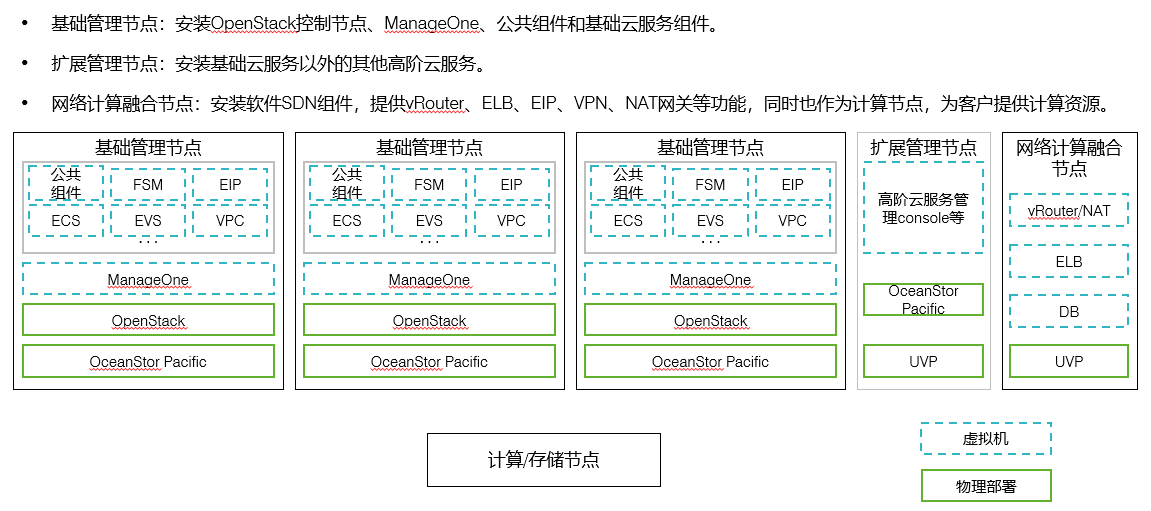

基础控制节点至少3台,网络计算融合节点至少2台,计算节点按需设置,扩展管理节点根据部署的高阶云服务进行扩展。

节点类型及部署详情 - 管理节点

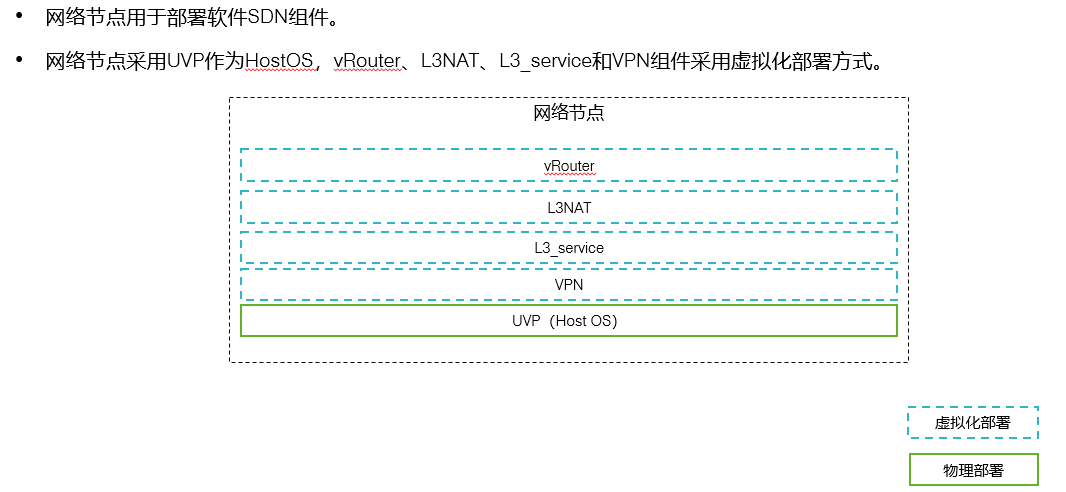

节点类型及部署详情 - 网络节点

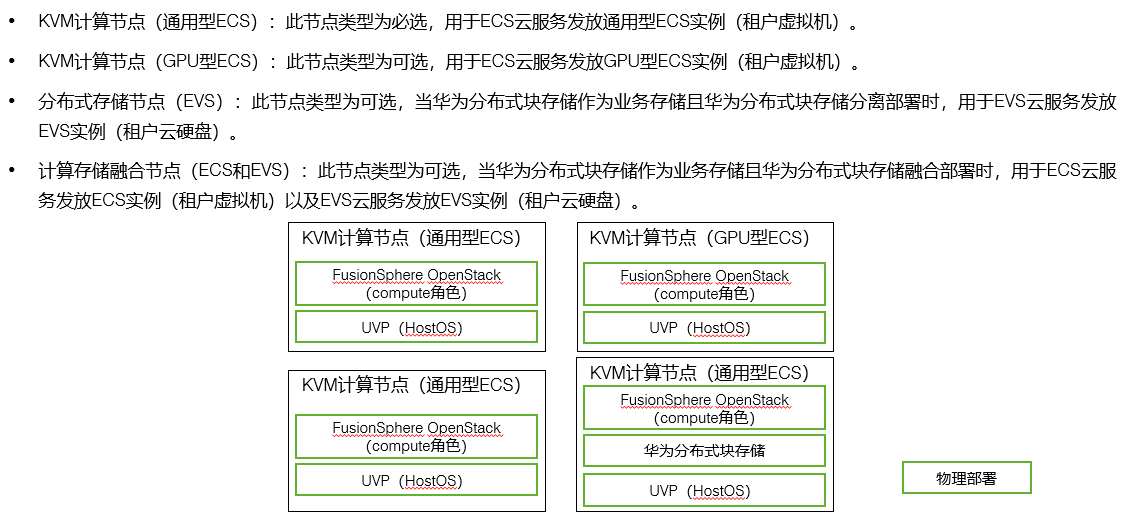

节点类型及部署详情 - ECS和EVS相关节点

通用ECS是必选的,计算节点中的EVS是可选的,但是EVS服务是必选的。计算节点中的EVS是属于扩展资源类,EVS服务是ECS启动的必选项,如果不使用计算节点的存储资源建设EVS,那么就必须通过其他形式实现,如IPSAN、Dorado存储、OceanStor Pacific等

ECS和EVS并没有在基础云服务中直接安装,只是安装了一个可以发放和创建ECS和EVS的管理框架,即FusionSphere OpenStack,实际安装的时候,就是安装这个进程和服务接口。

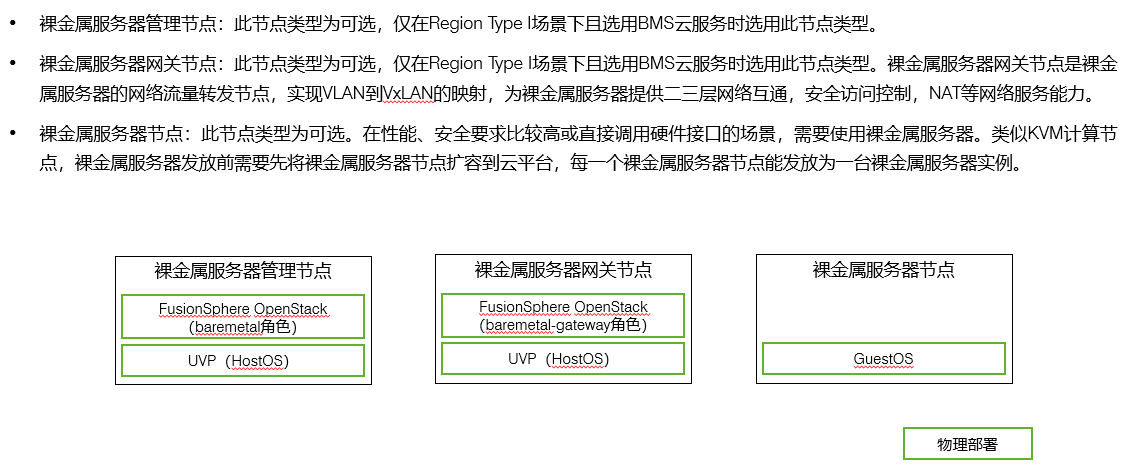

节点类型及部署详情 - BMS相关节点:

可选服务,如果安装BMS,那么FusionSphere OpenStack、和BMGW是必须要安装的。其他的待发放的BMS节点,都没有预制相关的进程,仅当客户下发请求要求拉起BMS的时候FusionSphere OpenStack才会下发请求到BMS节点,加载EVS硬盘拉起系统给用户使用。

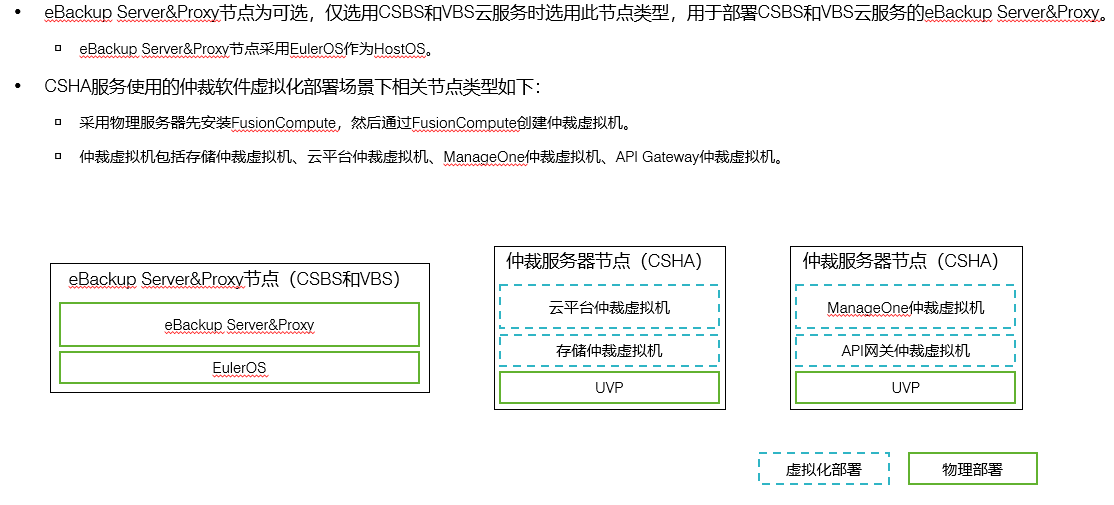

节点类型及部署详情 - CSBS、VBS和CSHA相关节点

ebackup:备份容灾服务,预制安装ebackup服务端、代理。Agent客户端仅当发起备份容灾的业务的时候,才会安装在被备份和容灾的系统上。ebackup本身是一个软件,预制在EulerOS系统中,我们没办法直接装ebackup软件,只能是安装系统,系统自动化会部署好。(ebackup虽然在图中标识必须要物理部署,但是实际上虚拟机部署也可以用)

时钟同步

平台时间同步设计 - 有外部NTP

平台时间同步设计 - 无外部NTP

全局所有的服务器、所有的进程、所有的业务,必须要保证时间差不能超过5min,否则会直接导致业务离线。在实际交付中,必须要配置NTP时钟源,时间可以不正确,但是必须全局一致

如果没有时钟源,建议配置一个时钟服务器,可以以虚拟机的形式进行提供,但是要绝对保证稳定,全局和时钟源进行时间同步

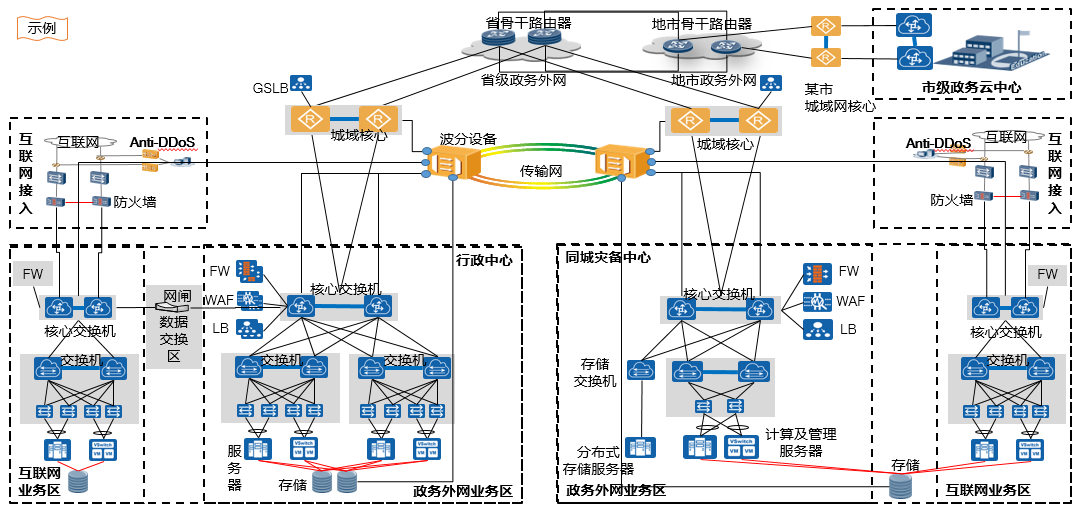

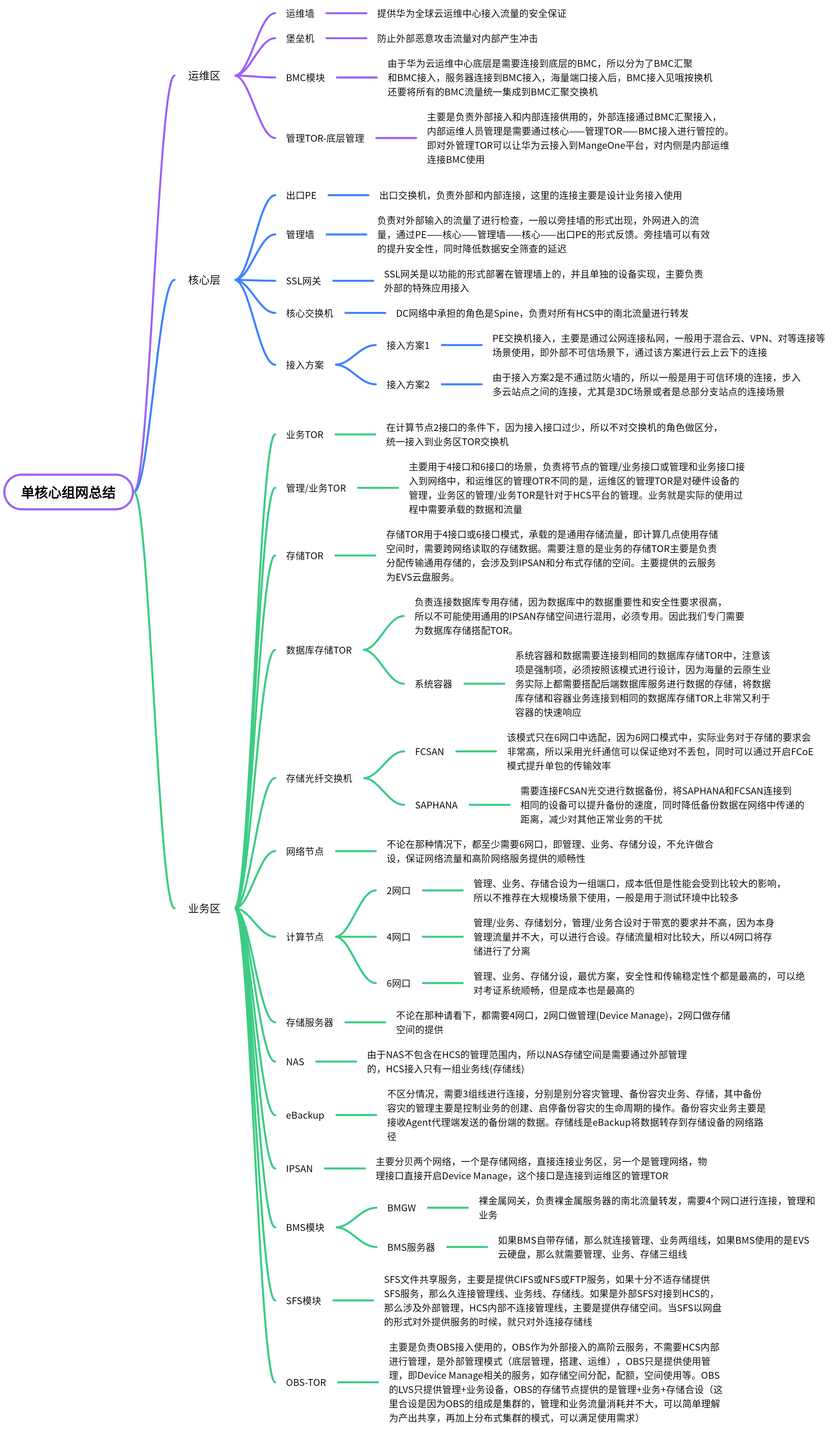

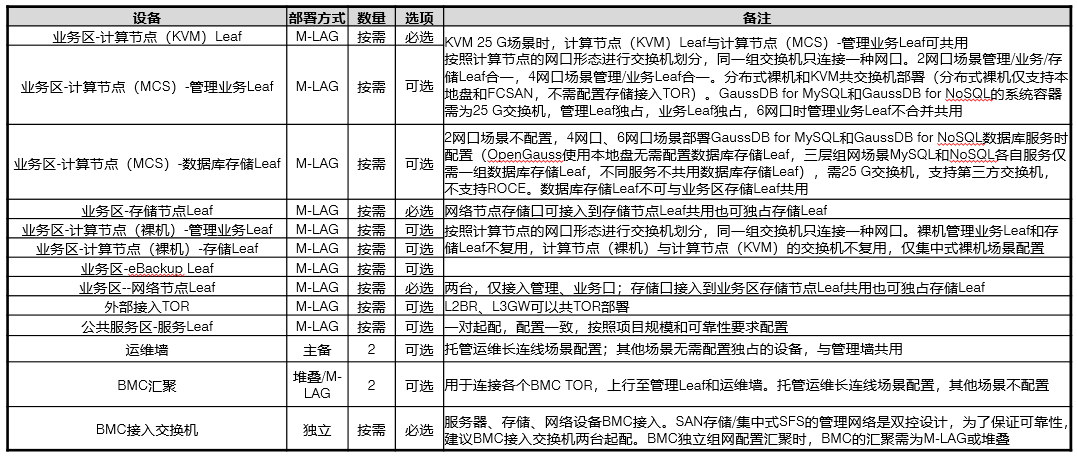

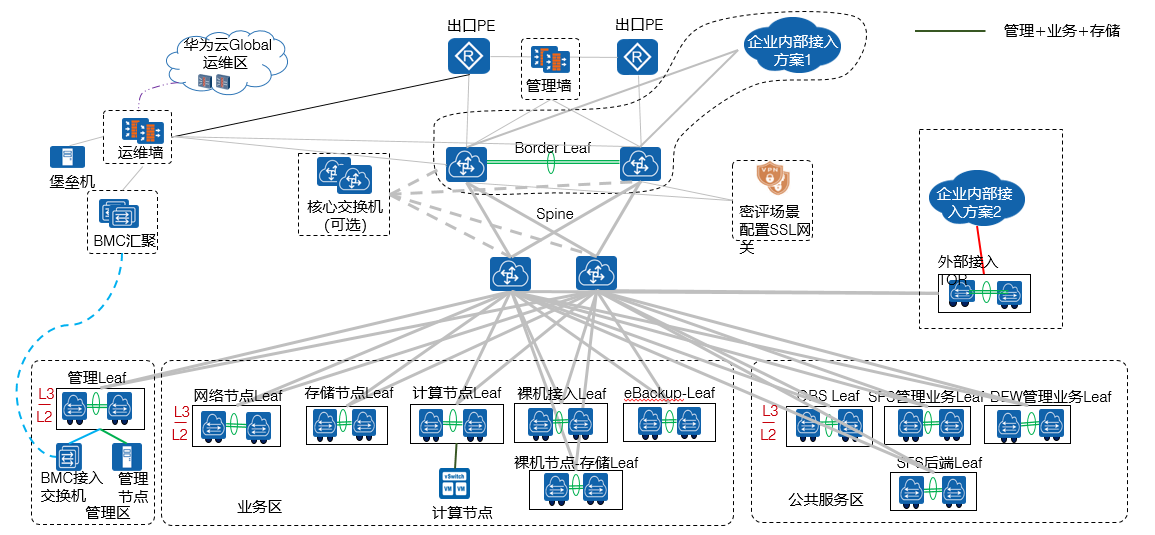

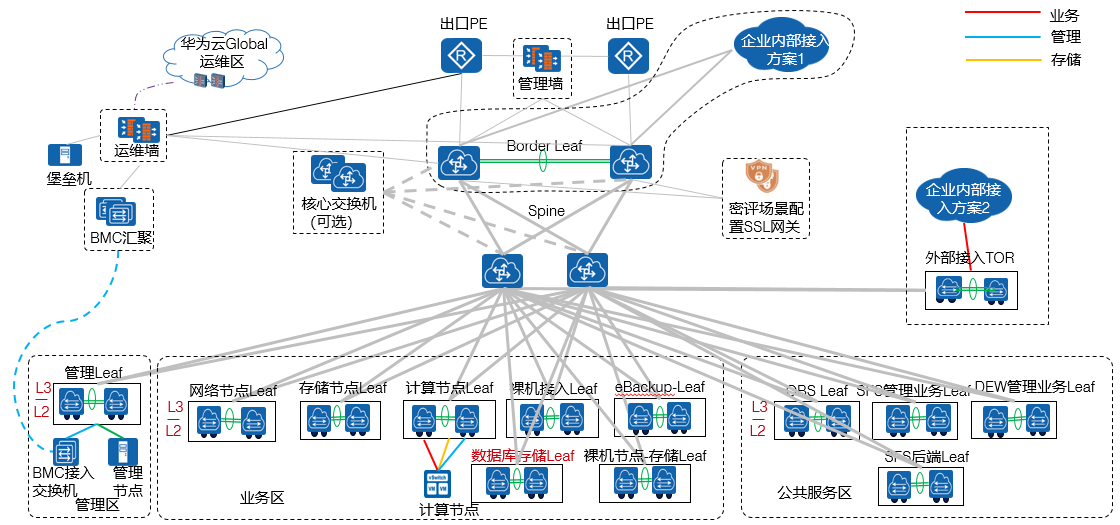

五、华为云Stack标准组网

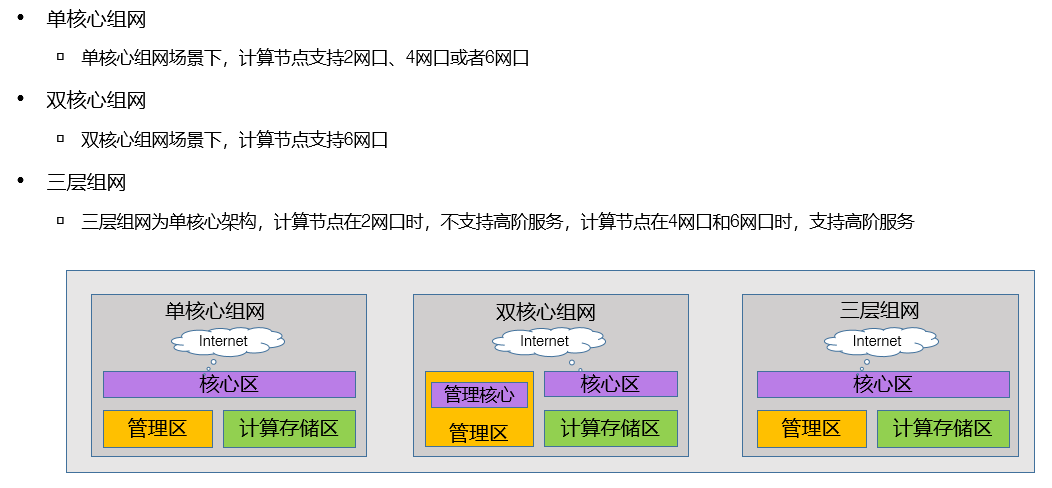

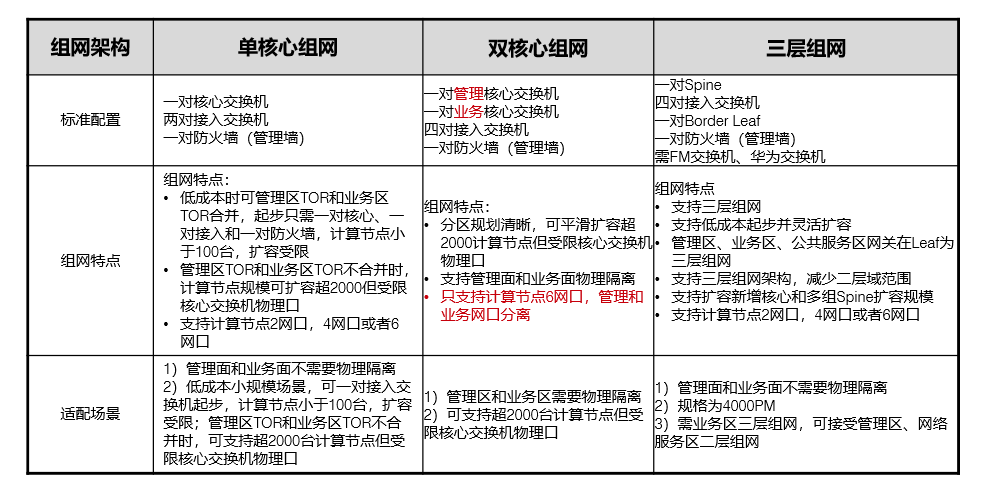

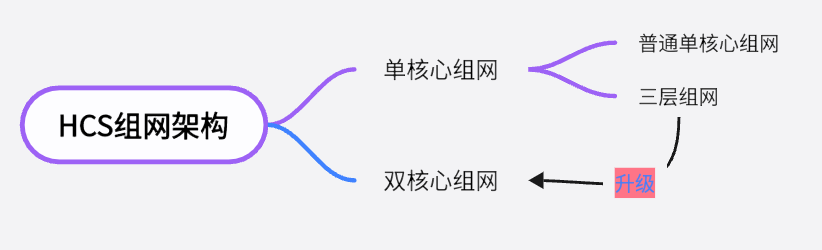

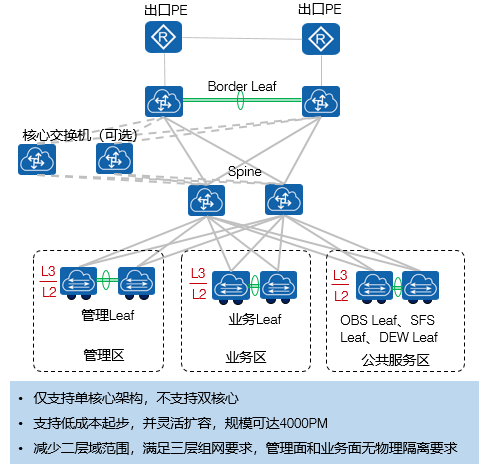

目前华为云Stack的标准组网是分为了单核心、双核心以及三层组网架构三种模式。

HCS标准组网架构

单核心组网指的是Spine层面上只有一个核心(两台交换机做stack堆叠,逻辑上就是1台设备),所有的流量转发都需要通过该核心进行操作。即管理、业务、存储流量的跨网络转发都通过一套核心系统进行传输。

双核心指的是我们将管理和业务流量进行区分,管理核心只负责转发管理流量,注意这里的管理流量指的并不是底层的管理流量,而是OpenStack的管理流量,比如Cascading_External_OM。业务流量就是正常的数据流量和业务流量。

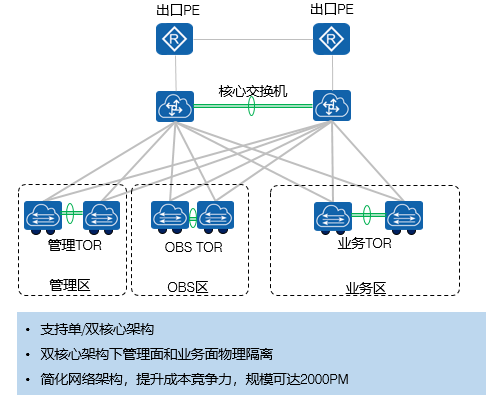

三层组网指的是网络架构采用了三层结构,即相较于二层组网,三层组网使用leaf、spine、border leaf三层网络架构进行流量转发,数据的集成度会更高。需注意的是,三层组网只帮助单核心组网,即spine层只有一套核心,管理+业务+存储由一套核心进行转发。

对于底层的服务器和终端来说,大家接入HCS只能使用2/4/6/8网口,其中2网口(端口绑定)代表管理、业务、存储混用一套端口进行转发。4网口(2套端口绑定)代表管理、业务混用一套端口,存储独享一套端口。6网口(3套端口绑定)代表管理、业务、存储独享一套端口。8端口是比较特殊的,8端口专用于网络节点的连接,4组绑定端口负责接入管理、vRouter、NAT-Lbass、Nginx四种角色的流量

需要注意的是,2端口因为其比较高的集成度,所以不推荐也无法使用高阶云服务。一般建议中小规模的HCS,使用4端口进行转发,大型HCS数据中心,使用6端口进行转发,仅当测试场景以及小规模应用的时候,可以选择2端口进行集成;

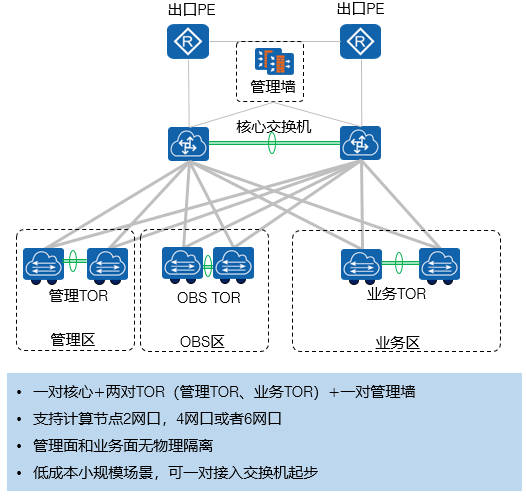

单核心的特点在于其低成本、搭建便捷、安装和部署速度较快,不过单核心流量比较集中,并且安全程度比较低

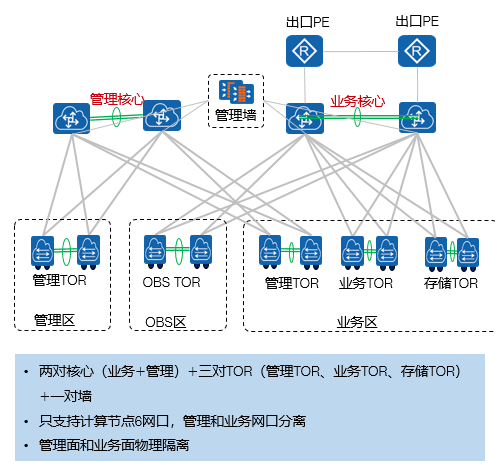

双核心的特点在于将管理区和业务区进行了划分,分区清晰第一利于网络安全性的控制,其次业务流量的转发性会更强,对于大流量的业务支持度会十分好。但是双核心的造价成本会相对比较高,高在两个角度上,第一个是服务器尤其是计算节点,要求必须是6端口,即管理+业务+存储分离,第二个是核心交换机需要比较好的设备,缘于设备数的增加会导致整体数据流量的增加,那么就需能够提供足够包转发率的设备。

三层组网即在二层组网的基础上添加了border leaf层,三层组网必须选择一对spine(三层组网一定是单核心组网),三层组网的优势在于可以减少二层域范围(VXLAN广播域范围),扩展性比较强,可以支持从单核心转为双核心,扩展性和灵活性比较好。支持2/4/6三种端口模式。一般推荐在已有网络架构的前提下,进行HCS部署,先满足使用需求,后期可以利用其比较好的扩展性和变化性,进行扩展或者是升级。

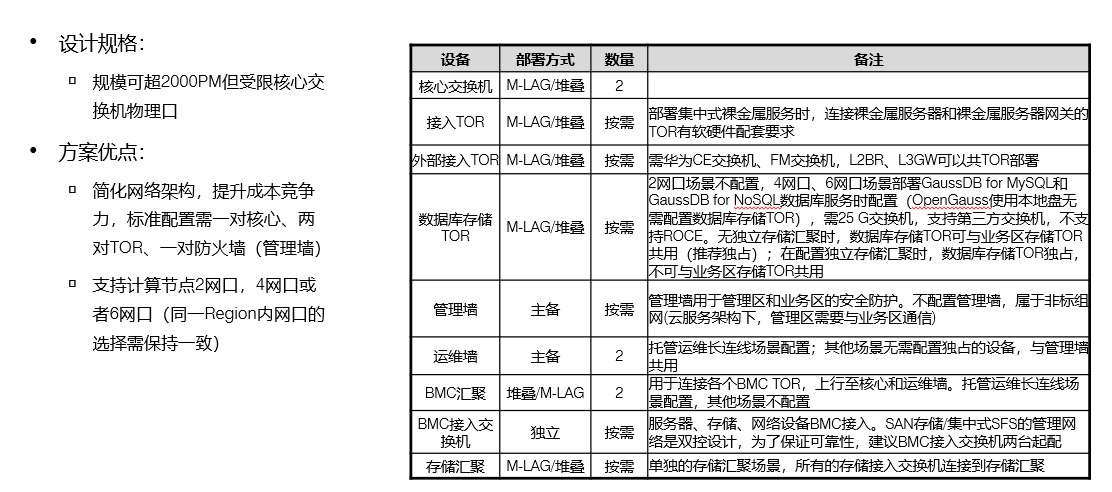

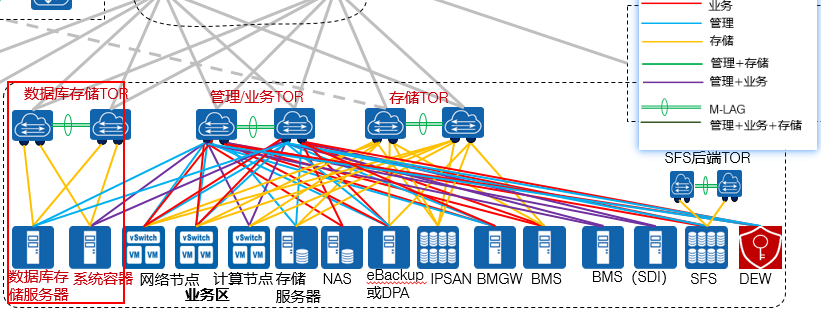

单核心组网

支持2/4/6网口接入,假如单核心选择2网口接入,那么底层接入交换机就能够不区分管理、存储和业务交换机。如果选择4网口接入,那么管理和业务共用一套接入交换机,存储单用一套接入交换机,如果是6网口,那么如图,三种流量独享交换机。

从这个模式中其实也就可以看出核心的多少实际上和底层服务器的接口数量实际上是没有联系的,服务器到底要多少接口,主要决定于接入交换机分为几种角色。单核心双核心决定的是接入交换机的流量要怎么样进行汇聚和转发。

管理TOR主要是负责转发OpenStack的管理流量的,管理墙是负责运维管理人员接入的,两种管理的含义是不同的,要求注意区分。

如果没有接入交换机是否可以?

可以,但是这会在极大程度上消耗核心的资源,并且在DC中实际上所有接口都接入核心是违规行为,连线跨柜对于后期的维护来说是具有极高难度的,于是不推荐。另外连线直接上核心也是一个错误的做法,因为在DC中尤其是在HCS中实际上很多流量是东西向流量,并不是南北向流量。所谓东西向流量简单来说就是在DC内部进行互相转发的流量,并不会经过spine的转发,而是在leaf层之间进行互转,南北向流量就需要通过leaf——spine——出口的转发路径对外进行内容转发。如果所有设备都接入到核心,那么核心就承担了整个HCS的所有东西向和南北向流量,这就会导致核心的包转发率异常的高,甚至在业务高峰期会超出核心的转发能力,而本身在大量的数据转发中,东西向流量是占据了大部分的,所以我们不推荐也不能将所有的连线都直接接入到核心。

双核心组网

双核心组网核心优势在于分割了管理和业务,底层服务器具体使用2/4/6端口实际上还是和核心数量无关的,看的是接入交换机的类别划分。不论底层怎么进行接入,实际上来说核心层都是只划分管理和业务的。在图中,管理区管理TOR指的是OpenStack的管理流量,OBS区指的是存储(OceanStor Patific或者是OBS存储或者是物理存储)业务的接入,提供存储空间,业务区的管理TOR指的是Openstack的被管理流量,也就是规划中的Cascaded流量,业务TOR就是转发实际的业务流量的,存储TOR是服务器使用存储空间的接入。

二层组网

三层组网

相较于二层组网,三层组网是有三层网络架构的,在DC中就涉及到了leaf——spine——border leaf。在三层网络中,底层的接入vxlan是通过接入交换机的二层网络配置搭建的,但是leaf到spine和border leaf之间就是利用三层网络架构达成的。也就是说二层网络中,接入交换机一般会承担NVE的功能,然而VXLAN的三层转发VBDIF是由Spine核心节点构建的。而在三层网络中,由于二层网络架构和三层网络架构都是在leaf层实现的,所以NVE和VBDIF都是在leaf接入交换机实现的。即我们将二层网络和三层网络在leaf层面上做了隔离,这种结构就适合于原本DC就已经部署了三层网络架构,但是我们又需要HCS二层网络通信,这个时候就可以在原本的三层架构上,部署二层通信。

六、组网设计需求

单核心组网设计和配置

核心交换机必须是2台,不然不构成单核心的需求,2台做堆叠

接入TOR根据服务器的数量决定,至少是1组

外部接入TOR需要使用CE系列交换机或FM交换机,一般建议建立华为CE6800系列

数据库存储TOR,如果有部署云数据库业务则需要进行选择,数量按需部署

管理墙,首要负责外部接入管理的安全,可以不配置,但是属于非标准化,至少需要1台,标配2台主备

负责给长线运维的(华为远程接入运维服务,需要单独购买)就是运维墙,在特殊场景下专门给运维接入使用的防火墙,保障安全使用,主要

BMC-TOR,分为了两个部分,一个是服务器BMC接口的接入,受限于BMC接口数量比较多,因而一般还必须设置BMC的汇聚

分布式存储的接入,提供存储空间,如果设备数量比较多,也要求存储汇聚交换机。就是存储TOR,负责存储设备或者

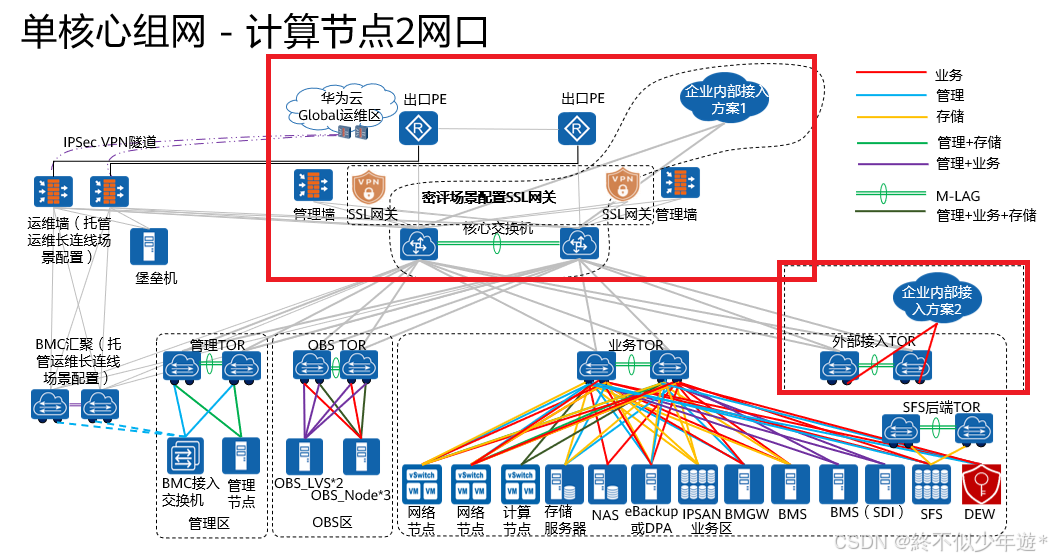

单核心组网 - 计算节点2网口

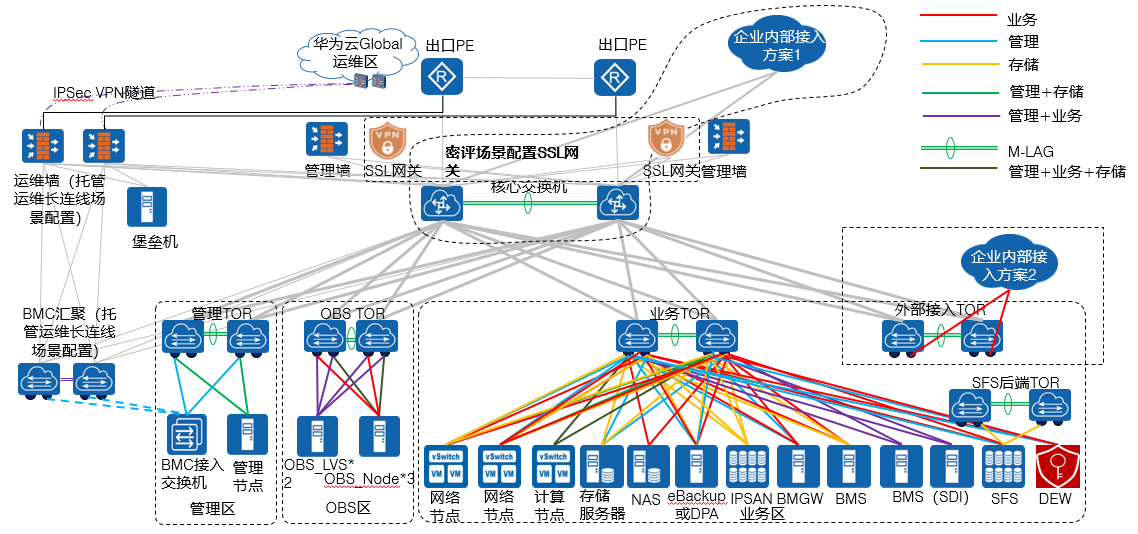

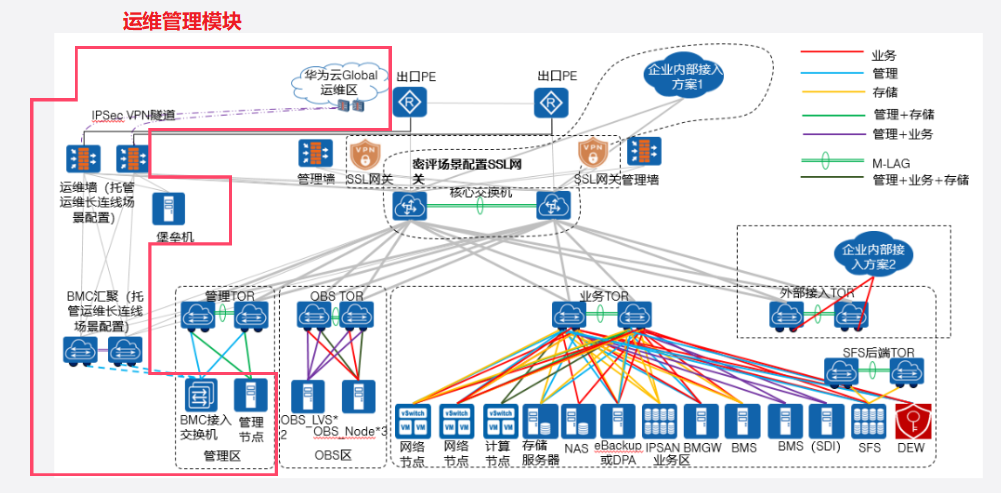

运维管理模块

华为云全球运维中心,通过IPSec VPN接入到私有云,进行运维使用,流量通过华为云运维中心发起,转发到运维墙,运维墙选配堡垒机,保护内网安全,流量会被转发到BMC汇聚交换机,然后转发到具体的BMC的接入交换机,最终到达实际的服务器底层,进行运维维护。

需注意的是,BMC的汇聚还要连接到核心交换机,用于内网运维运用。BMC的汇聚交换机还要接入管理区TOR,用于HCS平台管理使用。所以综合总结

华为云——运维墙——BMC汇聚——BMC接入:远程运维

BMC接入——BMC汇聚——核心:内网运维(底层)

BMC接入——管理TOR——核心:HCSD安装部署维护使用

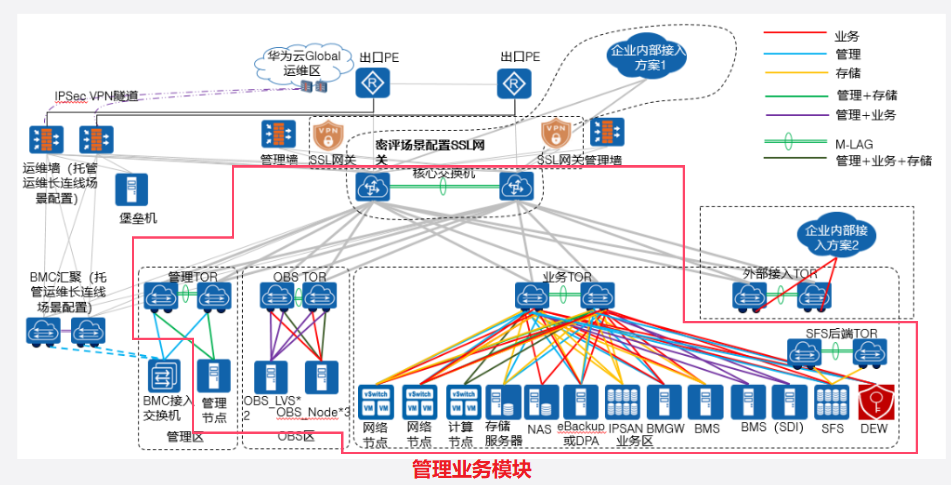

管理业务模块

管理业务模块流量转发为:

管理节点——管理区TOR——核心——业务TOR——业务节点

流量从管理节点出发,发送的是Cascading,OpenStack管理区流量,流量借助以上路径到达业务节点之后,业务节点反馈Cascaded流量,进行HCS管理流量的拉通。

网络节点接入方案1:

管理+存储、业务、存储

其中网络节点管理+存储合设,因为网络节点对于存储空间的启用是比较少的,占用的存储空间并不多,所以和管理流量合设,业务流量(网络转发流量)是单独启用端口的。存储流量并不是管理+存储流量,网络节点的管理+存储流量是网络节点自己运用的存储流量,而单独的存储流量是转发的存储流量,也就是对外供应存储服务的流量,比如SDRS的流量。

网络节点接入方案2:

管理、业务、存储

这种方案的构建相比于方案1的区别在于网络节点实际上并没有使用外部存储空间,这就要求网络节点服务器采用自身的存储空间,业务流量和存储流量没有变化。

计算节点:计算节点2网口,要求管理+业务+存储合一,但是需要注意这种模式对于网络接口的流量压力是非常大的,因此一般来说计算节点2网口模式只适用于2种场景,第一种就是网络流量压力不大的测试场景。第二种就是客户预算不足的情况,这种情况下为了保证正常使用,大家推荐计算节点的网口至少要配置25GE网口

存储服务器

(1)传统存储:管理、存储,管理负责接入MangeOne,存储负责提供空间,尤其是EVS云硬盘服务

(2)NAS存储:NAS存储是外部存储,HCS没有管理权限,所以接入HCS的NAS只需要连接存储线即可

(3)eBackup:华为备份容灾节点,一般来说eBackup是以虚拟机的形式部署在HCSD上的,但是如果是物理机部署,就会涉及管理、业务、存储三方接入,管理负责对备份容灾进行业务管控,业务负责接收备端Agent的流量,存储负责将要备份的介质的信息转发到存储空间

(4)IPSAN业务:三方扩展存储使用,只提供存储空间,管理由外部进行管理

BMGW:裸金属网关,负责裸金属服务器的流量转发使用,管理、业务(BMS流量转发使用)

BMS:裸金属服务器

接入模式1:

通过依赖外部管理的,BMS以资源的形式添加进HCS就是如果BMS接口数量比较多,能够选择存储、业务分设,这种情况下管理

接入模式2(常用):

管理+业务合设模式,存储要求BMS自己献出或者是使用SAN存储的空间。

通过SFS:文件共享服务,管理、业务,业务指的就是存储空间的供应,SFS能够单独对外提供服务(网盘),那么SFS单独对外的时候,不能通过业务TOR和核心交换机路径转发,需要单独的SFS进行提供,另外SFS后端还需要专门的TOR进行维护

DEW数据加密服务:管理、业务

OBS模块

OBS根据版本实际上链接方式是有区别的,目前常用的是OBSv3,OBSv3由LVS和Node两个部分组成,其中LVS负责整体业务层面的负载均衡,Node负责的是实际的空间供应和数据存储。

OBS_LVS,OBS负载均衡2节点,主备,管理+业务合设,缘于整体流量不高,基本以请求为主,不涉及数据传输

OBS Node负责实际数据存储,于是分为了业务、管理+存储+业务,实际上Node分为了两种模式,一种是合设法,管理、业务、存储共用一套端口,另一种是业务提供,即提供存储空间对外。

Spine区域

管理墙负责对整体管理流量进行安全性检测,同时SSL网关也是在管理墙上,负责外部远程接入。正常情况下,外部和内部的连接都需遵循外部——出口PE——核心——管理墙——核心——业务TOR。

非正常情况下(站点连接,即区分总部站点和分支站点)企业多站点互联可以使用外部接入TOR直接连接核心到业务TOR。源于非正常情况下,业务流量不过管理墙,因此一般适用于有互信的情况下,比如3DC,总部-分支站点连接的情况。

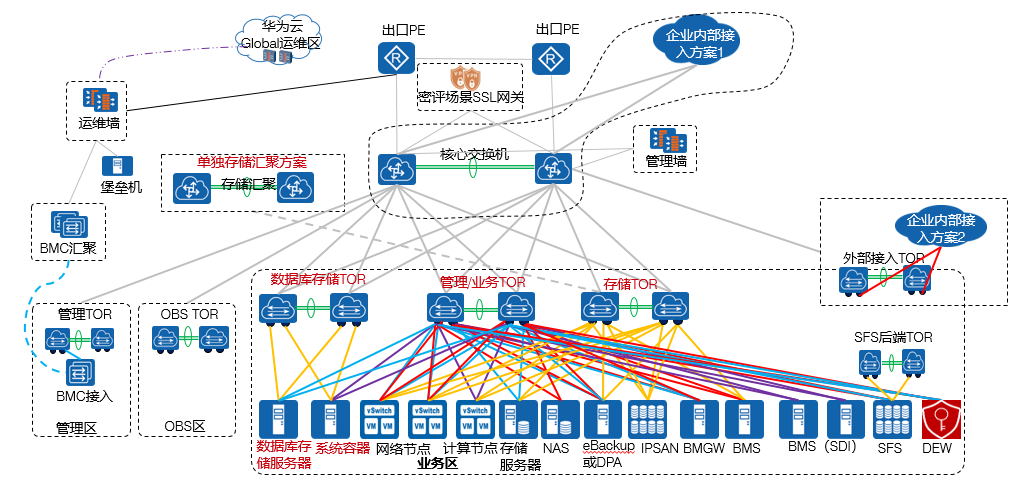

单核心计算节点4网口

运维区、接入区和2网口模式相同,不再赘述

单核心情况下,不论是多少接口,变化的只有业务区,其他区域不会有任何区别。

相较于2接口而言,4接口会将存储流量进行单列,因为在实际的HCS业务中,管理和业务流量本质上都不是特别高,流量主要是以存储流量为主。所以4接口模式下,一般都会分配一组端口专门用于跑存储流量应用,所以也会有专门的存储TOR交换机。

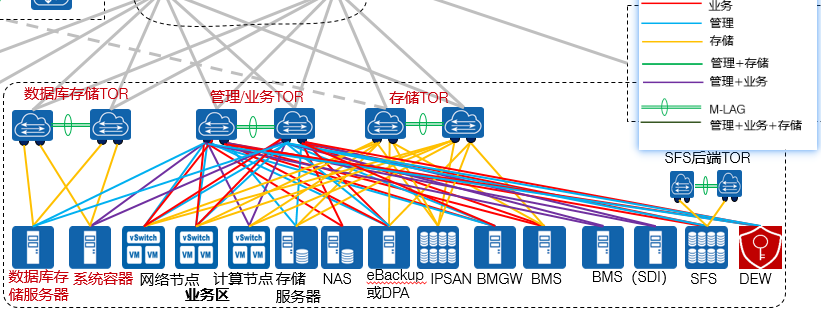

数据库存储模块

数据库存储模块主要是包含两个内容,一个是数据库存储服务器,本质上是华为分布式存储,也可以使用IPSAN存储,但是一定要保证单列存储,不共用。为了保证数据安全。

数据库存储需要连接管理接口到管理区TOR,存储接口连接专门的数据库存储TOR,其和业务区的存储TOR是隔离的,用户在使用数据库(特指GaussDB系列服务)的时候,是通过专门的数据库存储TOR连接数据库存储的。

流量路径为:

用户——出口PE——核心交换机——业务TOR——计算节点—(前端与后端的区分点)—数据库服务器——存储TOR——数据库存储TOR——数据库存储服务器

系统容器层

容器服务是一个单列服务,不依赖于ECS计算节点和BMS计算节点,HCS部署容器服务是需要分配单独的物理服务器的,用于构建CCE云容器服务以及相关的配套服务,比如SWR……。容器和数据库存储服务器是布置在一起的,两者共用数据库存储TOR。因为云原生微服务框架下,容器的部署和业务的提供需要大量使用数据库服务提供数据记录支持,故而将两个业务放在一起,可以有用的减小业务访问延迟。

容器业务分为管理+业务、存储,管理业务还是接入到业务区TOR,存储就依赖数据库存储TOR连接

网络节点不受到计算节点接口数的影响的,网络节点在4接口模式下根据实际情况进行设计,图中目前是管理、业务、存储分设

计算节点在4接口模式下,会将流量比较高的存储单列,分为管理业务、存储进行设计

存储服务器就分为了管理、存储,存储服务器的业务就是存储所以存储服务器本身就只需要最多4接口即可

NAS和2接口相同,只提供业务,管理通过外部实现

ebackup同2接口模式,接口数量不受限,至少要求6接口(ebackup在实际交付阶段,使用2接口甚至是1接口也能使用,但是非常不建议,因为流量太大,会导致进程严重卡死)

其余所有进程都和2接口模式相同,不在赘述

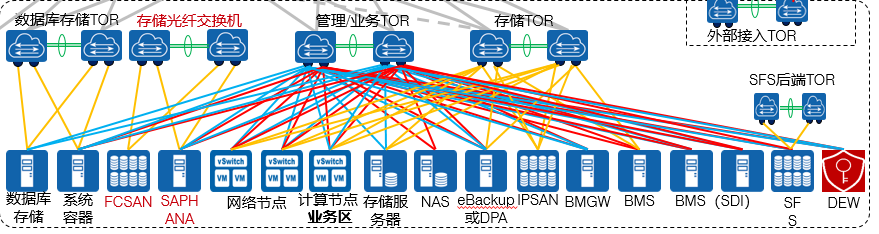

单核心计算节点6网口

在6网口情况下,本质上大部分的内容和2网口4网口没有很多的区别,因为单核心其实就已经决定了网口的功能分布,只是计算节点根据业务量的大小和存储数据量的大小进行划分。在这个前提下,6网口一般是适用于业务量比较高的场景,这种场景对于存储的需求同样也是比较高的,所以我们需要通过海量存储设备实现对于业务的底层支撑,这种情况下就需要通过存储汇聚方案进行实现,需要注意的是,存储汇聚方案是可选的,并非必选,我们可以按照2网口或者4网口的模式进行业务提供,存储汇聚更多情况下是为了面对海量数据的集中管理所设置的

在6网口模式中,首先数据库存储区没有发生比较大的变化,和4网口模式是相同的。相较于前面两种情况,6网口新增了存储光交,即我们进行通信的时候,后台存储SAN网络需要通过光纤交换机进行业务提供,而并非传统的数据中心交换机或者是CE系列交换机。为什么只有存储设备才需要光交呢?光通信的优势在于2个点,第一个是存储光网络可以保证在数据传输的过程中,绝对不丢包。对于海量数据传输的大规模场景是非常适用的;第二个是存储使用光网络可以单次传输大包,更适合我们进行海量数据的一次性传输(传统以太网络单个包的大小是1506bit,选择使用FC-SAN之后,可以通过开启FCoE,将单包大小拉到9000bit,所以在大规模场景下,选择FCSAN搭配FCoE是更合适的)

存储业务FCSAN网络对外提供的是基于光的网络传输,SAPHANA是基于存储的备份管理软件,安装在单独的服务器上,所以SAPHANA需要连接存储、业务和管理网络。

网络节点部署同2网口和4网口

计算节点在6网口情况下,需要管理、业务、存储分布,这种模式对于业务的整体使用是安全且高性能的,但是同时成本就会达到最高、

其他所有相关节点的连接都没有发生变化,同2网口和4网口

单核心组网总结

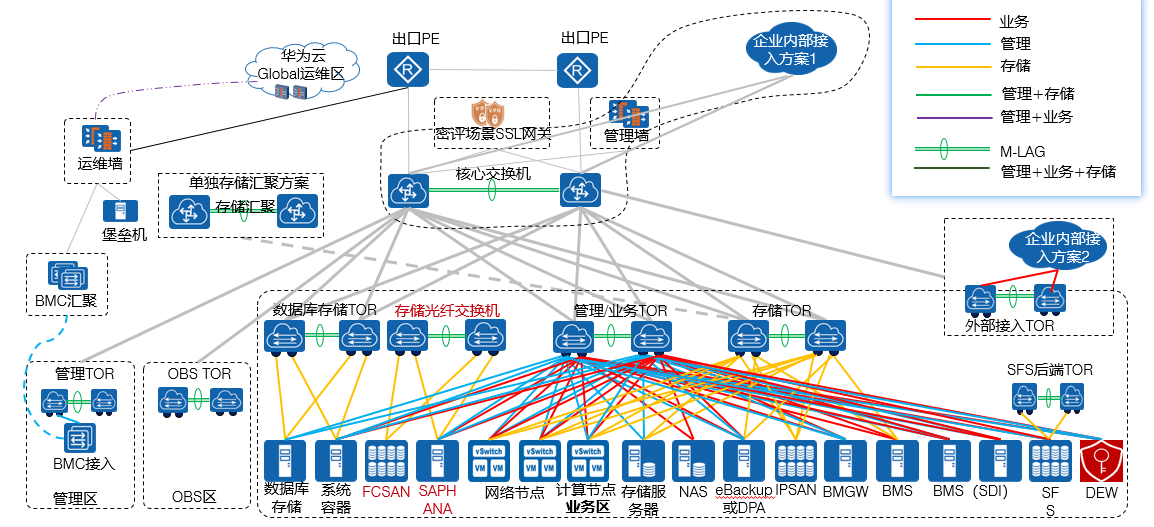

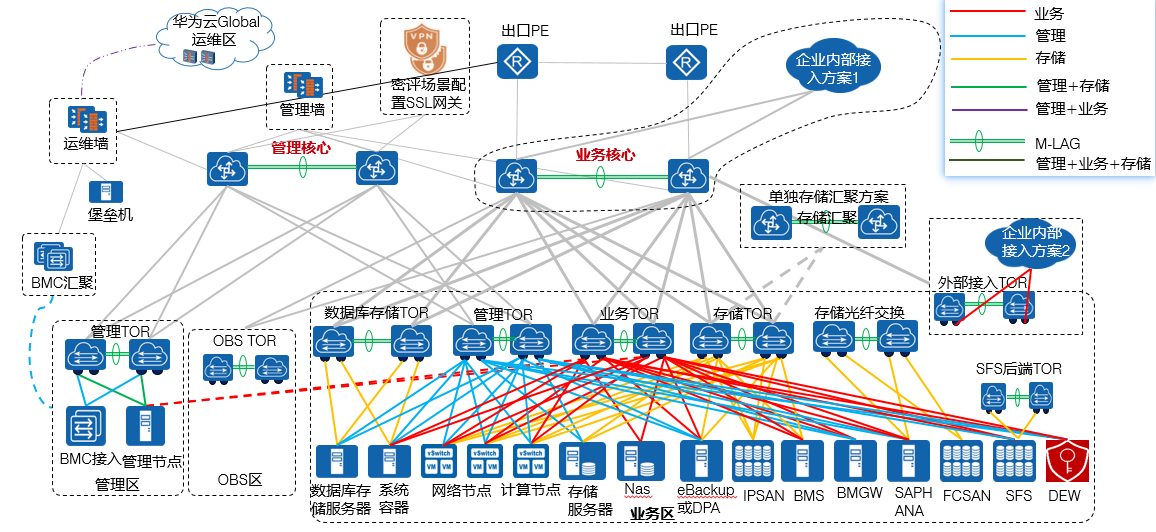

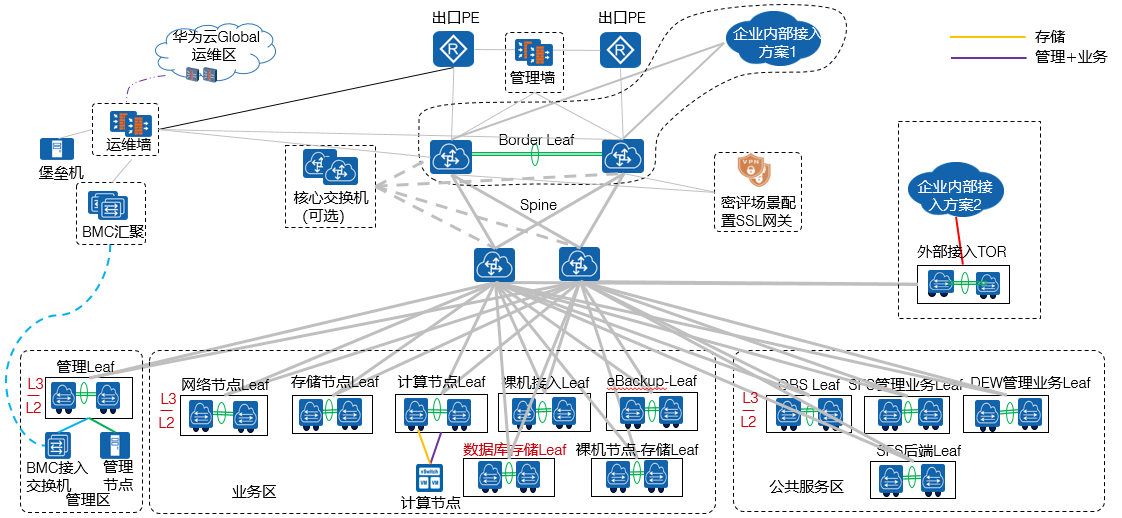

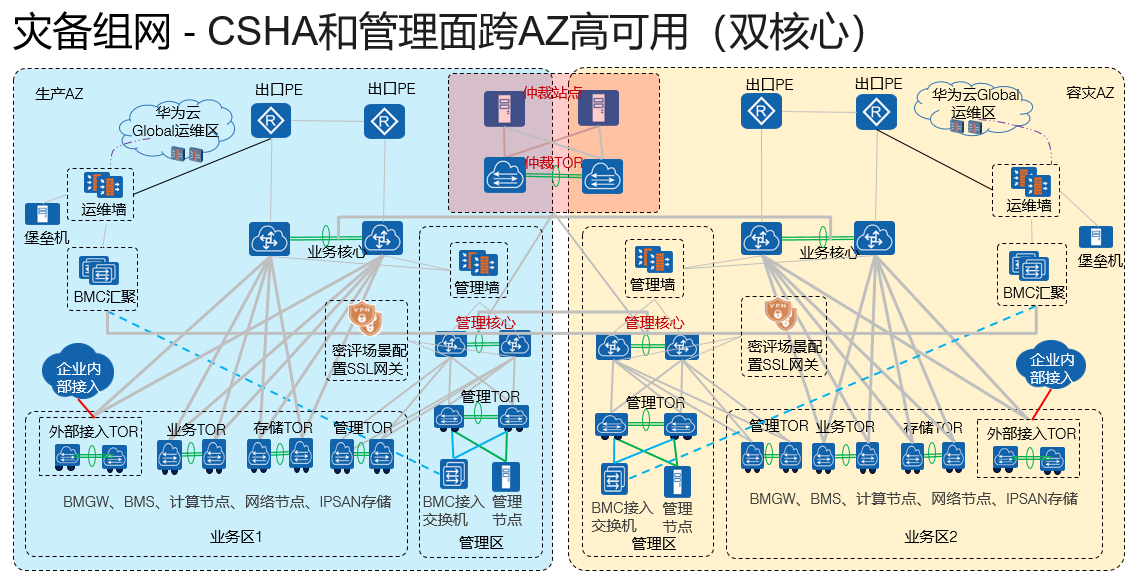

双核心组网架构

单核心和双核心的区别就在于核心层面即Spine层面上要求几组核心交换进行连接,如果用户的业务量比较大,我们是推荐采用双核心组网,将管理和业务进行分离。

和单核心不同的是,双核心组网没有2网口和4网口模式,起步就是6网口模式,因为双核心本身业务量就是比较大的,在核心已经区分了管理和业务的前提下,就不能考虑底层做低配。必须要按照顶配思路进行设计,于是双核心就是目前HCS的最高调整方案。

双核心组网 - 计算节点6网口

运维区相较于单核心,本身没有发生变化,还是遵循华为云全球运维中心-运维墙-堡垒机-BMC汇聚-BMC接入的转发流程,然而区别在于双核心场景下,出口PE会连接一条线到运维墙(该线按需配置)。

管理区新增管理核心之后,所有负责管理相关的设备和流量都要转发到管理核心,尤其是管理墙进行安全保证的,所有的管理区TOR,不论底层还是HCS的管理TOR都需要接入管理核心,管理流量在双核心场景下,正式完全独立。包括外部SSL接入也是通过管理墙接入到管理网络中。

业务区所有的流量都要接入到业务核心,业务核心下辖数据库存储TOR、业务TOR、存储TOR、存储光交网络

相较于单核心网络,双核心网络的业务区整体功能设计非常简单,因为交换机已经全部按功能独立开了,所以交换机TOR至少有三个类型,分别是管理TOR,业务TOR,存储TOR。底层服务器计算节点6接口,6接口就分为三组,接入到三组TOR中。其他的所有设备的连接,均遵循单核心原则

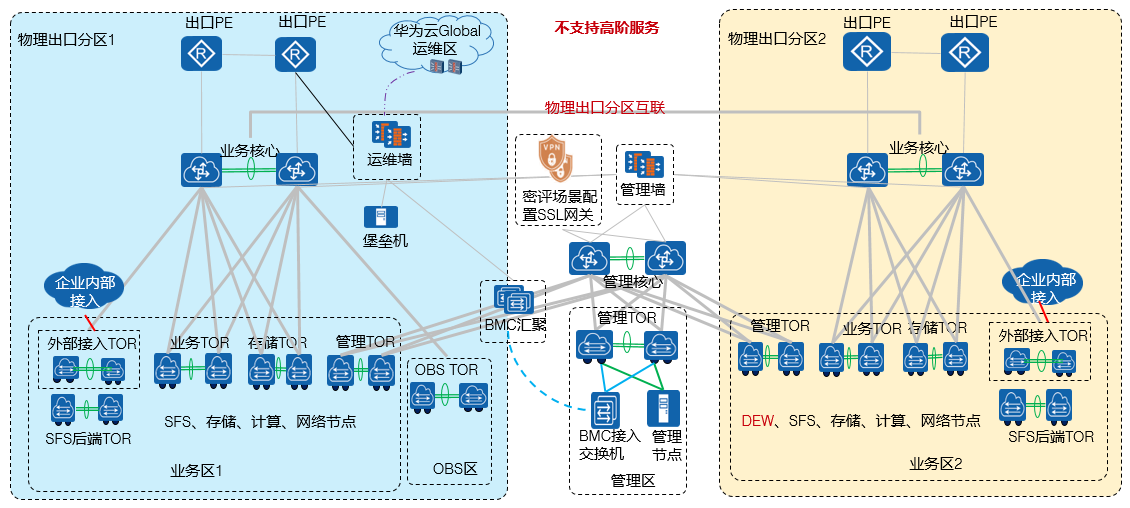

双核心组网 - 6网口多物理出口分区

单核心组网中,多region是以每个region各自拥有管理业务核心进行对接的方式链接的。但是在多核心中,因为管理业务核心分布,所以双核心场景中,每个region只有业务核心,管理核心统一,便于一套管理核心对多个region进行统一管理。针对于该情况,我们有两种部署方案,第一种就是将管理区放在主站点上,第二种就是使用3DC模式,将管理区独立站点部署。对于大规模部署的场景,我们一般是建议选择后者,即独立部署管理区,这样做更有利于安全性保证。最终构建两个生产站点+1个管理站点的模式。

多region模式下,要是两个站点都是独立站点,那么就每个站点各有管理核心和业务核心,管理核心之间互联,业务核心之间互联、保证管理和业务核心网络之间的连接

双核心架构 多Region组网

•多Region组网说明:

1)两个Region分别都是双核心组网。

2)首Region和其他Region的管理核心交换机之间需要三层可达。因为ManageOne和Console部署在Global区,需要同时管理两个Region,两个Region的管理面需要打通。Region区的管理网络(External_OM、DMZ_Service,OBS_OM)需要与Global区的External_OM、DMZ_service和OBS_OM平面互通。支持云连接服务(可选)时,Region区的vRouter集群VTEP IP(Loopback地址)需要与Global区的vRouter集群VTEP IP(Loopback地址)互通。

Globla Public与Region Public,Global DMZ与Region DMZ默认不需要过防火墙配置安全策略。Global Public/DMZ与Region Public/DMZ互访,Global与Region存在跨安全区的访问,通过Global的防火墙上实现跨域访问,只需要在Global所在管理墙配置安全策略。

3)如果双Region的方案叠加管理面跨Region容灾或CSDR,则主备Region需部署ManageOne主备容灾;CSDR要求生产和容灾Region的存储复制面需要打通,因此业务核心之间需要连线。

4)两个业务核心之间是否需要其他业务流量互通(除了CSDR场景下的存储复制互通),比如EIP,IPSec-VPN或者路由直通等互通,按照具体项目要求实现。

5)CSDR场景,存储复制网络的网关配置在业务核心的InterConnection VRF,两个Region的存储复制流量互通不需要过防火墙。两个Region的InterConnetion VRF的网络互通不需要过防火墙。存储节点存储复制口仅在CSDR场景需要。

三层组网

三层组网必须是单核心模式

三层组网分为了leaf接入节点,spine转发节点以及border leaf节点。该方案的优势在于减小了二层域,可能高效隔离广播流量,提升系统效率。另外整体成本比较低,能够进行灵活扩展。第三就是三层组网可以在现有DC网络上做最小化改造即可进行部署,对现有业务的影响比较小。终于三层组网对管理平面和业务平面没有隔离需求。所以部署难度也非常低。

由于三层组网是单核心,于是仍然存在2网口、4网口、6网口的组网模式。我们在进行划分的时候,需要注意底层要根据需求分配足够的leaf节点,满足网络接入的需求

三层组网-计算节点2网口

在2网口模式下,运维区、出口PE、管理墙和单核心网络没有区别。服务器设备根据功能的不同,需要连接到不同的设备,不能做混接。所以网络节点,需要连接网络节点leaf,存储设备连接存储节点leaf,计算节点连接计算节点leaf。即每种不同的功能要求分配单独的leaf交换机进行连接。全部隔离。

三层组网 - 计算节点4网口

4网口模式下,除了计算节点根据区别,划分为存储、管理/业务网络之外,其他所有模式都和2网口没有任何区别

三层组网-计算节点6网口

6网口模式下,除了计算节点根据区别,划分为存储、管理、业务网络之外,其他所有模式都和2网口没有任何区别

七、其它组网

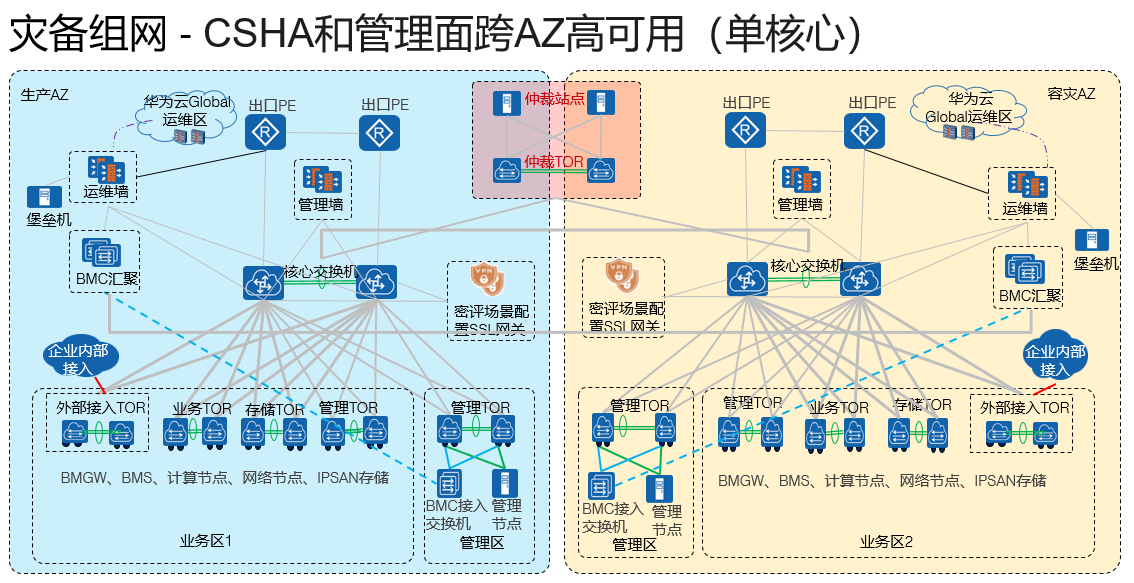

灾备组网

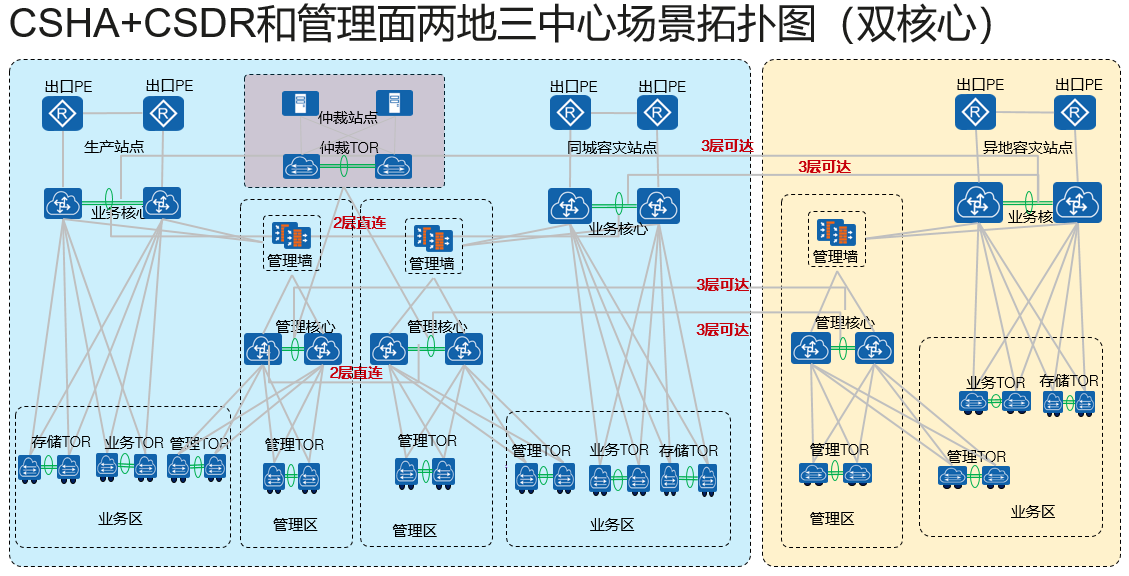

高可用性组网,单核心场景下,直接在两个站点中设置一个第三方仲裁站点,两个站点同时连接到仲裁,并且连接到对方。一旦出现问题,则由仲裁站点进行判断,进行业务切换

双核心场景下,仲裁站点通过接收两个站点的管理网络发送的心跳信息,进行业务在线判断,一旦其中某一站点出现问题,那么仲裁会发送消息到另一端的管理网络,要求该端拉起业务,保证业务连续性,同时仲裁站点还会记录故障时间,和当前情况,便于后续生产站点恢复之后,进行业务的还原。

两地三中心场景下,仲裁负责的是本地生产和本地灾备站点的主备切换,CSDR服务中包含的容灾,则是通过业务核心进行数据的远程复制,从生产站点或者是灾备站点复制到异地灾备站点。

双核心场景下,两地三中心需仲裁站点连接本地生产和本地灾备,同单独CSHA场景。但是包含了CSDR容灾之后,就需要异地灾备站点的管理核心和业务核心同时连接本地生产和本地灾备的管理核心和业务核心。不论客户最终使用串联3DC还是并联3DC模式,线都是要连接好的。因为这种大规模的DC建设必须要做好客户需求变更的设计冗余,不要在初始化设置的时候就只做满足用户基本需求的设计,而是需要做好冗余设计,便于后期用户修改需求。

云联邦

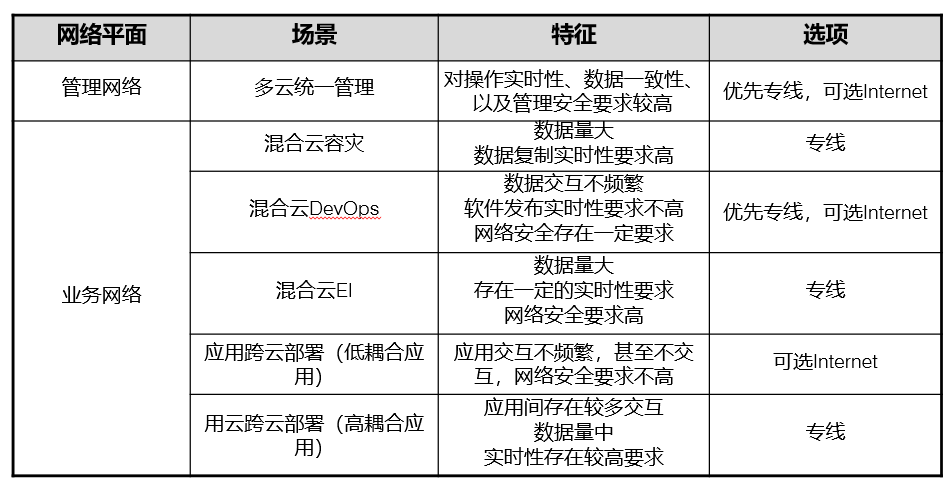

云联邦主要是针对于云间网络进行的设计,云间网络包含管理网和业务网两个模块。

管理平面主要承载云间管理数据,包括认证鉴权、业务管理、运维管理等

业务平面主要承载业务交互数据,例如灾备场景的数据同步、业务软件间的接口调用等

云联邦网络设计基准:

用户对网络性能需求高,那么就使用专线,如果用户穷,就用普通网络

网络安全需求高,则专线+VPN,其他情况选择普网+VPN

网络质量要求高,则根据需求选择,如果客户只是需要高带宽,普网和专线区别不大。如果对可靠性和延迟要求极高,那么一定专线。

预算

云联邦云间网络选项建议

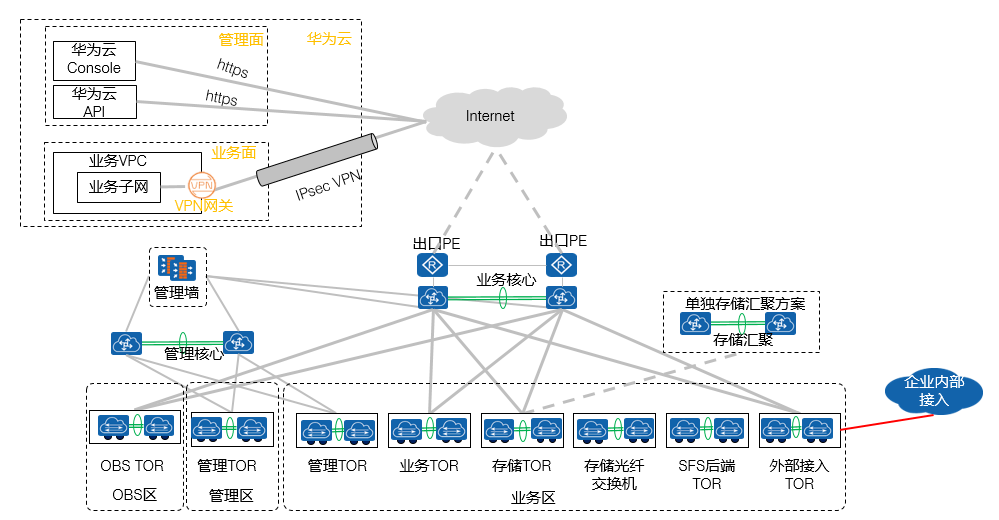

云联邦标准组网 - 仅Internet连接

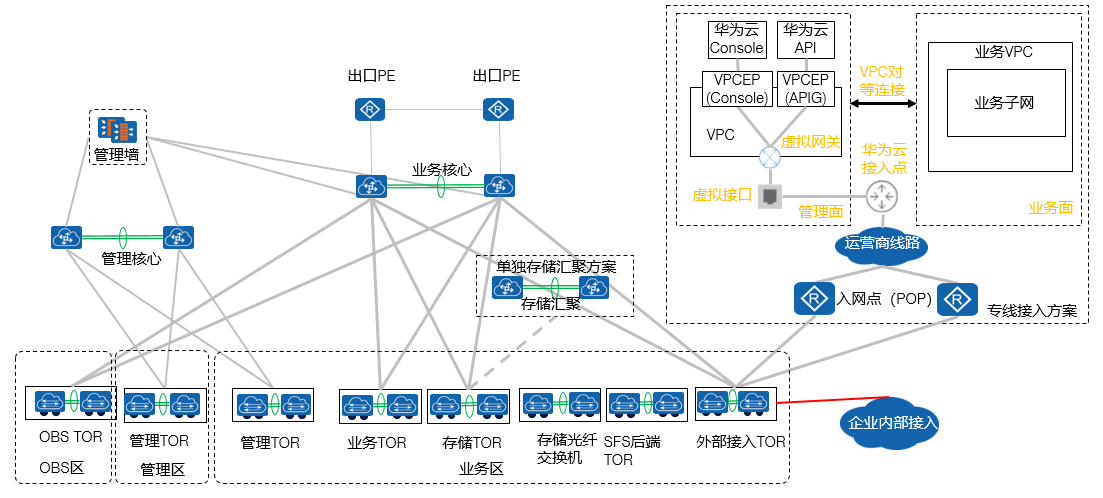

云联邦标准组网 - 仅专线连接

如果全专线,可以和华为定制接入方案

八、HCS架构设计

HCS网络平面设计

公共服务平面

External_OM(Openstack manager):HCS云平台管理平面,主要负责运维接入对接外部服务器,以及流量转发,分为了Cascading管理流量和Cascaded被管理流量。 DMZ_Service:公共服务区云服务使用的网络,包括LVS、Nginx负载均衡类服务,CloudConsole云控制服务以及相关的一些接入性控制服务。同时包含了高级云服务和底层VM互通的网络服务提供

存储平面

管理存储平面:Management_Storage_Data 业务存储平面:Service_Storage_Data

OpenStack管理平面

External_Relay_Network:租户内大网平面,主要是负责VM内部与管理侧相关服务进行通信的需求,由于在实际使用过程中,多个VPC内部的VM地址可能重叠,但是这些VM在访问公共服务以及相关的管理服务的时候,是不能使用VPC内部IP的,会导致网络冲突。所以就需要内大网平面进行NAT转换,将VPC内部的地址转换为不冲突的IP,保证每个VM的内大网地址是唯一的,这样就可以避免冲突,保证全局内大网地址唯一。内大网的分配一般来说会建议分配一个非常大的网段,尤其是在业务量比较大的情况下,因为内大网分配的IP地址是要求全局唯一的,但是内部的VM数量是非常多的。所以内大网分配的网段IP数量一定要非常多,一般建议选择10.0.0.0/10这个范围以上。

Internal_Base:内部管理平面,主要承担的是PXE流量(DHCP网卡启动),OpenStack的南向通信,代理、运维、网络配置手机、升级、告警、公共服务等相关的流量。所以Internal_base一般也建议选择一个比较大的网段,如172.16.0.0/15网段,这个网段内的IP,也是通过DHCP分配的,由OpenStack进行分配

规划规则:

单个Region内,所有网络平面的分配是不允许冲突的

多个Region的时候,建议不要选择合并设计IP,最好是分开设计,全局统一IP设计的时候,容易造成IP地址不足

针对于网络服务、VPN、专线服务等固定IP的设计,不允许冲突,不能复用,即不允许一个公网IP,即作为网络出口也作为专线接入接口,这样做容易造成网络拥塞和网络冲突

External_OM平面在进行管理的时候,必须要和BMS、存储的带外管理网络互通。其他服务也遵循这个概念,但是大数据FusionInsight HD除外。

规划的IP地址,至少要以120%的标准超分。

九、HCS故障处理

故障处理整体思路 信息收集:采集系统出现的相关的问题,告警、包括但不限于故障现象,故障时间频率,影响范围,日志(故障前的动作),故障处理进度。云平台故障信息采集主要是通过ManageOne实现,底层网络故障,是通过AutoOps实现的。CloudNetDebug可以收集网络设备的保障信息。 故障处理思路:先定位全局错误,在定位局部错误。先解决整体故障,在解决细节故障。先解决管理故障,后解决业务故障。 故障定位主要依靠于告警(警告、一般、严重、紧急)、日志(确定是否有误操作情况)、设备配置(是否出现了配置变更或硬件故障)

恢复思路: 先解决报警,根据告警代码解决相关问题 性能报障需要通过资源扩展或者是降低资源使用率进行实现 操作错误就通过反向配置恢复解决 数据配置错误可以重新进行配置 硬件设备异常根据实际硬件错误解决 根据IDC统计,在数据中心系统故障中,一般情况下,系统的问题70%左右都是由于硬件故障导致的,17%是由于配置故障出现的,只有不到3%是由于软件bug导致的,其余大部分故障原因都是由于人为因素造成。